AI は、業界、企業、消費者の體験を新しい方法で変革しています。 生成 AI モデルは推論に移行し、 エージェント型 AI は新しい結果重視のワークフローを可能にしフィジカル AI により、カメラ、ロボット、ドローン、自動車などのエンドポイントがリアルタイムで意思決定を行い、対話できるようになります。

これらのユース ケースに共通するのは、普及し、信頼性が高く、安全で、超高速な接続が必要であることです。

通信ネットワークは、フロントホール無線アクセス ネットワークを介して直接送信されるか、エンタープライズ アプリケーションによって生成されるパブリック クラウドまたはプライベート クラウドからのバックホールからの完全にスタンドアロンの AI 推論トラフィックのような新しい種類の AI トラフィックに備える必要があります。

ローカル ワイヤレス インフラストラクチャは、AI 推論を処理するのに最適な場所を提供します。 これは、通信會社 ネットワークに対する新しいアプローチである AI 無線アクセス ネットワーク (AI-RAN) の特徴です。

従來の CPU または ASIC ベースの RAN システムは、RAN のみのために設計されており、現在では AI トラフィックを処理できません。 AI-RAN は、ワイヤレスと AI のワークロードを同時に実行できる共通の GPU ベースのインフラストラクチャを提供します。これにより、ネットワークを単一目的から多目的インフラストラクチャに変え、コスト センターからプロフィット センターに変えられます。

適切な種類のテクノロジに戦略的投資を行うことで、通信會社は業界、消費者、企業にわたって AI の作成、配信、使用を容易にする、 AI グリッドへと飛躍することができます。今が通信會社にとって、中央集中的で分散されたインフラストラクチャを再利用することで、AI トレーニング (作成) と AI 推論 (配信) のためのファブリックを構築する大きな機會となります。

SoftBank と NVIDIA が AI-RANの商用化を進める

SoftBank は、NVIDIA アクセラレーション ハードウェアと NVIDIA Aerial ソフトウェアを技術基盤として活用し、神奈川県藤沢市で屋外フィールド トライアルを成功させ、AI-RAN ビジョンを現実のものにしました。

この達成は、AI-RAN の商用化に向けた大きな前進であり、テクノロジの実現性、パフォーマンス、収益化に関する業界の要件に対応する実証ポイントを提供します。

- NVIDIA のアクセラレーテッド コンピューティング プラットフォームで実行される世界初の屋外 5G AI-RAN フィールド トライアル。 これは、5G コアと統合されたフルスタックの仮想 5G RAN ソフトウェアに基づくエンドツーエンドのソリューションです。

- キャリア グレードの仮想 RAN のパフォーマンスを実現。

- AI と RAN のマルチテナントとオーケストレーションを実現。

- エネルギー効率と経済的なメリットが、既存のベンチマークと比較して検証されました。

- ?AI-RAN インフラストラクチャに統合された AI マーケットプレイスを提供する新しいソリューション。

- AI-RAN ネットワークで実行される実際の AI アプリケーションが紹介されます。

何よりも、SoftBank は、世界中に展開するために、獨自の AI-RAN 製品を商業的にリリースすることを目指しています。

他の通信事業者が今すぐ AI-RAN の導入を支援するために、SoftBank は、AI-RAN を試用するために必要なハードウェアとソフトウェアの要素で構成されたリファレンス キットを、簡単かつ迅速に提供する予定です。

エンドツーエンドの AI-RAN ソリューションとフィールド トライアルの結果

SoftBank は、NVIDIA とエコシステム パートナーのハードウェアとソフトウェア コンポーネントを統合し、キャリアグレードの要件を満たすように強化することで、AI-RAN ソリューションを開発しました。 このソリューションは、NVIDIA GH200 (CPU+GPU)、NVIDIA Bluefield-3 (NIC/DPU)、フロントホールおよびバックホール ネットワーキング用の Spectrum-X で実行される 100% ソフトウェア デファインドの完全な 5G vRAN スタックが実現します。 20 臺の無線ユニットと 5G コア ネットワークを統合し、100 臺のモバイル UE を接続します。

コア ソフトウェア スタックには、以下のコンポーネントが含まれています。

- SoftBank が NVIDIA Aerial CUDA-Accelerated-RAN ライブラリを使用して、 5G RAN レイヤー 1 のチャネル マッピング、チャネル推定、変調、前方エラー訂正などの機能を開発し、最適化しました。

- レイヤー 2 機能向け Fujitsu ソフトウェア

- コンテナーの仮想化レイヤーとしての Red Hat の OpenShift Container Platform (OCP) により、同じ基盤となる GPU コンピューティング インフラストラクチャで異なるタイプのアプリケーションが実行されます

- SoftBank が開発した E2E、AI と RAN オーケストレーター。需要と使用可能な容量に基づいて RAN と AI のワークロードのシームレスなプロビジョニングを可能にします。

基盤となるハードウェアは、NVIDIA GH200 Grace Hopper Superchip であり、分散型から集中型 RAN シナリオまで、さまざまな構成で使用できます。 この実裝では、集約された RAN のシナリオのために、1 つのラックで複數の GH200 サーバーを使用し、AI と RAN のワークロードを同時に処理します。 これは、従來の RAN 基地局を複數展開するのに相當します。

このパイロットでは、RAN のみのモードで使用された場合、各 GH200 サーバーは、100 MHz 帯域幅で 20 個の 5G セルを処理することができました。 各セルでは、理想的な條件下で 1.3 Gbps のピーク ダウンリンク性能が達成され、屋外展開ではキャリアグレードの可用性で 816 Mbps が実証されました。

AI-RAN のマルチテナントを実現

AI-RAN テクノロジの第一の原則の 1 つは、キャリアグレードのパフォーマンスを損なうことなく、RAN と AI のワークロードを同時に実行できることです。 このマルチテナントは、時間または空間のいずれかで実行でき、時間帯またはコンピューティングの割合に基づいてリソースを分割します。 また、これは、使用可能な容量に基づいて、ワークロードをシームレスにプロビジョニング、プロビジョニングの解除、シフトできるオーケストレーターの必要性も意味します。

藤沢市の実証実験では、RAN と AI ワークロード間のリソースの靜的割り當てに基づいて、GH200 上での AI と RAN の同時処理が実証されました。 (図 1)。

各 NVIDIA GH200 サーバーは、複數の MIG (マルチインスタンス GPU) で構成され、1 つの GPU を複數の獨立した GPU インスタンスに分割できます。 各インスタンスには、メモリ、キャッシュ、コンピューティング コアなど、獨自の専用リソースがあり、獨立して動作できます。

SoftBank オーケストレーターは、AI を実行するために GPU 全體または GPU の一部をインテリジェントに割り當て、RAN のワークロードを実行し、必要に応じて動的に切り替えます。 需要に基づく割り當てではなく、RAN と AI に一定の割り當てを、RAN に 60% と AI に 40% のコンピューティングを靜的に割り當てることもできます。

目標は、容量使用率を最大化することです。 AI-RAN を使用すると、通信會社は、通常の RAN のみのネットワークでの 33% の容量使用率と比較して、ほぼ 100% の使用率を実現できます。 これは、動的なオーケストレーションと優先順位付けポリシーのおかげで、ピークの RAN の負荷に対応しながら、最大 3 倍の増加です。

AI-RAN マーケットプレイスの実現

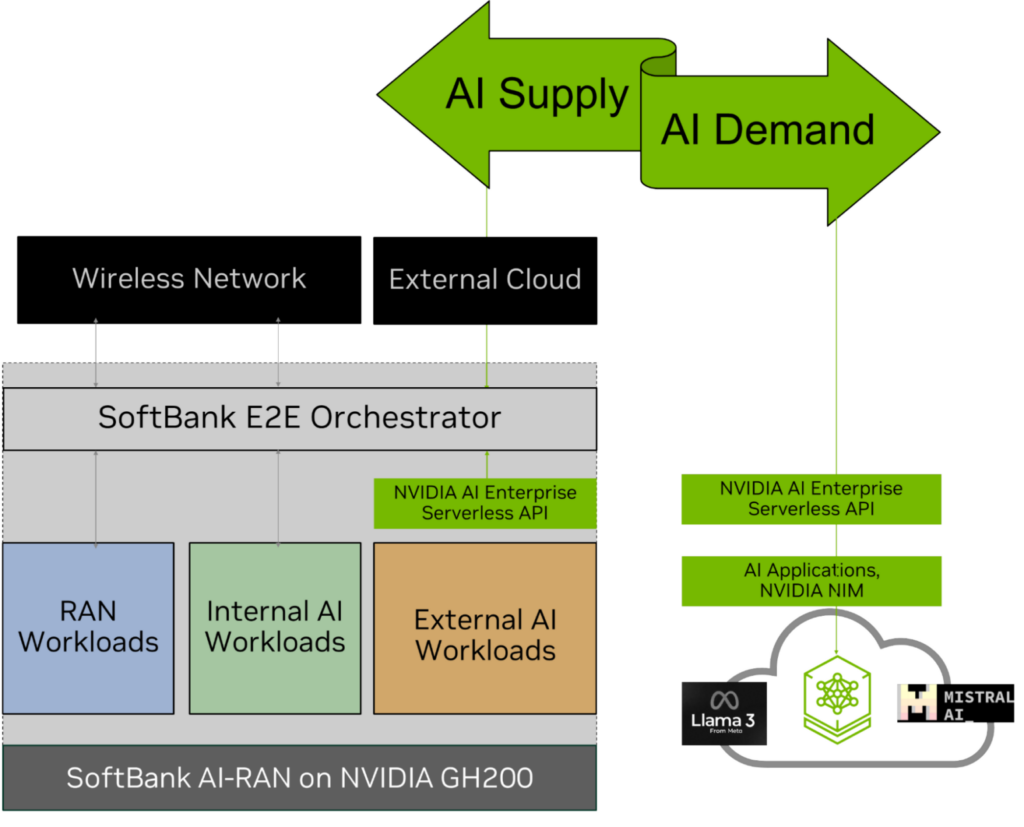

分散型 AI-RAN インフラストラクチャで AI コンピューティングの新しい機能が利用できるようになったため、この AI コンピューティングの供給に AI の需要をどのように取り込むかという疑問が生じます。

この問題を解決するために、SoftBank は、NVIDIA AI エンタープライズ を活用したサーバーレス API を使用して、セキュリティ、拡張性、信頼性を備えて AI-RAN で AI ワークロードを展開し、管理しました。 NVIDIA AI エンタープライズのサーバーレス API は、AI-RAN インフラストラクチャでホストされ、SoftBank E2E AI-RAN オーケストレーターと統合されています。 同じ API を実行するパブリック クラウドまたはプライベート クラウドに接続し、コンピューティングが利用可能になったときに、外部の AI 推論ジョブを AI-RAN サーバーに割り當てます (図 2)。

このソリューションにより AI マーケットプレイスが実現し、ソフトバンクはローカライズされた低遅延の安全な推論サービスを提供できるようになります。 また、特に外部の AI 推論の仕事のために、通信會社が AI 配信グリッドになるのを支援する上で AI-RAN の重要性も実証し、新しい収益の機會を作ります。

AI-RAN アプリケーションが紹介

この屋外の試用では、SoftBank が開発した新しいエッジ AI アプリケーションがライブ AI-RAN ネットワークでデモンストレーションされました。

- ?5G を介した自動運転車のリモート サポート

- 工場出荷時のマルチモーダル

- ロボティクス アプリケーション

5G を介した自動運転車のリモート サポート

自動運転の社會的実裝の重要な要件は、車の安全性と運用コストの削減です。

藤沢市の実証実験では、ソフトバンクが自動運転車を実演し、前方カメラの映像を 5G で AI-RAN サーバーにホストされた AI ベースの遠隔サポート サービスに中継した。 マルチモーダル AI モデルは、ビデオ ストリームを分析し、リスク評価を行い、5G を介したテキストを使用して自動運転車に推奨のアクションを送信しました。

これは、説明可能な AI の例でもあります。リモート サポートのための要約されたテキストとログを通じて、自動運転車のすべての動作を監視し、説明することができました。

工場出荷時のマルチモーダル

このユース ケースでは、ビデオ、オーディオ、センサー データを含むマルチモーダル入力が、5G を使用して AI-RAN サーバーにストリーミングされます。 AI-RAN サーバーでホストされる、複數の LLM、VLM、検索拡張生成 (RAG) パイプライン、NVIDIA NIM マイクロサービスは、これらの入力を統合し、5G を使用するユーザーがチャット インターフェイスを介して情報にアクセスできるようにするために使用されます。

これは、工場の監視、建設現場の検査、同様の複雑な屋內および屋外の環境に最適です。 このユース ケースでは、エッジ AI-RAN がデータ アクセスと分析をローカル、安全、プライベートに保つことで、ローカル データの主権を実現する方法を示しています。これは、ほとんどの企業にとって必須の要件です。

ロボティクス アプリケーション

SoftBank は、5G を介して接続されたロボットのエッジ AI 推論の利點を実証しました。 ロボドッグは、聲と動きに基づいて人間を追うようにトレーニングされました。

このデモでは、AI 推論がローカル AI-RAN サーバーでホストされたときのロボットの応答時間と、セントラル クラウドでホストされたときの応答時間を比較しました。 その違いは明白でした。 エッジ ベースの推論 ロボドッグは、人間の動きを即座に追跡しましたが、クラウド ベースの推論ロボットは、追いつくのに苦労しました。

Aerial RAN Computer-1 で AI-RAN のビジネス ケースを高速化

AI-RAN ビジョンは業界で受け入れられていますが、GPU 対応インフラストラクチャのエネルギー効率と経済性、特に従來の CPU および ASIC ベースの RAN システムとの比較は依然として重要な要件です。

AI-RAN のこのライブ フィールド トライアルにより、SoftBank と NVIDIA は、GPU 対応の RAN システムが実現可能で、高性能であることを実証しただけでなく、エネルギー効率と経済的な収益性も大幅に向上していることを実証しました。

NVIDIA は最近、次世代 NVIDIA Grace Blackwell Superchip をベースにした Aerial RAN Computer-1 を推奨 AI-RAN 展開プラットフォームとして発表しました。 目的は、GB200-NVL2 をベースとした SoftBank 5G vRAN ソフトウェアを NVIDIA GH200 から NVIDIA Aerial RAN Computer-1 に移行することです。これは、コードがすでに CUDA に対応しているため、移行が容易です。

また、GB200-NVL2 を使用すると、AI-RAN で利用可能なコンピューティング能力が 2 倍になります。 AI 処理機能は、以前の H100 GPU システムと比較して、Llama-3 推論が 5 倍、データ処理が 18 倍、ベクトル データベース検索が 9 倍に改善されます。

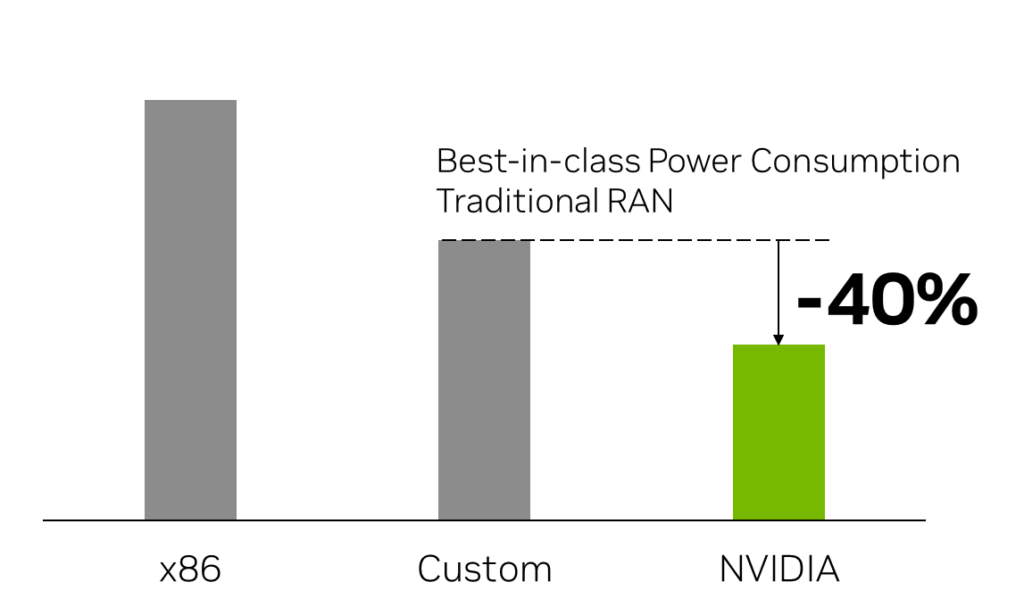

この評価のために、ターゲットの展開 プラットフォーム、GB200 NVL2 をベースとする Aerial RAN Computer-1、最新世代の x86 とクラス最高のカスタム RAN 製品ベンチマークを比較し、以下の結果を検証しました。

- 高速化された AI-RAN は、クラス最高の AI パフォーマンスを提供します

- 高速化された AI-RAN は持続可能な RAN

- 高速化された AI-RAN は、非常に収益性が高い

高速化された AI-RAN は、クラス最高の AI パフォーマンスを提供します

100% AI のみのモードでは、各 GB200-NVL2 サーバーは、毎秒 25,000 トークンを生成します。これは、サーバー 1 臺の収益化可能なコンピューティングの利用率が 20 ドル/時間、またはサーバーあたりの月15,000 ドルに換算します。

現在のワイヤレス サービスのユーザー 1 人の平均収益 (ARPU) は、國によっては月 5 ~ 50 ドルの範囲であることに留意して、AI-RAN は、RAN のみのシステムよりも數倍の高い、數十億ドル規模の AI 収益の機會を提供します。

使用されるトークン AI ワークロードは、Llama-3-70B FP4 であり、AI-RAN がすでに世界で最も高度な LLM モデルを実行できることを実証します。

高速化された AI-RAN は持続可能な RAN

100% RAN のみのモードでは、GB200-NVL2 サーバーの電力パフォーマンスは、ワット/Gbps で以下の利點があります。

- 今日、クラス最高のカスタム RAN のみのシステムと比較して、消費電力が 40% 削減

- x86 ベースの vRAN と比較して、消費電力が 60% 削減

比較のために、これはすべてのプラットフォームで同じ數の 100 MHz 4T4R セルと、100% RAN のみのワークロードを想定しています。

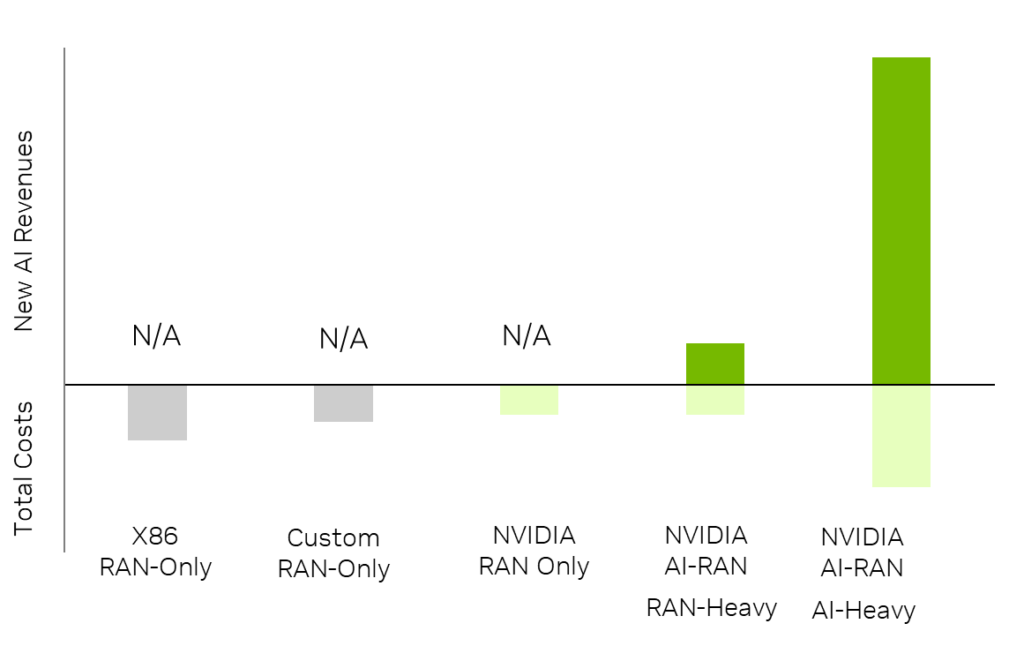

高速化された AI-RAN は、非常に収益性が高い

この評価のために、比較された 3 つのプラットフォームのそれぞれで RAN 展開の共通のベースラインとして、東京都の 1 地區を 600 セルでカバーするシナリオを使用しました。 次に、RAN のみから RAN を重くするまたは AI を重視するまで、AI と RAN のワークロード分布の複數のシナリオを調べました。

AI が多いシナリオ (図 4) では、RAN が 3 分の 1、AI ワークロードが 3 分の 2 を分散しました。

- NVIDIA GB200 NVL2 をベースとする高速化された AI-RAN インフラストラクチャへの資本支出 (CapEx) 投資額の1ドルに対して、通信會社は 5 年間で 5 倍の収益を生み出すことができます。

- ROI の観點から、資本支出と運用支出のすべてのコストを考慮して、投資全體は 219% のリターンを実現します。これは、現地のコスト想定を使用しているため、もちろん SoftBank 特有のものです。

| 33% AIと 67% RAN | 67% AI と 33% RAN | |

| CapEx 1 ドルあたりの収益 $ | 2x | 5x |

| ROI % | 33% | 219% |

RAN を多用するシナリオでは、3 分の 2 を RAN、3 分の 1 を AI ワークロード分散に使用し、NVIDIA アクセラレーション AI-RAN の CapEx で割った収益は 2 倍になり、SoftBank のローカル コスト想定を使用して 5 年間で 33% の ROI が得られることがわかりました。

RAN のみのシナリオでは、NVIDIA Aerial RAN Computer-1 はカスタム RAN のみのソリューションよりもコスト効率が高く、無線信號処理にアクセラレーテッド コンピューティングを使用する大きな利點となります。

これらのシナリオから、AI を多用するモード RAN を多用するモードの両方で、RAN のみのソリューションと比較して、AI-RAN が高い収益性が明らかになります。 本質的に、AI-RAN は、従來の RAN をコスト センターから利益センターに変革します。

AI の使用量の増加により、サーバーあたりの収益性が向上します。 RAN のみの場合でも、AI-RAN インフラストラクチャは、カスタム RAN のみのオプションよりもコスト効率が高くなります。

収益と TCO の計算に使用された主な前提條件には、次のものが含まれます。

- 各プラットフォームのプラットフォーム、サーバー、ラックのそれぞれの數は、同じ周波數である 4T4R で 600 セルをデプロイする共通のベースラインを使用して計算されます。

- 総所有コスト (TCO) は、5 年以上で計算されており、ハードウェア、ソフトウェア、vRAN、AI の運用コストが含まれています。

- ?新しい AI 収益の計算には、GB200 NVL2 AI パフォーマンス ベンチマークに基づいて、サーバーあたりの時間 20 ドルを使用しました。

- 運用支出コストは、日本の現地の電力コストに基づいており、世界的に拡張することはできません。

- ROI % = (新しい AI 収益 – TCO) / TCO

AI の収益の向上、エネルギー効率、収益性、収益性のこの検証により、このテクノロジの実現性、パフォーマンス、経済的なメリットに疑いの余地はありません。

今後、Vera Rubin などの NVIDIAスーパーチップの各世代が指數関數的に増加することで、これらのメリットはさらに桁違いに増大し、待望の通信ネットワークのビジネス変革が可能になります。

將來を見據える

SoftBank と NVIDIA は、AI-RAN の商業化と新しいアプリケーションを生み出すために、継続的に協力しています。 この契約の次のフェーズでは、スペクトル効率を向上させる AI-for-RAN の取り組みと、ファインチューニングとテストのためにデジタル ネットワークをシミュレートする NVIDIA Aerial Omniverse デジタル ツインの取り組みが含まれます。

NVIDIA AI Aerial は、世界中の通信事業者とエコシステム パートナーが、アクセラレーテッド コンピューティングとソフトウェア デファインド RAN + AI のパワーを使用して、5G および 6G ネットワークを変革する基盤を築きます。 NVIDIA Aerial RAN Computer-1 と AI Aerial ソフトウェア ライブラリを使用して、獨自の AI-RAN 実裝を開発できるようになりました。

NVIDIA AI エンタープライズ は、多くの NVIDIA ソフトウェア ツールキットが使用されたこのトライアルからも明らかなように、AI-RAN でホスト可能な通信事業者向けの新しい AI アプリケーションの作成にも貢獻しています。これには、生成 AI 向けの NIM マイクロサービス、RAG、VLM、ロボティクス トレーニング用の NVIDIA Isaac、NVIDIA NeMo、RAPIDS、推論用の NVIDIA Triton、AI ブローカー用サーバーレス API が含まれます。

通信業界は、AI サービス プロバイダーになる大きなチャンスの最前線に立っています。 AI-RAN は、ワイヤレス ネットワークの新しい基盤としてアクセラレーテッド コンピューティングを使用することで、世界中の通信會社にとってこの新しい変革を促進できます。

この発表は、AI-RAN テクノロジの畫期的な瞬間であり、その実現性、キャリアグレードのパフォーマンス、優れたエネルギー効率、経済的な価値を証明しました。 NVIDIA の高速化された AI-RAN インフラストラクチャに投資された資本支出 1 ドルは、6G に対応しながら、5 倍の収益を生み出します。

AI 収益化への取り組みは、今すぐ始められます。