機械學習 (ML: Machine learning) セキュリティは、機械學習システムおよびその上に構築されるデータのセキュリティに焦點を當てた新しい分野です。情報セキュリティとデータ サイエンスの領域が交差する所に位置します。

最先端の技術が進歩している一方で、機械學習システムのセキュリティとテストのための明確な入門および學習パスは存在しません。では、関心のある実務者は、どのように機械學習セキュリティ技術のスキルアップを始めれば良いのでしょうか。arXiv で関連記事を読むこともできますが、具體的な手順となるとどうでしょう?

コンテストは、1 つの有望な機會を提供します。NVIDIA は最近、ハッキングとセキュリティのカンファレンス「DEF CON 30」において、革新的な ML セキュリティ コンテストの運営を支援しました。AI Village が主催したこのコンペティションには、3,000 人以上の參加者が集まりました。この大會は、參加者同士、そして ML セキュリティの分野を紹介することを目的としています。この大會は、參加者にとって、機械學習のセキュリティ スキルを向上させる貴重な機會となりました。

NVIDIA AI Red Team と AI Village

NVIDIA が提供する機械學習のセキュリティを積極的にテストし評価するために、NVIDIA AI Red Team は拡大してきました。このチームは経験豊富なセキュリティとデータの専門家たちで構成されていますが、業界全體で ML セキュリティの人材を育成する必要性を認識していました。より多くの露出と教育により、データとセキュリティの実務者は、展開された機械學習システムのセキュリティを向上させることができるかもしれません。

AI Village は、セキュリティとプライバシーにおける人工知能 (AI: Artificial Intelligence) の教育に取り組んでいるデータ サイエンティストとハッカーたちのコミュニティです。このコミュニティは、毎年 DEF CON でイベントを開催しています。

NVIDIA AI Red Team と AI Village は共同で、DEF CON 30 において、情報セキュリティ コミュニティと共に機械學習セキュリティのコンテストに參加しました。このトピックは、多くの參加者にとって新しい経験になったかもしれません。AI Village のメンバーは、ML セキュリティの知識の要素を教え、テストすることを目的とした課題を作成しました。NVIDIA に加え、AWS Security、Orang Labs、NetSec Explained のメンバーが參加しました。

AI Village Capture the Flag コンテスト

Capture the Flag (CTF) コンテストには、複數の課題があります。競技者はこれらの課題をプレイし、成功した課題に対して旗 (フラッグ) を集めます。この旗には、チャレンジのレベルに応じてさまざまなポイントが設定されています。競技者は、最も多くのポイントを集めることで勝利します。

このおなじみの形式を念頭に、AI Village と NVIDIA AI Red Team は The AI Village CTF @ DEFCON を構築しました。主催者は、Kaggle と提攜し、機械學習コミュニティでおなじみのプラットフォームを使用しました。情報セキュリティの CTF と同様に、Kaggle コンテストは、ML 研究者が個別の問題で競爭する形式を提供します。

Kaggle との提攜により、コンピューティングとデータ ホスティング、ドキュメントとスコアリングを組み合わせた、柔軟で拡張性の高いなプラットフォームが提供されました。チャレンジ サーバーは既に終了していますが、チャレンジの説明を見ることができます。

競技者は、AI Village から必要な最小限の追加インフラで、簡単に課題に取り組み進めることができたとレポートしています。さらに、Kaggle には熟練のデータ サイエンティストや機械學習エンジニアが多數おり、セキュリティ分野の探求に熱中していました。また、Kaggle は、継続的なサポートと $25,000 の賞金を惜しみなく提供してくれました。このイベントにとって、これ以上のパートナーはいないでしょう。

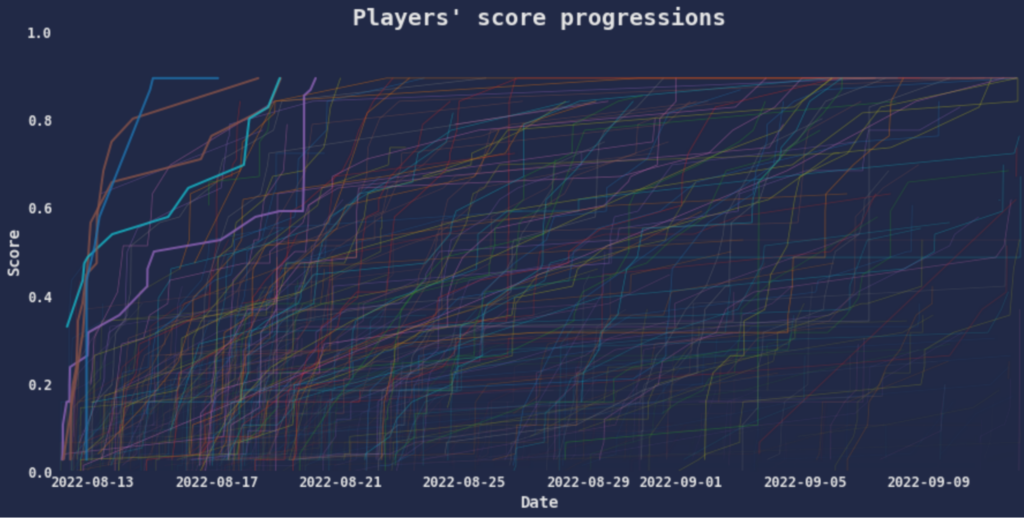

1 か月に及ぶコンテストの期間中、3,000 名以上の參加者が 22 の課題をハッキングしました。これは予想をはるかに超えるものであり、初めて Kaggler になった人からグランド マスターになった人まで、70 か國以上の參加者がいました。このイベントは、従來の情報セキュリティと機械學習のコミュニティを結びつけ、ML セキュリティという新しい領域から様々な課題に取り組むことに成功したのです。

競技者は、オープン ソース リサーチ、マスキング、次元削減など、一般に入手可能なツールや革新的な技術を使ったアプリケーションを使用しました。その過程で、學術文獻にある攻撃もよく再実裝していました。

1 つの課題が未解決のままだったため、誰かがリーダーボードのトップに立つチャンスが常にあったのです。コンテストの最後の 2 週間、Kaggle Discussion Board とAI Village Discord は、殘された未解決の課題についての理論や探究心で盛り上がっていました。主催者は、ブザーを鳴らすリーダーボードのシフトを 1 時間ごとにチェックしていました。課題の解決をご確認ください。

推論チャレンジ

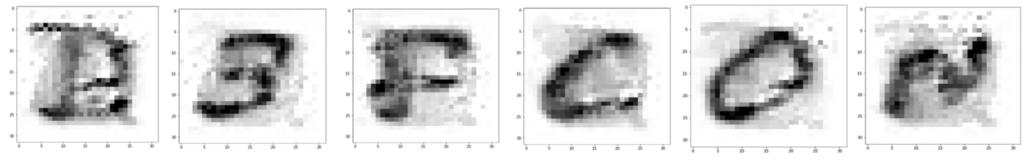

推論チャレンジでは、參加者は學習サンプルを特定するためにメンバーシップ推論攻撃を実行する必要がありました。參加者は、Image Classifier への API アクセス権しか持っていませんでした。成功した場合、競技者は旗の文字を示す畫像を識別することができます。

競技者の中には、ピクセル値を並べ替えてランダムに畫像を生成することを選択し、問題を事実上総當たり攻撃した競技者がいました。また、學習データに標準的なデータセットが含まれていると仮定し、EMNIST をソース データとして使用し、オープン ソース データを活用した競技者もいました。また、Adversarial Robustness Toolbox を利用し、図 2 に示すような出力を行った競技者もいました。

どのような方法であれ、成功した挑戦者には、D3FC0N と綴られた旗が與えられるのです。このDEF CON カンファレンス名の leetspeak エンコーディングは、カンファレンスの Web サイトのいくつかの場所で使用されました。

Crop2 チャレンジ

研究や既成概念にとらわれない発想が、CTF の課題解決に役立つことは多々あります。例えば、今回のコンテストで未解決だった課題は Crop2 でした。Crop2 では、參加者は切り取られた汚染モデルを與えられ、汚染されたサンプルを (ある誤差の範囲內で) 作成する必要がありました。參加者は、1 つの學習データのサンプルを用いて作業を行いました (図 3)。

この問題は、効率的で標準的なアルゴリズムによる解がない難問です。畫像のすべてのピクセルと、3 つのカラー チャンネルで可能なすべてのピクセル値を考えると、検索スペースは 8,000 億以上の選択肢に爆発的に膨れ上がります。その代わり、競技者はリバース エンジニアリング、オープン ソースの研究、仮定を組み合わせて、組み合わせの數を減らすことができます。

コンテスト終了後、主催者から Crop2 チャレンジの解決に役立つヒントが與えられました。重要なヒントには、オープン ソースの研究を使って、ピクセルの色が matplotlib のデフォルトのカラーマップによって生成されている可能性が高いと判斷したことが含まれていました。これにより、探索スペースが數十萬単位で大幅に縮小されました。

それらの情報に基づいた仮定を行うことで、ある競技者が最終的に Crop2チャレンジの解決に辿り著くことができました。優秀なハッカーには粘り強さがあります。コンテストが終わった後も、この競技者たちは與えられたヒントでひたすら解いていました。あるヒントをきっかけに、その競技者は「9 色でしか使えないんだ、今まで 1,600 萬色もいじっていたのに。これで探索スペースはなんとかなる。」と気づいたそうです。

競技者メモ

競技者のメモの中から、特におすすめをご紹介します。

- Chris Deotte – Kaggle Grandmasters of NVIDIA (KGMoN) のメンバーによる、これらのソリューションは非常によく整理され、文書化されています。特に Secret Sloth をお勧めします。

- Eric Bouteillon – 「Excuse Me」で 1 文字ずつ旗が表示されるのを見てみましょう。また、MATH チャレンジの解き方の違いにもご注目ください。シルエット スコアという言葉を聞いたことがありますか?

- John MacGillivray – John は Hotterdog モデルが MobileNet に基づいていることを推理し、オフライン攻撃を可能にしました。素晴らしいノウハウです。

- Fournierp – 推論チャレンジのモデル反転について、ゼロから書き上げた包括的な記述です。また、Adversarial Robustness Toolbox で MIFace を確認することもできます。

- Eoin O – Crop2 チャレンジをどのように解決できたか、詳細をご覧ください。3,000 名以上の參加者が、1 か月以上に渡り解決に挑みました。大會終了の翌日、主催者はいくつかのヒントを発表しました。數時間後にはそれは解決されました。コンテスト終了後、すべての競技者が Discord と Kaggle ディスカッション ボードでコラボレーションしているのを見るのは素晴らしいことでした。

まとめ

AI Village CTF @ DEF CON 30 コンテストでは、セキュリティとデータの両方の専門家が、機械學習のセキュリティ技術を向上させることに大きな意欲を持っていることが示されました。ML システムがますますセキュリティ上重要な文脈で展開されるようになるにつれ、専門家を育成し、セキュリティ開発、展開、テストのためのツールや手法を開発することが不可欠になります。

NVIDIA は、組み込みデバイス、ノート PC から、スーパーコンピューターやクラウドまで、AI のための堅牢で安全なエコシステムでイノベーションを推進し続けていきます。この取り組みの一環として、私たちの AI Red Team は、ML セキュリティの研究とテストを社內で強化し、業界全體でセキュリティの実踐を確立していきます。今後、コンテストやワークショップの開催、研究やセキュリティ ツールのリリースも予定しています。參加にご興味のある方は、threatops@nvidia.com (英語のみ) までお問い合わせください。

関連情報

- Learning to Defend AI Deployments Using an Exploit Simulation Environment (エクスプロイト シミュレーション環境を用いた AI 展開の防御學習)

- Introduction to Adversarial Robustness (敵対的ロバスト性の紹介)

- Adversarial Machine Learning Reading List (敵対的機械學習リーディング リスト)

- HackingNeuralNetworks GitHub レポジトリ

- Coefficient GitHub レポジトリ

- HackThisAI GitHub レポジトリ

翻訳に関する免責事項

この記事は、「Improving Machine Learning Security Skills at a DEF CON Competition」の抄訳で、お客様の利便性のために機械翻訳によって翻訳されたものです。NVIDIA では、翻訳の正確さを期すために注意を払っておりますが、翻訳の正確性については保証いたしません。翻訳された記事の內容の正確性に関して疑問が生じた場合は、原典である英語の記事を參照してください。