Cloud Services

2024 年 10 月 28 日

NVIDIA GH200 Superchip が、Llama モデルとのマルチターン インタラクションの推論を 2 倍高速化

NVIDIA GH200 Grace Hopper Superchip を活用し、システム スループットを犠牲にすることなく、x86 ベースの NVIDIA H100 サーバーと比較して、Llama 3 70B モデルでマルチターンでユーザーとのやり取りする場合、TTFT を最大 2 倍に向上させる方法について解説します。

2 MIN READ

2024 年 6 月 7 日

NVIDIA NIM で LoRA アダプター群をシームレスにデプロイ

LoRA の概要と、LoRA でファインチューニングされたモデルをデプロイする 2 つの方法、また LoRA アダプター群のヘテロジニアスな LoRA デプロイを可能にして、混合バッチ推論リクエストを可能にするためのアプローチについても説明します。

3 MIN READ

2024 年 4 月 15 日

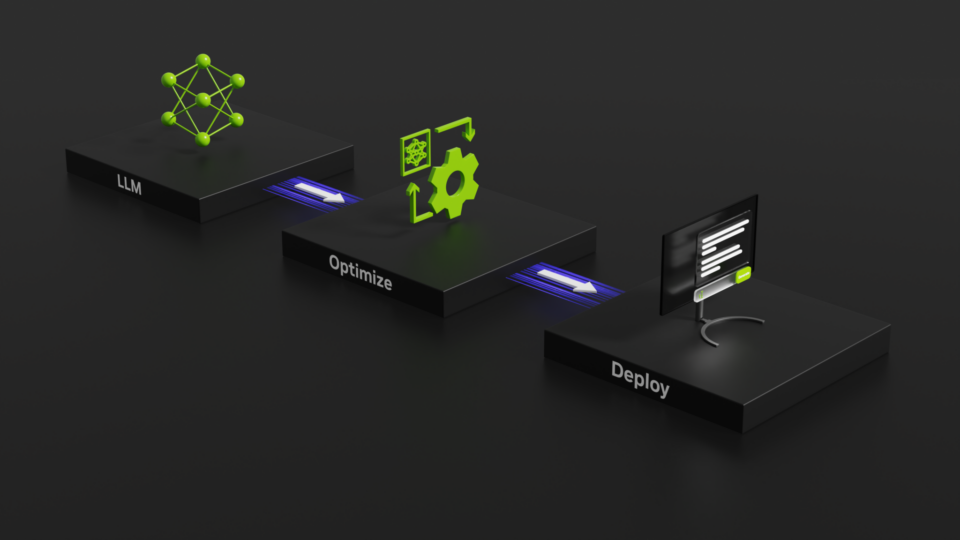

本番環境への AI モデルのデプロイを効率化する NVIDIA NIM

NVIDIA AI Enterprise に含まれる NVIDIA NIM は、AI を活用するエンタープライズ アプリの開発と、AI モデルを本番環境にデプロイするための合理化された道のりを提供します。

2 MIN READ

2024 年 3 月 18 日

NVIDIA NeMo マイクロサービスでカスタム生成 AI 開発が簡単に

NeMo マイクロサービスである NVIDIA NeMo Curator、NVIDIA NeMo Customizer、NVIDIA NeMo Evaluator の早期アクセス プログラムが開始しました。

2 MIN READ

2024 年 3 月 18 日

NVIDIA NeMo Retriever で企業データを実用的なインサイトに変える

さまざまなデータ プラットフォーム企業が、NVIDIA と協力して NeMo Retriever を活用し、データを価値あるビジネス インサイトに変換している事例についてご紹介します。

2 MIN READ

2024 年 3 月 18 日

RAG アプリケーションを 4 つのステップでパイロットから本番環境に移行する方法

セキュリティ、サポート、安定性を提供する NVIDIA AI Enterprise は、企業による RAG アプリケーションのパイロットから本番環境への移行を支援します。

3 MIN READ

2024 年 3 月 14 日

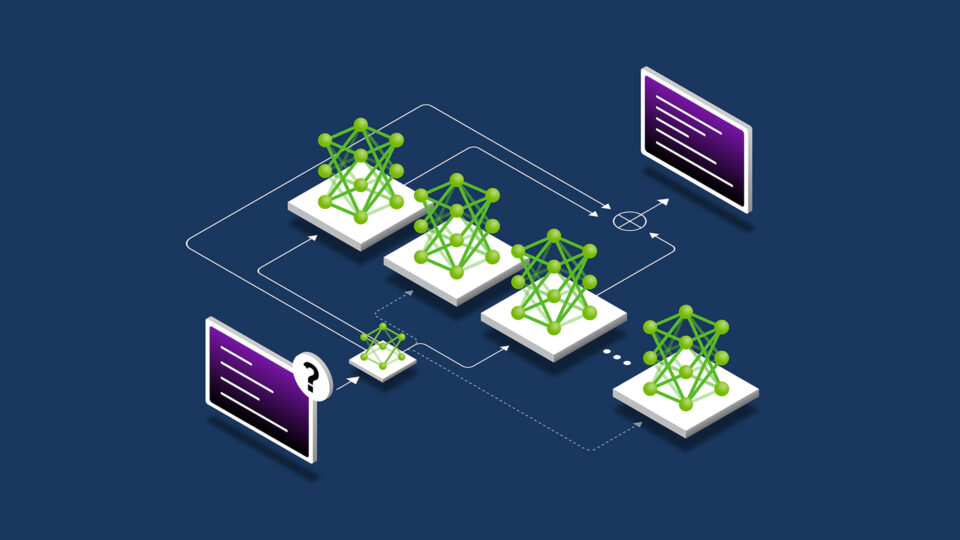

LLM アーキテクチャにおける Mixture of Experts の適用

Mixture of Experts (MoE) 大規模言語モデル (LLM) アーキテクチャは、GPT-4 などの商用の LLM と…

4 MIN READ

2023 年 11 月 15 日

LLM テクニックの習得: LLMOps

この投稿では、生成 AI アプリ開発の概要を説明し、GenAIOps と LLMOps の概念を定義し、それらを MLOps と比較します。

3 MIN READ

2023 年 9 月 12 日

実務で使える生成 AI を NVIDIA AI Enterprise 4.0 で実裝しビジネスを強化

NVIDIA AI Enterprise 4.0 は、生成 AI でイノベーションを起こそうとしている企業向けに、本番環境に対応したサポート、管理性、セキュリティ、信頼性を提供し、さまざまな側面から開発を加速します。

1 MIN READ

2023 年 9 月 8 日

NVIDIA TensorRT-LLM が NVIDIA H100 GPU 上で大規模言語モデル推論をさらに強化

大規模言語モデルは驚くべき新機能を提供し、AI で実現できる領域を拡大しています。しかし、その大きなサイズと特有の実行特性は、

3 MIN READ

2023 年 7 月 7 日

NVIDIA と Run:ai で學習させた AI モデルをあらゆるクラウドへ展開

最新のコンピュート リソースにアクセスし、世界中の顧客を一貫してサポートし、コストを最適化するために、

2 MIN READ