醫學成像中的合成數據提供了許多好處,包括在真實數據有限的情況下,以多樣化和逼真的圖像增強數據集的能力,從而減少與注釋真實圖像相關聯的成本和人工。此外,合成數據還為使用敏感患者數據提供了一種合乎道德的替代方案,有助于在不損害患者隱私的情況下進行教育和培訓。

這篇文章介紹了 MAISI,一個NVIDIA AI Foundation 模型用于 3D 計算機斷層掃描(CT)圖像生成。MAISI 的首要目標是通過提供一種可靠高效的方法來生成高質量合成圖像,以用于各種研究和臨床應用,從而徹底改變醫學成像領域。通過克服數據稀缺和隱私問題的挑戰,MAISI 旨在提高醫學成像數據的可訪問性和可用性。

該模型可以生成高分辨率合成 CT 圖像和相應的分割掩模,最多 127 個解剖類別(包括骨骼、器官和腫瘤),同時實現 512×512×512 的標志性體素尺寸和 1.0×1.0×1.0 mm3的間距。關鍵應用包括數據增強,即生成真實世界的醫學成像數據,以補充受到隱私問題或罕見的數據集。

概述

NVIDIA 的 DLMED 研究團隊專注于 3D 醫學圖像生成建模中的高分辨率、詳細背景,這種方法不僅豐富了數據集,而且提高了醫學成像領域中其他機器學習模型的性能。另一個主要應用程序是節省注釋工作,基于用戶定義的類(圖像、標簽)生成對簡化了創建帶有注釋的合成醫學圖像的過程,為收集和注釋真實醫學數據的勞動密集型任務提供了一種經濟高效的替代方案。

此外,MAISI 模型還解決了道德數據使用的問題,為使用敏感的患者數據提供了一種負責任的替代方案,因為生成的圖像與真實的個人不符,這種能力對于生成用于教育目的的各種醫學圖像是非常寶貴的,幫助受訓人員和醫學生在不必訪問機密患者記錄的情況下進行診斷。

基礎壓縮網絡

為了生成高分辨率的 3D 圖像,研究團隊訓練了一個基礎壓縮模型,該模型旨在有效地將 CT 和磁共振成像(MRI)數據壓縮到壓縮的特征空間中。這種變分自動編碼器(VAE)模型接受 CT 或 MRI 圖像作為輸入,并產生特征表示輸出,該輸出作為后續潛在擴散模型的基礎輸入。該模型的訓練方案涵蓋了來自不同解剖區域的大量 CT 和 MRI 圖像,這些圖像具有不同的體素間距。

這種廣泛的訓練賦予了模型強大的適應性,使其能夠應用于不同的數據集,而不需要額外的微調。同時,一個精心訓練的解碼器模型可以從生成的特征集中準確重建高分辨率圖像。

基礎擴散網絡

潛在擴散模型(LDMs)已成為生成機器學習中的一個強大工具,尤其是用于合成 3D 醫學圖像。這些模型通過從潛在空間內的隨機分布中迭代地去除噪聲來發揮作用,該過程有效地使 LDM 能夠學習訓練數據的底層數據分布,然后生成新穎的高保真樣本。

在 3D 醫學成像領域,LDM 在生成解剖準確和多樣化的圖像方面具有巨大的前景,因為通過學習數據分布,該模型可以生成反映真實世界變化的合成圖像。

我們的 LDM 是使用大規模、高分辨率 CT 數據集進行訓練的,我們還引入了基于身體區域的條件作為額外的特征嵌入,這些區域包括頭部、胸部、腹部和下半身。在推斷階段,用戶可以指定他們希望為其生成 CT 圖像的身體區域,生成的 CT 圖像的兩個具體示例如圖 1所示。

ControlNet 支持額外的條件控制

ControlNet 是一個支持各種空間上下文的框架,作為 Stable Diffusion 等擴散模型的附加條件,以便在文本到圖像的擴散模型中添加條件控制。它是在論文,將條件控制添加到文本到圖像的擴散模型中中介紹的。有了 ControlNet,用戶可以更好地控制生成過程,輸出可以使用不同的空間上下文進行定制,如深度圖、分割圖、涂鴉、關鍵點等。

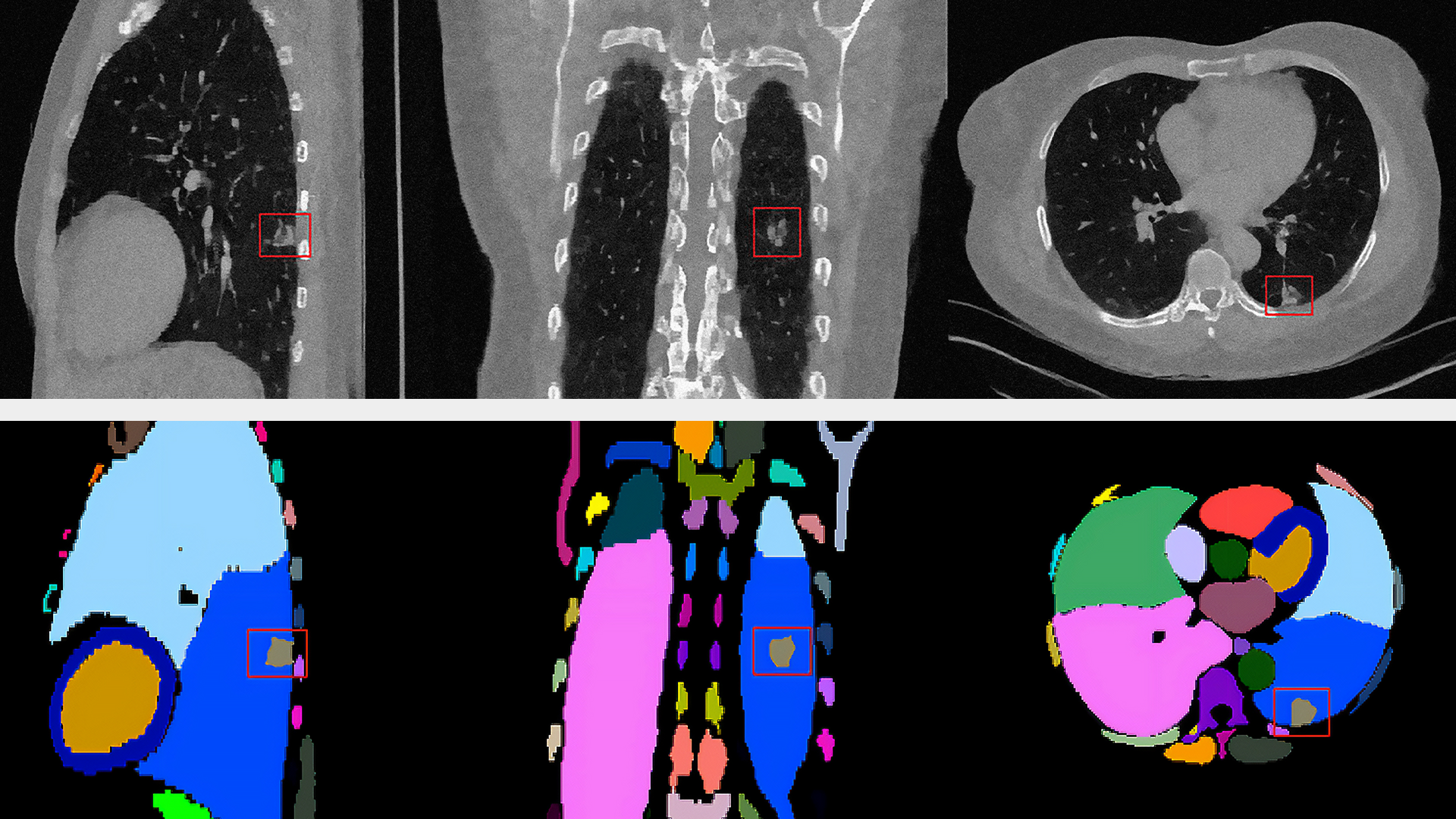

具體而言,研究團隊利用 ControlNet 將包括 127 個解剖結構在內的器官分割圖作為基礎擴散模型的額外條件,以促進 CT 圖像的生成。圖 2 顯示了一個典型的生成 CT 圖像及其相應的分割條件。

這是通過使用“零卷積”層連接可訓練副本和鎖定副本來實現的。零卷積層使模型能夠保留預訓練的基礎擴散模型已經學習到的語義,同時使可訓練副本能夠學習任務所需的特定空間條件。

績效評估

我們的團隊使用多個數據集對基礎擴散模型和 ControlNet 進行了全面評估。這確保了對許多不同身體區域的廣泛覆蓋。

圖像質量

最初,我們使用提供的模型權重,通過比較模型生成的圖像與其他基線方法生成的圖像,來評估圖像的質量。我們使用了表 1 所示的胸部 CT 圖像生成和實際胸部 CT 數據集。

根據Fréchet 起始距離(FID)評分,我們的方法在性能上比以前的方法表現出了優越。此外,我們生成的圖像在外觀上與真實圖像非常相似。

| FID (Average) ↓ | MSD Task 06* | LIDC-IDRI | TCIA | |

| Real | MSD Task 06 | – | 3.987 | 1.858 |

| LIDC-IDRI | 3.987 | – | 4.744 | |

| TCIA | 1.858 | 4.744 | – | |

| Synthesis | HA-GAN | 98.208 | 116.260 | 98.064 |

| MAISI | 19.008 | 31.370 | 20.338 | |

*用于模型訓練的數據集

隨后,我們使用我們的數據集重新訓練了幾種最先進的基于擴散模型的方法。表 2 和表 3 中的結果表明,對于我們的數據集和未發現的數據集(autoPET 2023),我們的方法始終優于以前的方法。

| Method | FID (XY Plane) ↓ | FID (YZ Plane) ↓ | FID (ZX Plane) ↓ | FID (Average) ↓ |

| DDPM | 10.031 | 36.782 | 43.109 | 29.974 |

| LDM | 12.409 | 19.202 | 22.452 | 18.021 |

| HA-GAN | 10.439 | 10.108 | 10.842 | 10.463 |

| MAISI | 1.225 | 2.846 | 2.854 | 2.308 |

?

| Method | FID (XY Plane) ↓ | FID (YZ Plane) ↓ | FID (ZX Plane) ↓ | FID (Average) ↓ |

| DDPM | 18.524 | 23.696 | 25.604 | 22.608 |

| LDM | 16.853 | 10.191 | 10.093 | 12.379 |

| HA-GAN | 17.432 | 10.266 | 13.572 | 13.757 |

| MAISI | 14.165 | 5.770 | 8.510 | 9.481 |

圖 3 顯示,我們的方法生成的圖像顯示出顯著增強的細節和更準確的全局解剖結構。

生成模型最重要的應用之一是合成新數據,以用于模型訓練中的數據擴充。我們可以通過評估包含合成數據的影響來評估生成圖像的質量。我們采用了Auto3DSeg管道,這是一種在MONAI中開發醫學圖像分割解決方案的自動管道,并從頭開始訓練每個分割模型,以減少隨機性通過五倍交叉驗證。

有兩組實驗:

- 真實:正常的模型訓練是在真實數據上進行的。

- 真實+合成:在訓練過程中,真實數據和合成數據以相等的比例組合,以顯示合成數據對數據擴充的效果。

如表 4 所示,所有合成數據在五種腫瘤類型中都對測試集的最終性能產生了積極影響(約 2.5%~4.5%的改善)。這些結果表明,使用合成數據訓練的模型具有更好的可推廣性。

| Experiment | Dataset | Tumor Type | Dice Score | Improvement |

| Real | MSD Task 06 | Lung Tumor | 0.581 | – |

| Real + Synthetic | 0.625 | 4.5% | ||

| Real | MSD Task 10 | Colon Tumor | 0.449 | – |

| Real + Synthetic | 0.490 | 4.1% | ||

| Real | In-House Bone Lesion | Bone Lesion | 0.504 | – |

| Real + Synthetic | 0.534 | 3.0% | ||

| Real | MSD Task 03 | Hepatic Tumor | 0.662 | – |

| Real + Synthetic | 0.687 | 2.5% | ||

| Real | MSD Task 07 | Pancreatic Tumor | 0.433 | – |

| Real + Synthetic | 0.473 | 4.0% |

定性評估

圖 4 顯示了三例異常病例的定性評估,可以看出 MAISI 在正常器官和異常腫瘤區域都能產生良好的 CT 生成質量,如每個子圖的方框所示。我們的結果表明 MAISI 能以高保真度有效地描繪異常組織邊界,證明了其在醫學成像中基于分割掩模條件捕捉復雜細節方面的穩健性,MAISI 有可能有效地增強生成的 CT 圖像的多樣性和真實性用于數據增強目的。

值得注意的是,在每種情況下,MAISI 都準確地模擬了異常腫瘤區域的出現,并為豐富腫瘤形態和空間分布變化的數據集開辟了可能性,這些發現突出了 MAISI 作為增強醫學成像數據集的強大工具的潛力,從而提高了機器學習模型在臨床應用中的穩健性和通用性。

總結

MAISI 是一個最先進的基礎人工智能模型,用于生成具有相應標簽的 3D 高分辨率合成醫學圖像,以解決數據限制、降低注釋成本和維護患者隱私。憑借其實現高質量分辨率和分割 127 個解剖類別的能力,MAISI 有望在醫學成像領域產生重大影響,將 MAISI 生成的合成數據納入訓練分割模型已經證明了顯著的性能改進,為臨床應用中提高魯棒性和泛化能力鋪平了道路。

探索使用 MAISI 為您的項目生成合成數據的潛力,請加入早期訪問計劃。

鳴謝

所有合著者都希望指出,他們對本文的研究和本文的寫作做出了同等的貢獻。

?