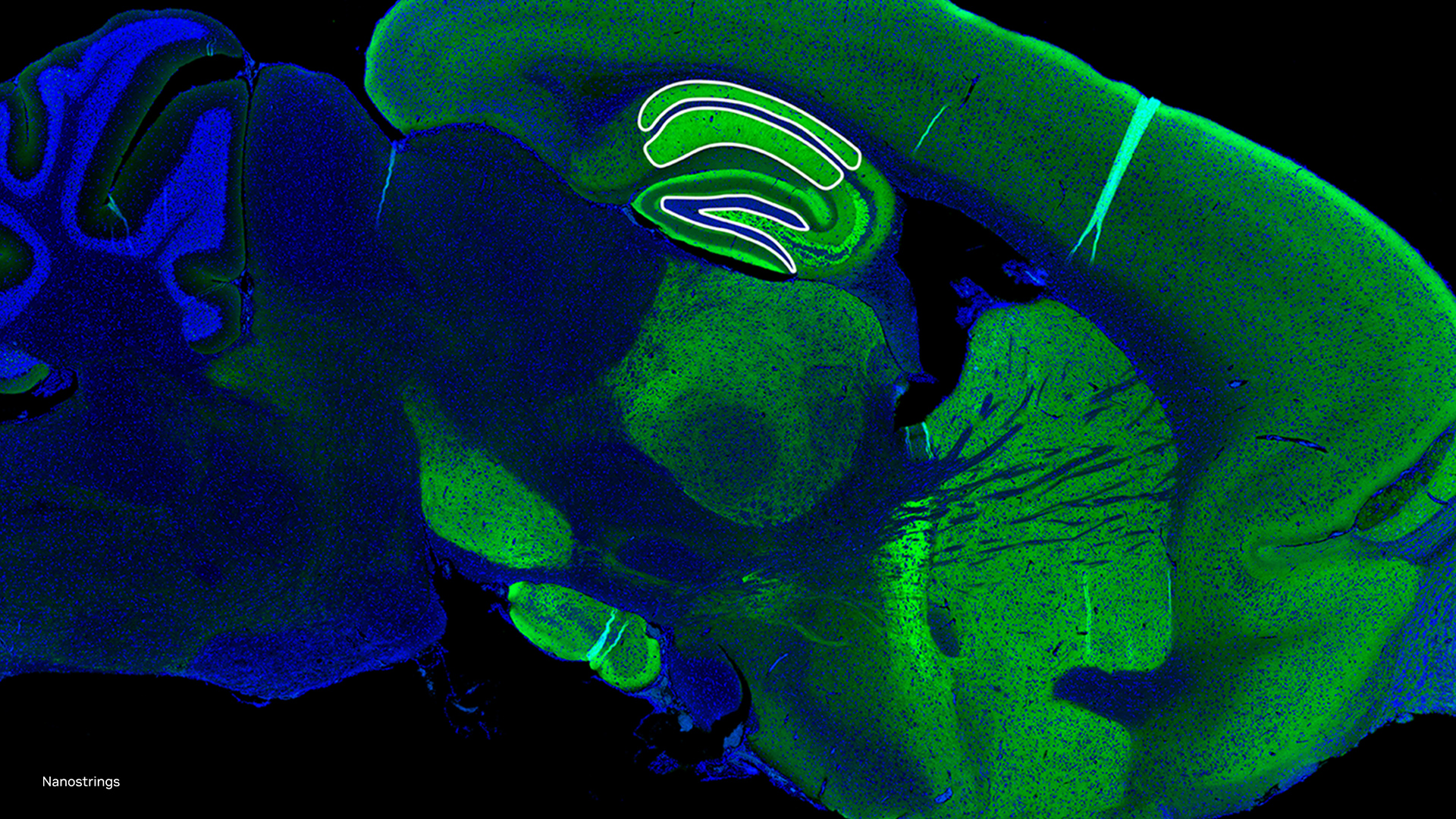

基因組學研究人員使用不同的測序技術來更好地理解生物系統,包括單細胞和空間組學。與從細胞層面查看數據的單細胞不同,空間組學考慮了數據的位置,并考慮到用于分析的空間環境。

隨著基因組學研究人員尋求在組織層面跨多個組學對生物系統進行建模,空間組學領域正在推動一種新的范式,即在空間環境中詢問細胞的方法。大多數這些空間組學方法都依賴于成像,以便在不分離細胞與組織的情況下查看標記 (如光標記)。

這些標簽可以應用于不同的分子 (例如 RNA 和蛋白質),并保留其起源細胞的空間信息以及細胞在組織中的位置。這種成熟的細胞動力學建模方法正在推動對發展和疾病的新理解,并標志著研究人員激動人心的范式轉變。

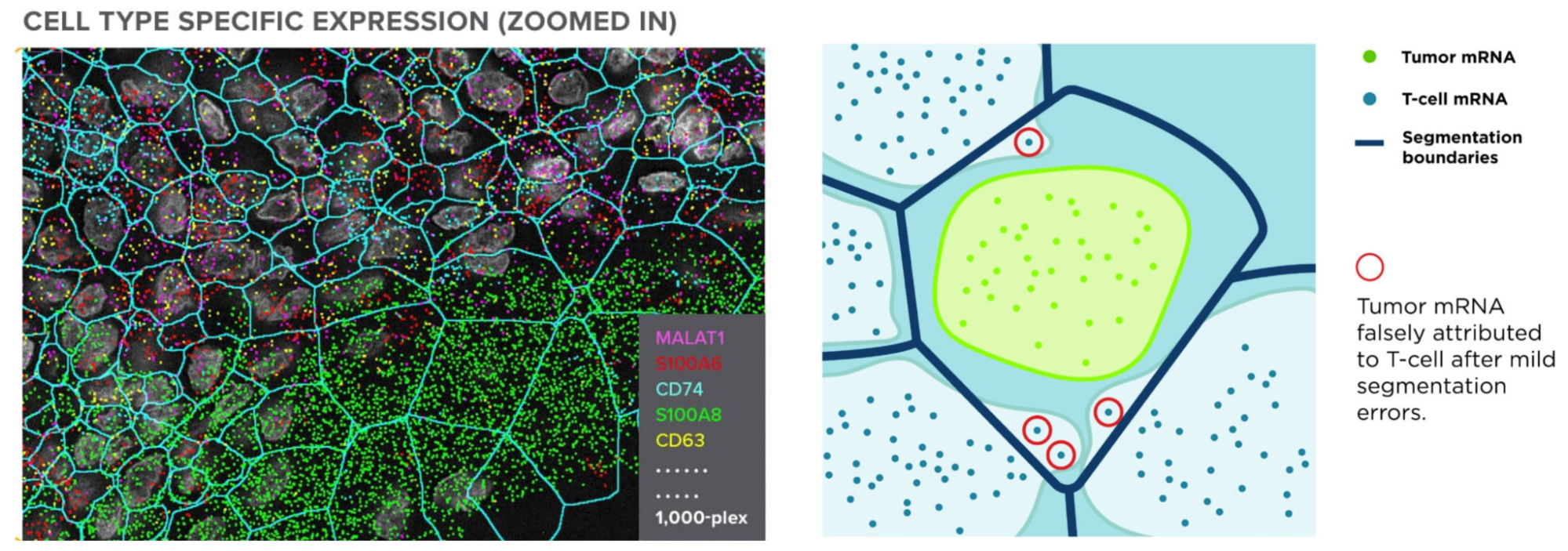

NanoString 等空間組學提供商利用 NVIDIA GPU 并加速其 CosMx SMI 設備上的計算,以應對這些挑戰。空間組學技術 (CosMx 空間分子成像) 現在可以對細胞和組織內的整個轉錄組成像,以前所未有的密度和規模生成數據 (約 150 TB/cm2)。這些數據將在轉變我們對健康和疾病的理解方面發揮關鍵作用,從根本上加速藥物研發和空間診斷。

“實際上,探索這些圖像的真實信息內容需要生成式 AI,”他補充道,“我們很高興能繼續在數據到信息流程的各個層面上深化與 NVIDIA 的合作。我們邀請所有 AI 社區加入我們的這場生命科學空間生物學革命。”

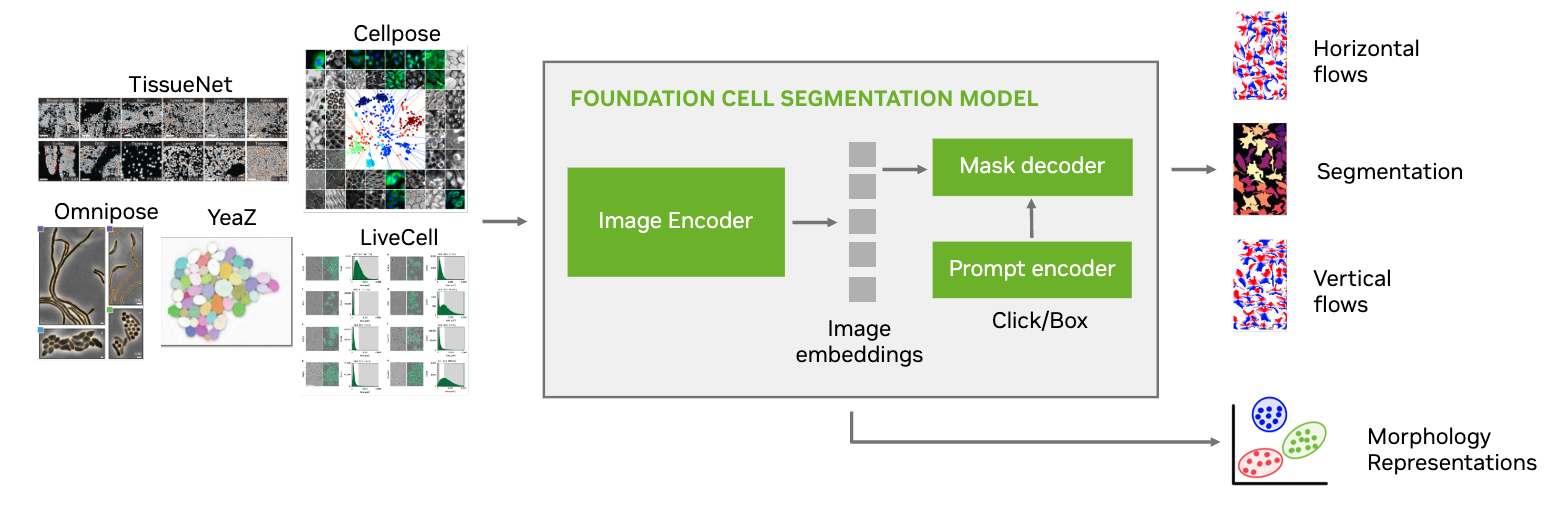

本文介紹了 NVIDIA AI 基礎模型 在細胞分割的 VISTA-2D 中的應用。這些模型可在各種細胞成像輸出上進行訓練,包括明場、相位對比、光、共聚焦或電子顯微鏡檢查。

用于細胞分割的 VISTA-2D NVIDIA AI 基礎模型?

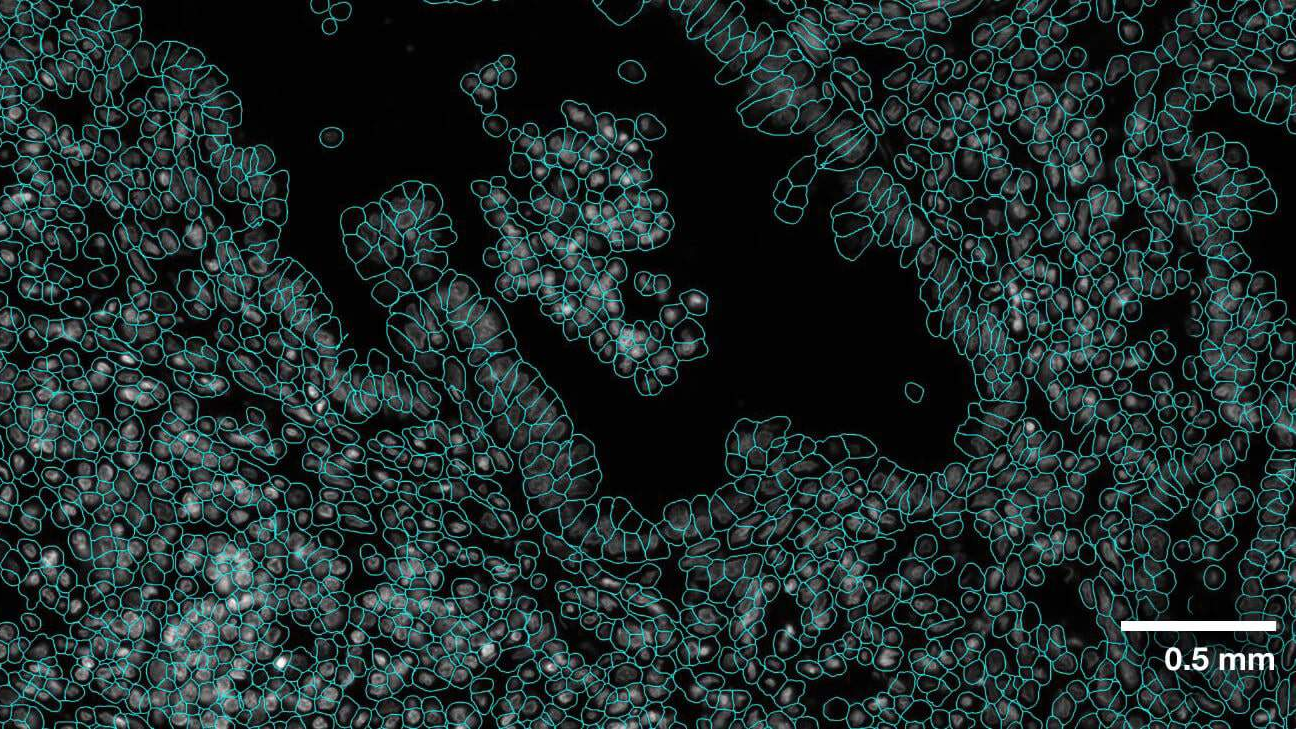

分析這些空間組學方法的圖像的最重要步驟之一是細胞分割。隨著標簽的表達和計數,將這些標記歸功于正確的細胞對于獲得準確的結果至關重要。這取決于正確繪制的細胞邊界。這不僅對下游的所有結果至關重要,而且也是一項非凡的任務,需要識別大量不同的細胞類型 (每種類型都有自己的形態),并在數萬到數十萬個細胞中實現自動化。

VISTA-2D 利用 Transformer 網絡架構在后臺工作,并結合 Meta 的 Segment Anything 模型 (SAM) 預訓練權重,以提高性能結果。VISTA-2D 與廣泛的預處理和后處理流程結合,以有效訓練任何給定類型的數據。這提供了基于實例的高分辨率分割,并可與細胞形態學和基因微擾任務進一步配對。VISTA-2D 的網絡架構包含約 1 億個訓練超參數,使其具有可調整性和可擴展性,以實現快速細胞分割。

模型亮點?

- 基于 Transformer 的強大深度學習算法

- 與專業模型相比的通用模型

- 支持多種數據集源和文件格式

- 集合支持多種成像數據模式

- 多 GPU 和多節點訓練支持

VISTA-2D 是一種通用的細胞分割管線,與之前的文獻中提出的專業模型相比,該管線旨在處理多種類型的細胞。訓練管線基于 MONAI 生態系統,并使用行業級代碼實踐。它還包括對多 GPU 的訓練支持,如果訓練數據集足夠大,則可以擴展到多節點環境。

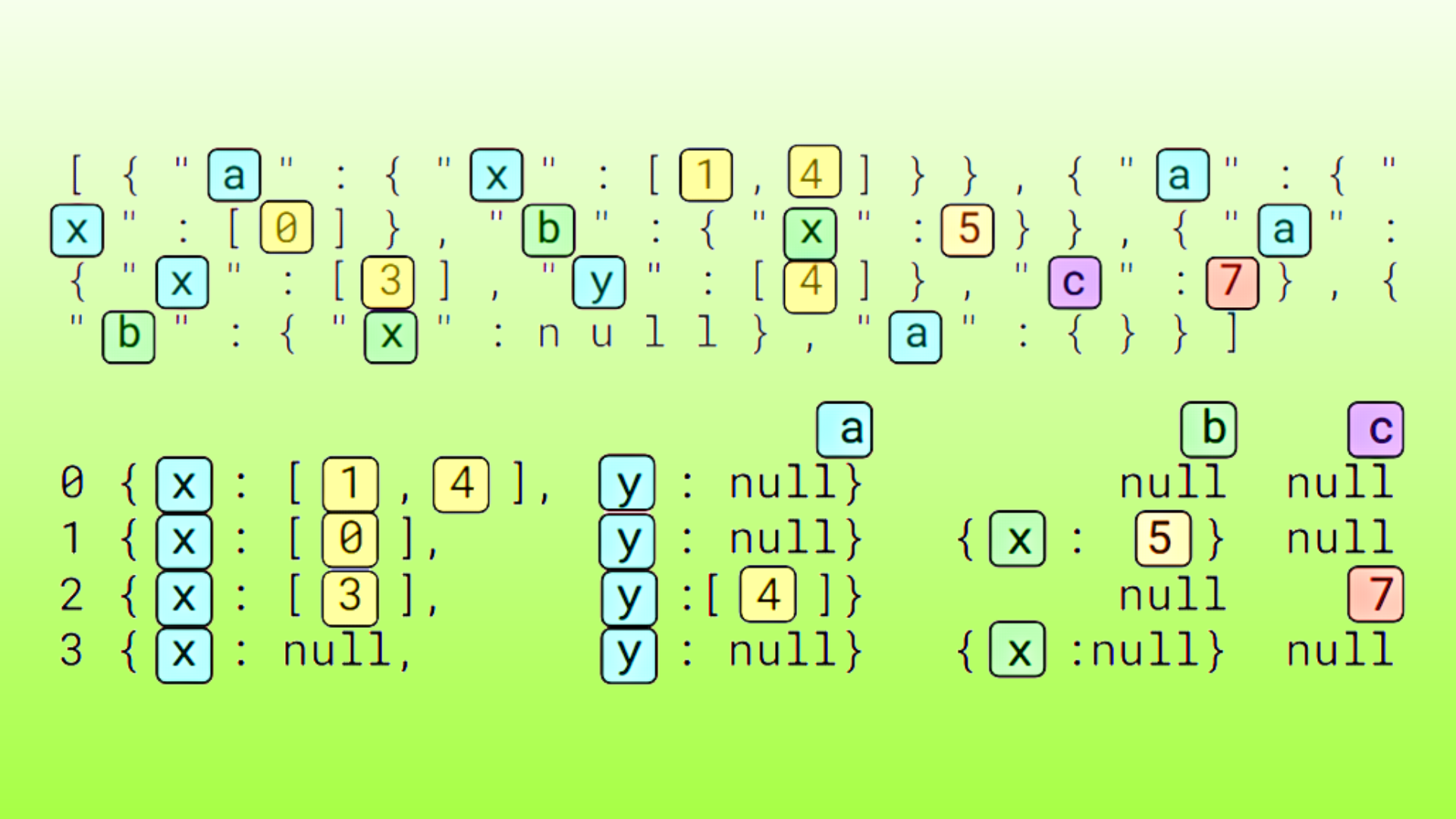

VISTA-2D 訓練流程還可以整合來自多個來源、不同成像模式和平臺的數據集,訓練過程旨在平衡所有數據集來源的影響。

VISTA-2D 工作流的獨特之處在于,它影響了預處理和后處理數據所需的轉換,其中多個因素會影響性能。例如,垂直和水平梯度流動使網絡能夠在單元的不同實例和形狀之間進行傳播。

該模型還不包含推理時超參數,此類超參數已在之前的知名方法 (例如 CellPose) 中找到。例如,需要在推理期間指定單元的直徑大小。

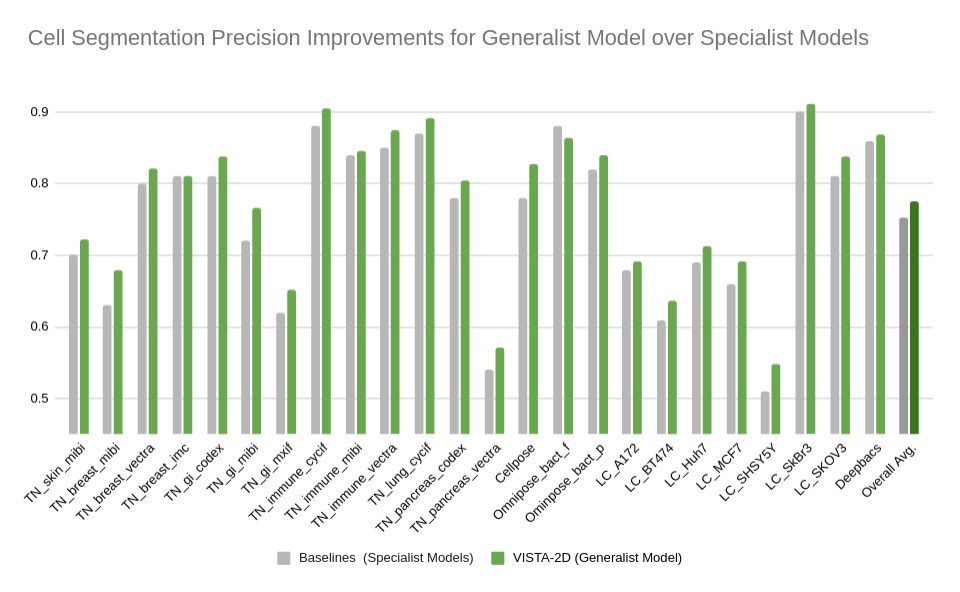

基準測試數據集的性能?

對包含多個公共數據集的 VISTA-2D 模型進行了廣泛的評估,例如 TissueNet、LIVECell、OmniposeDeepBacs、Cellpose 等。為了訓練通用型 VISTA-2D 模型,我們共收集了約 15000 張帶注釋的細胞圖像,以覆蓋各種不同類型的細胞,這些細胞是通過各種成像采集類型獲得的。VISTA-2D 模型可針對各種采集進行通用和靈活的訓練,并且可以在用戶的自定義數據集上進行訓練,最多可支持三個通道。

該實驗的基準測試結果在已由數據集貢獻者定義的每個公開數據集的保留測試集上執行。在評估性能時,使用了 IoU 值為 0.5 時成熟的平均精度標準指標。除了僅在特定數據集或數據子集上訓練的專業 VISTA-2D 模型之外,還報告了基準測試結果與文獻中找到的最佳數字的比較。

結果表明,與基于 Transformer 的網絡架構相比,基于 Transformer 的網絡架構不僅可以實現更高的精度,還可以使用更少的訓練數據,并通過生成的嵌入生成有關細胞形態的潛在新見解。有關更多信息,請參閱 Cellpose 2.0 的論文。

總結?

細胞分割是分析從空間組學技術獲得的圖像的關鍵前奏步驟之一。VISTA-2D 是用于細胞分割的 NVIDIA AI 基礎模型,可以在明場、相位對比、光、共聚焦或電子顯微鏡下進行訓練。VISTA – 2D 具有約 1 億個訓練超參數的網絡架構,具有適應性、快速性和可擴展性。

要試用使用 MONAI 服務的 VISTA-2D 訓練管線,請 加入搶先體驗計劃。

如需了解更多信息,請點播觀看以下 NVIDIA GTC 2024 會議:

- Kimberly Powell 從 NVIDIA 提出:醫療保健行業正在采用生成式 AI,成為大型科技產業之一

- 使用 Parabricks 的 GPU 加速基因組學簡介,由 NVIDIA 的 Harry Clifford 主持。

- 首次使用 CosMx-SMI 對組織進行完整轉錄組成像:有史以來收集的高密度數據集 與 NanoString 的 Joseph Beecham 合作。

?