在大規模生產中部署人工智能支持的服務,如基于語音的助手、電子商務產品推薦和呼叫中心自動化,是一項挑戰。在降低運營成本的同時提供最佳的最終用戶體驗需要考慮多個因素。其中包括底層基礎設施的組成和性能、基于用戶需求擴展資源的靈活性、集群管理開銷和安全性。

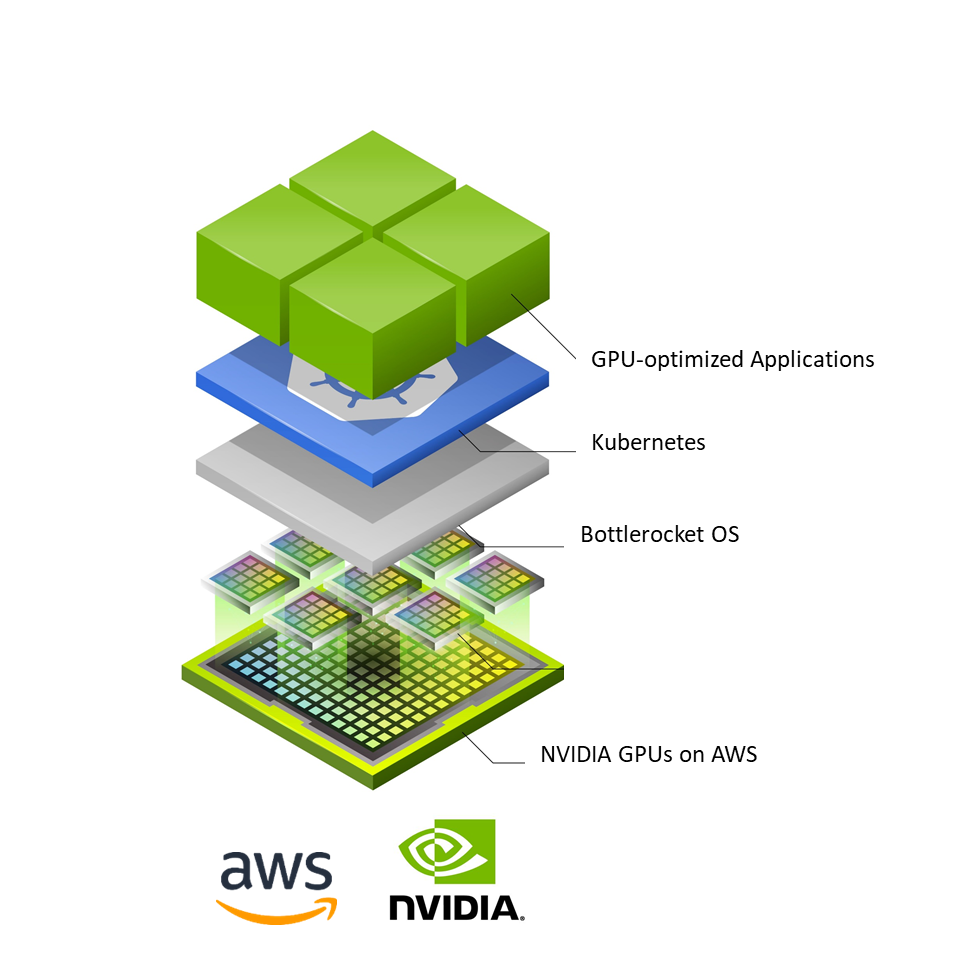

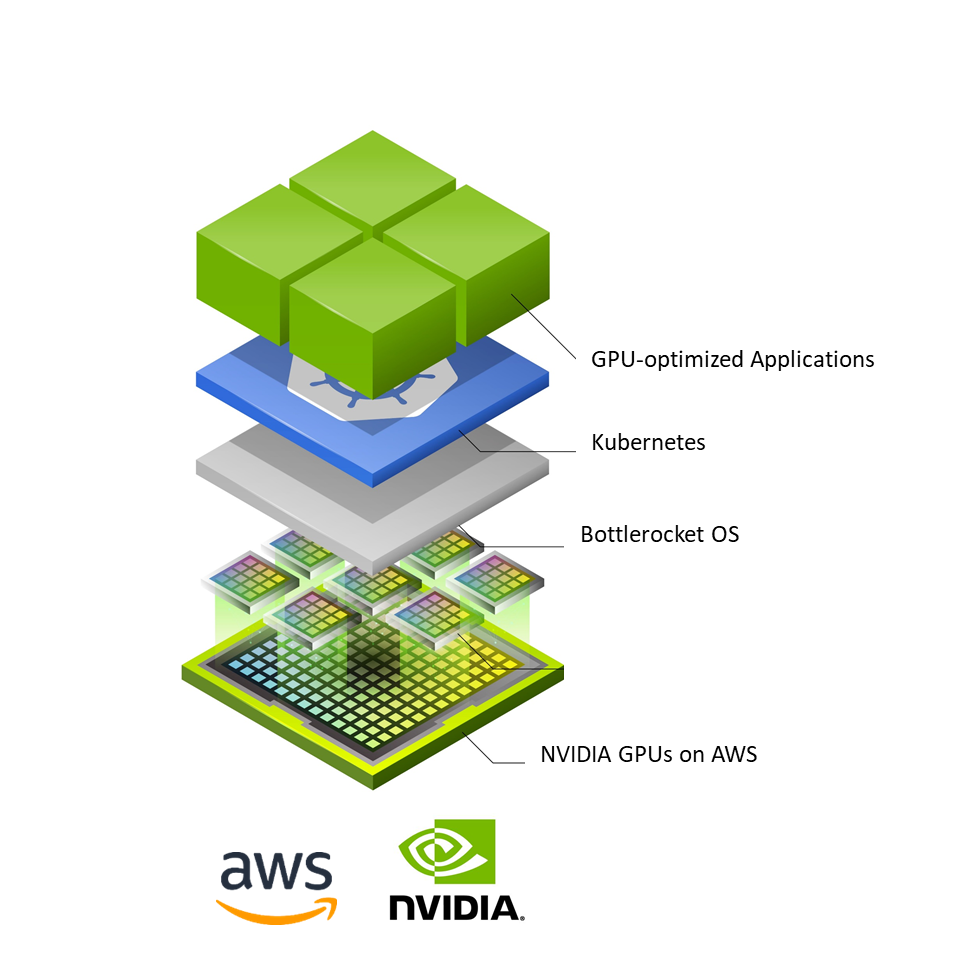

為了應對大規模部署人工智能的挑戰,企業 IT 團隊已采用 Kubernetes ( K8s )進行容器編排和 NVIDIA 加速計算,以滿足生產人工智能部署的性能需求。此外,人們越來越關注操作系統( OS )在生產基礎設施中的作用。生產環境的主機操作系統對安全性、資源利用率以及調配和擴展額外資源所需的時間有直接影響。隨著用戶需求的增加,這會影響用戶體驗、安全性和部署成本。

Botterocket :基于 Linux 的容器優化操作系統

Bottlerocket 是 AWS 開發的基于 Linux 的最小開源操作系統,專門為運行容器而構建。它非常強調安全性,只包括運行容器的基本軟件。

這減少了攻擊面和漏洞的影響,從而減少了滿足節點合規性要求的工作量。此外, Bottlerocket 的最小主機占用空間有助于提高節點資源利用率和引導時間。

對 Bottlerocket 的更新只需一步,必要時可以回滾。這將降低錯誤率,并改善容器應用程序的正常運行時間。它們還可以使用容器編排服務(如 Amazon 彈性庫伯內特斯服務( EKS )和 Amazon 彈性容器服務( ECS ))實現自動化。

在 NVIDIA GPU 支持的 Amazon EC2 實例中使用瓶裝火箭

AWS 和 NVIDIA 已經合作,使 Bottlerocket 能夠支持所有由 NVIDIA 供電的系統 Amazon EC2 實例 包括 P4d 、 P3 、 G4dn 和 G5 。這種支持將 NVIDIA 驅動的 GPU 實例的計算能力與容器優化操作系統的優勢結合起來,可以在 K8s 集群上大規模部署 AI 模型。

其結果是增強了安全性和更快的啟動時間,尤其是在運行人工智能工作負載時,實時擴展其他基于 GPU 的實例。

對 NVIDIA GPU 的支持以 GPU 優化的 AMI 的形式提供。這包括 NVIDIA 驅動程序、 K8s GPU 設備插件,以及內置在基礎映像中的 containerd 運行時。

AMI 提供了提供和注冊自我管理節點的一切, NVIDIA 支持的 GPU 實例和 Amazon EKS 集群的虛擬操作系統。

此外,您還可以利用 AWS 市場上的 NVIDIA NGC 目錄 中的 NVIDIA 優化軟件,這是一個用于預訓練模型、腳本、掌舵圖以及各種 AI 和 HPC 軟件的中心。

對于 AWS 上的人工智能推理部署,您可以利用 NVIDIA Triton 推理服務器 .使用開源推理服務軟件在任何 CPU 或 CPU 基礎設施上部署來自多個框架的經過培訓的人工智能模型,包括 TensorFlow 、 TensorRT 、 PyTorch 、 ONNX 、 XGBoost 和 Python 。

從 AWS 了解更多關于 NVIDIA GPU 瓶裝火箭支持的信息。

?