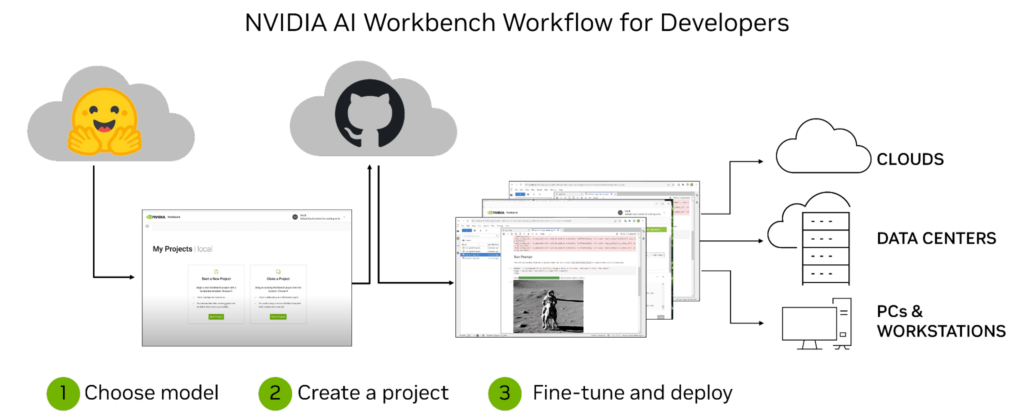

開發自定義 生成式人工智能 模型和應用程序是一段旅程,而不僅僅是一個目標。這個過程從選擇一個預訓練的模型開始,例如 大語言模型,出于探索的目的——開發人員通常希望針對他們的特定用例調整該模型。第一步通常需要使用可訪問的計算基礎設施,如 PC 或工作站。但隨著訓練工作的增加,開發人員可能需要擴展到數據中心或云中的額外計算基礎設施。

這個過程可能會變得極其復雜和耗時,尤其是在嘗試跨多個環境和平臺進行協作和部署時。NVIDIA AI Workbench 通過提供用于管理數據、模型、資源和計算需求的單一平臺,有助于簡化流程。這使得開發人員能夠無縫協作和部署,快速開發具有成本效益的可擴展生成人工智能模型。

什么是 NVIDIA AI Workbench ?

NVIDIA AI Workbench 是一個統一、易于使用的開發工具包,用于在 PC 或工作站上創建、測試和自定義預訓練的 AI 模型。然后,用戶可以將模型擴展到幾乎任何數據中心、公共云或 NVIDIA DGX Cloud。它使各級開發人員能夠快速輕松地生成和部署具有成本效益和可擴展性的人工智能模型。

安裝后,該平臺為容器化開發環境提供管理和部署,以確保無論用戶的機器如何,一切都能正常運行。AI Workbench 與以下平臺集成:GitHub,Hugging Face 和 NVIDIA NGC,以及自托管注冊表和 Git 服務器。

用戶可以在 JupyterLab 和 VS Code 中自然開發,同時以高度的再現性和透明度管理各種機器的工作。擁有 NVIDIA RTX PC 或工作站的開發人員還可以在本地系統上啟動、測試和微調企業級生成人工智能項目,并在擴展時訪問數據中心和云計算資源。

企業可以將 AI Workbench 連接到 NVIDIA AI Enterprise,以加速采用生成人工智能,并為生產中的無縫集成鋪平道路。當 AI Workbench 可用于早期訪問時,您可以注冊以便獲得通知。

企業人工智能開發工作流挑戰

雖然生成型人工智能模型為企業提供了難以置信的潛力,但開發過程可能復雜且耗時。

企業在開始開發定制生成人工智能之旅時面臨的一些挑戰包括以下方面。

技術專長:在研究生成式人工智能模型時,擁有正確的技術技能是關鍵。開發人員必須深入了解機器學習算法、數據處理技術、Python,以及類似的框架 TensorFlow。

數據訪問和安全:敏感客戶數據的激增意味著在此類項目中采取適當的安全措施至關重要。此外,企業必須考慮如何訪問必要的數據集來訓練其模型,這可能涉及處理來自多個來源的大量非結構化或半結構化數據。

移動工作流和應用程序:由于組件之間的依賴性,跨機器和環境的開發和部署可能很復雜。跟蹤同一應用程序或工作流的不同版本可能很困難,尤其是在更分布式的環境中,如云計算平臺Amazon AWS,Google Cloud Platform或Microsoft Azure。此外,管理憑據和機密信息對于保護跨機器和環境對資源的安全訪問至關重要。

這些挑戰強調了擁有像 NVIDIA AI Workbench 這樣的綜合平臺的重要性,該平臺可以簡化整個生成人工智能開發過程。這使得管理數據、模型、計算資源、組件之間的依賴關系和版本變得更加容易。同時提供跨機器和環境的無縫協作和部署功能。

NVIDIA AI Workbench 的主要優勢

開發生成式人工智能模型是一個復雜的過程, AI Workbench 簡化了這一過程。憑借其管理數據、模型和計算資源的統一平臺,所有技能水平的開發人員都可以快速輕松地創建和部署成本效益高、可擴展的人工智能模型。

使用 AI Workbench 的一些關鍵好處包括以下內容:

易于使用的開發平臺: AI Workbench 提供了一個用于管理數據、模型和計算資源的單一平臺,支持跨機器和環境的協作,從而簡化了開發過程。

與人工智能開發工具和存儲庫集成: AI Workbench 集成了 GitHub 、 NVIDIA NGC 、 Hugging Face 、自托管注冊表和 Git 服務器等服務。用戶可以使用 JupyterLab 和 VS Code 等工具,在不同平臺和基礎設施上進行開發,具有高度的可重復性和透明度。

增強的協作:AI Workbench 采用了一種以項目為中心的架構,這是一個 Git 存儲庫,其中包含描述內容及其關系、配置和執行說明的元數據文件。位置或用戶相關的數據由 AI Workbench 透明處理,并在運行時注入,避免這些信息被硬編碼到項目中。這種項目結構有助于自動化版本控制、容器管理和處理機密信息的復雜任務,同時實現跨團隊協作。

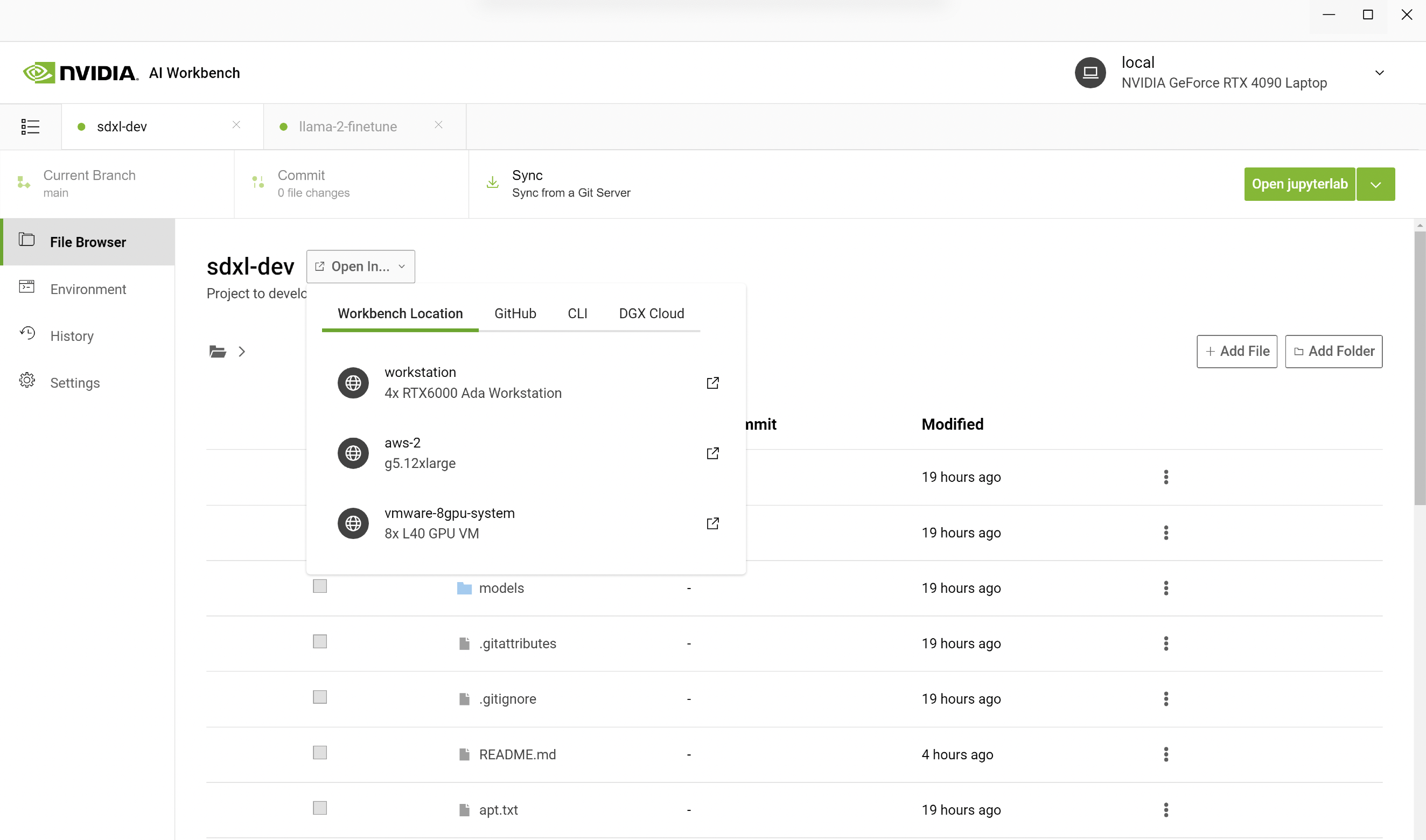

訪問加速計算:AI Workbench 的部署采用客戶端 – 服務器模型。Workbench 用戶界面在本地系統上運行,并與 Workbench Service 進行遠程通信。用戶界面和服務都在用戶的主要資源(如工作筆記本電腦)上本地運行。該服務可以安裝在可通過 SSH 連接訪問的遠程計算機上。這使得團隊能夠在工作站中利用本地計算資源開始開發,并隨著培訓工作的增加而轉移到數據中心或云資源。

NVIDIA AI 工作臺投入使用

在 SIGGRAPH 2023 上,我們展示了 AI Workbench 在文本和圖像工作流中生成人工智能定制的能力。

使用 Stable Diffusion XL 生成自定義圖像

而在面部空間等服務上,擁抱 Gradio 應用程序提供了與以下模特的一鍵互動 StableDiffusion XL,這使得在本地運行這些模型和應用程序可能變得困難。

用戶必須使用適當的 NVIDIA 軟件設置本地環境,如 NVIDIA TensorRT 和 NVIDIA Triton 。然后,他們需要 HuggingFace 的模型、 GitHub 的代碼和 NVIDIA NGC 的容器。最后,他們必須配置容器,處理 JupyterLab 等應用程序,并確保他們的 GPU 支持模型大小。

只有到那時,他們才準備好開始工作。即使對于專家來說,也有很多事情要做。

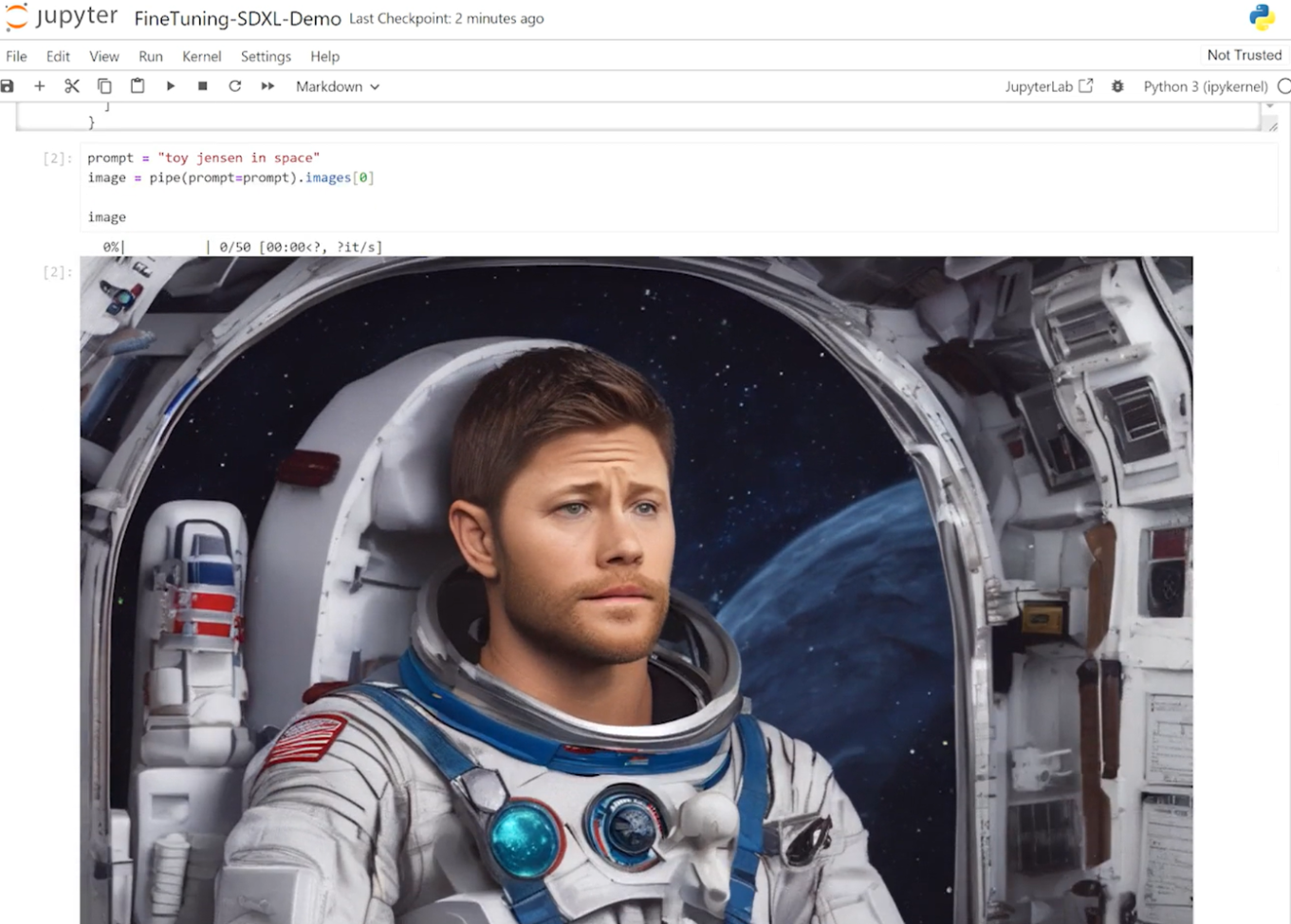

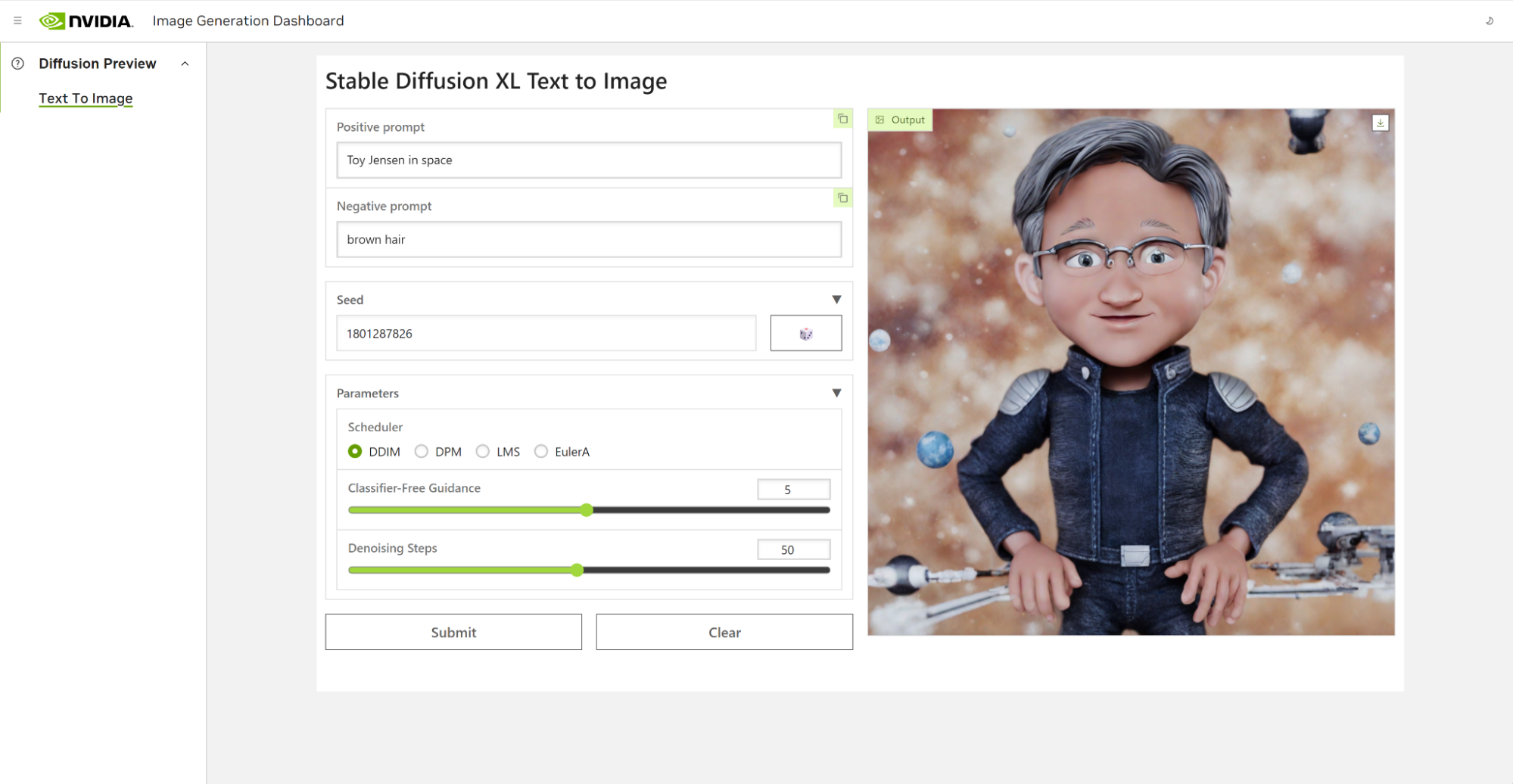

AI Workbench 使?通過從 GitHub 克隆 Workbench 項目來完成整個過程。以下示例概述了我們的團隊在創建 Toy Jensen 圖像時所采取的步驟。

首先,我們在 PC 上打開 AI Workbench,然后使用 URL 克隆一個 repo。我們選擇在配備更多 GPU 的遠程工作站上運行 Jupyter Notebook,而不是在本地運行。在 AI Workbench 中,您可以選擇您的工作站并打開 Jupyter 筆記本。

在 Jupyter Notebook 中,我們從 Hugging Face 加載了預訓練的 Stable Diffusion XL 模型,并要求它生成一張“ Toy Jensen In space ”的圖像。然而,根據輸出的圖像,模型不知道 Toy Jenson 是誰。

使用 DreamBooth 對模型進行微調,使我們能夠根據感興趣的特定主題對其進行個性化設置。在 Toy Jensen 的案例中,我們使用了 8 張 Toy Jenson 的照片來微調模型,并獲得了良好的效果。現在,我們準備使用用戶界面重新運行推理。該模型現在知道 Toy Jensen 是什么樣子的,并且可以生成更好的圖片,如圖 4 所示。

為醫學推理微調 Llama 2

較大的模型如Llama 2 70B需要更多的加速計算能力來進行微調和推理。在這個演示中,我們需要在數據中心配置 GPU,以便能夠自定義模型。

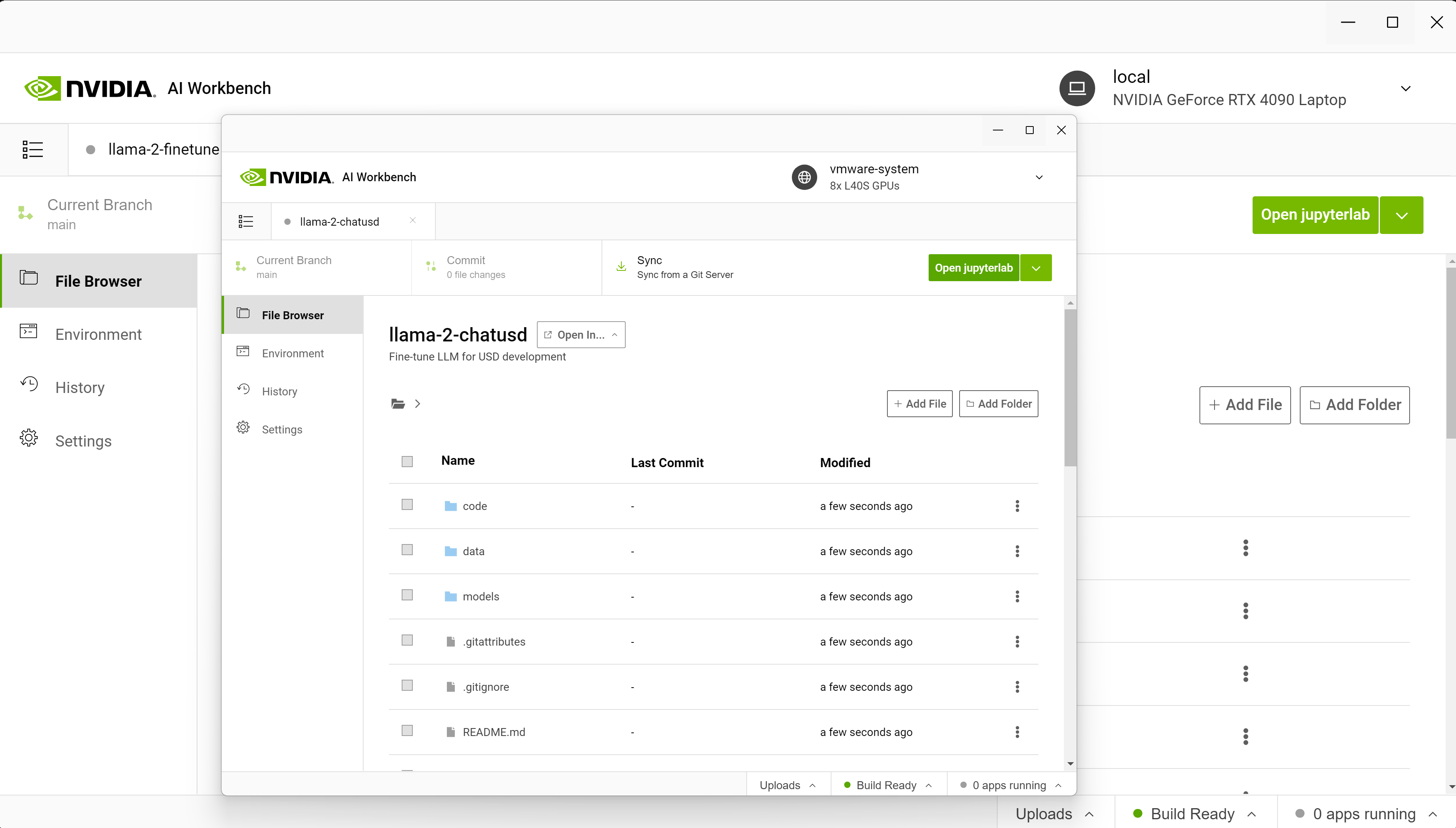

通常,設置環境、連接服務、下載資源、配置容器等工作都是在遠程資源上完成的。使用 AI Workbench,我們只需要從 GitHub 克隆一個項目,然后點擊 啟動 JupyterLab。

這個演示的目標是使用 Llama-2 模型為醫療用例構建一個專門的聊天機器人。開箱即用, Llama-2 模型對有關研究論文的醫學問題反應不佳,因此我們必須定制該模型。

從筆記本電腦開始,我們連接到在數據中心或云中運行的八個 NVIDIA L40 GPU 。本地項目遷移到遠程計算機?使用 AI Workbench 。

從 AI Workbench 啟動了 Jupyter 環境,其中包括 P 調優筆記本,我們在其中加載預訓練的 Llama-2 模型。

接下來,我們使用 NeMo 將其與開源 PubMedQA 數據集進行 P 調優。然后,我們打開用戶界面再次運行推理,現在我們的模型根據給定的醫學背景更準確地回答了關于以前未知疾病的問題。

在本例中,我們提供了以下提示來指導調優模型如何響應。

| 目標:確定早期超聲圖預測孿生 A 出生時表現的能力。 方法:對 7 個胎齡間隔的雙胎 A 表現的聲像圖記錄進行審查,并對分娩時雙胎 A 的住院醫療記錄進行審查。 結果:妊娠 28 周后,超聲檢測雙胎 A 的頭位對分娩時頭位持續存在的陽性預測值達到 95% 。妊娠 32 周后,通過超聲檢查確定的分娩時非頭痛表現的陽性預測值> 90% 。 問題:孕晚期超聲能預測分娩時第一對孿生的表現嗎? |

p 調諧模型能夠利用從 PubMedQA 數據集學習到的信息正確響應提示。

| 答案:是的,孕晚期超聲可以高度準確地預測分娩時第一對孿生的表現。根據您提供的研究,在妊娠 28 周后,通過超聲確定的雙胎 A 的頭部出現對分娩時頭部出現持續性的陽性預測價值達到 95% 。 同樣,妊娠 32 周后,通過超聲檢查確定的分娩時非頭部表現的陽性預測值> 90% 。 這些發現表明,孕晚期的超聲波可以可靠地預測第一對孿生出生時的表現。然而,需要注意的是,超聲波并不總是 100% 準確,胎動和定位等其他因素可能會影響預測的準確性。 |

有了 AI Workbench ,用戶可以快速創建或克隆現有的生成型 AI 項目。開發人員可以從早期在本地機器上進行探索,一直到在工作站上進行模型調整,并在云和數據中心中投入可擴展資源進行大規模培訓。

使用 NVIDIA AI Workbench 實現生成 AI 的經濟高效可擴展性

隨著人工智能模型變得越來越復雜和計算密集,開發人員必須擁有成本效益高的工具,使他們能夠快速高效地擴展。 AI Workbench 提供了一個用于管理數據、模型和計算資源的單一平臺,實現跨機器和環境的無縫協作和部署。有了這個平臺,所有技能水平的開發人員都可以快速創建和部署成本效益高、可擴展的生成人工智能模型。

如果您想了解更多關于 AI Workbench 的信息,或者想注冊以獲取早期訪問的通知,請訪問 AI Workbench 頁面。

?