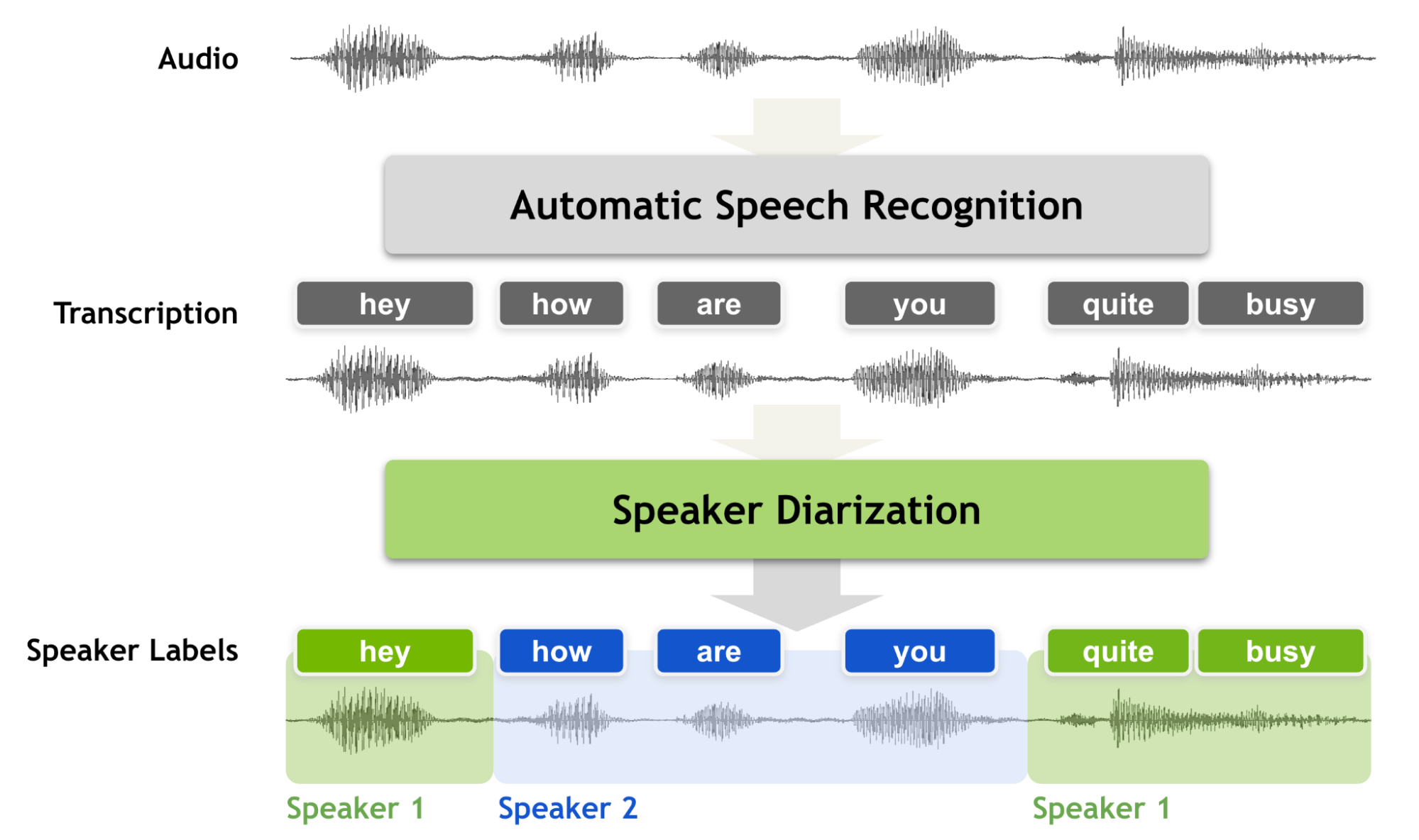

說話人日記化是按說話人標簽對錄音進行分段的過程,旨在回答“誰在何時發言?”。與語音識別相比,它有著明顯的區別。

在你執行說話人日記化之前,你知道“說的是什么”,但你不知道“誰說的”。因此,說話人日記化是語音識別系統的一個基本特征,它可以用說話人標簽豐富轉錄內容。也就是說,如果沒有說話人日記化過程,會話錄音永遠不能被視為完全轉錄,因為沒有說話者標簽的轉錄無法通知您是誰在和誰說話。

說話人日記必須產生準確的時間戳,因為在會話設置中,說話人的話輪數可能非常短。我們經常使用短的反向通道詞,如“ yes ”、“ uh huh ”或“ oh ”。這些詞對機器轉錄和識別說話人來說很有挑戰性。

雖然根據說話人身份對音頻記錄進行分段,但說話人日記化需要對相對較短的分段進行細粒度決策,從十分之幾秒到幾秒不等。對如此短的音頻片段做出準確、細粒度的決策是一項挑戰,因為它不太可能捕捉到可靠的說話人特征。

在本文中,我們討論了如何通過引入一種稱為多尺度方法和多尺度二值化解碼器( MSDD )的新技術來處理多尺度輸入來解決這個問題。

多尺度分割機制

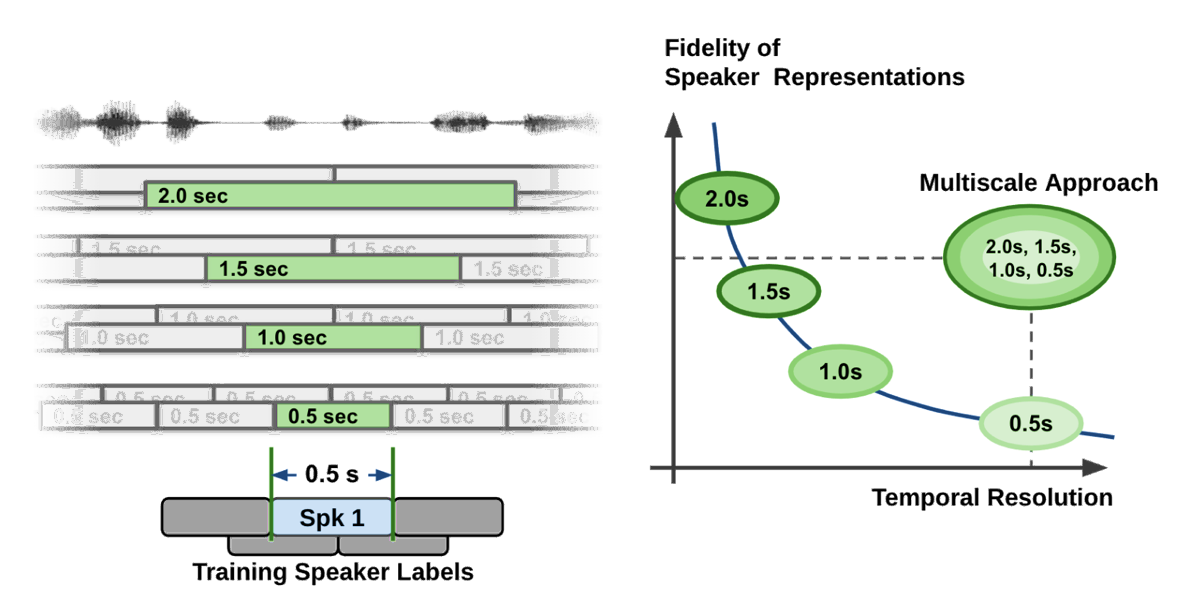

就揚聲器特征的質量而言,提取長音頻段是可取的。然而,音頻段的長度也限制了粒度,這導致揚聲器標簽決策的單位長度較粗。如圖 2 所示的曲線所示,說話人區分系統面臨著時間分辨率和說話人表示保真度之間的權衡問題。

在說話人區分流水線中的說話人特征提取過程中,為了獲得高質量的說話者表示向量,不可避免地要花費較長的語音段來犧牲時間分辨率。在簡單明了的語言中,如果你試圖準確掌握語音特征,那么你必須考慮更長的時間跨度。

同時,如果你考慮更長的時間跨度,你必須在相當長的時間跨度內做出決定。這會導致粗決策(時間分辨率低)。想想這樣一個事實,如果只錄下半秒鐘的講話,即使是人類聽眾也無法準確地說出誰在講話。

在大多數分音系統中,音頻段長度在 1.5 到 3.0 秒之間,因為這樣的數字在揚聲器特性的質量和時間分辨率之間取得了很好的折衷。這種分割方法稱為 single-scale approach 。

即使使用重疊技術,單尺度分割也將時間分辨率限制在 0.75 ~ 1.5 秒,這在時間精度方面留下了改進的空間。

粗略的時間分辨率不僅會降低二值化的性能,而且會降低說話人計數的準確性,因為短語音片段無法正確捕獲。 更重要的是,說話人時間戳中的這種粗時間分辨率使得解碼后的 ASR 文本與說話人區分結果之間的匹配更容易出錯。

為了解決這個問題,我們提出了一種多尺度方法,這是一種通過從多段長度中提取說話人特征,然后將多尺度的結果結合起來來處理這種權衡的方法。多尺度技術在最流行的說話人方言化基準數據集上實現了最先進的精度。它已經是開源會話 AI 工具包 NVIDIA NeMo 的一部分。

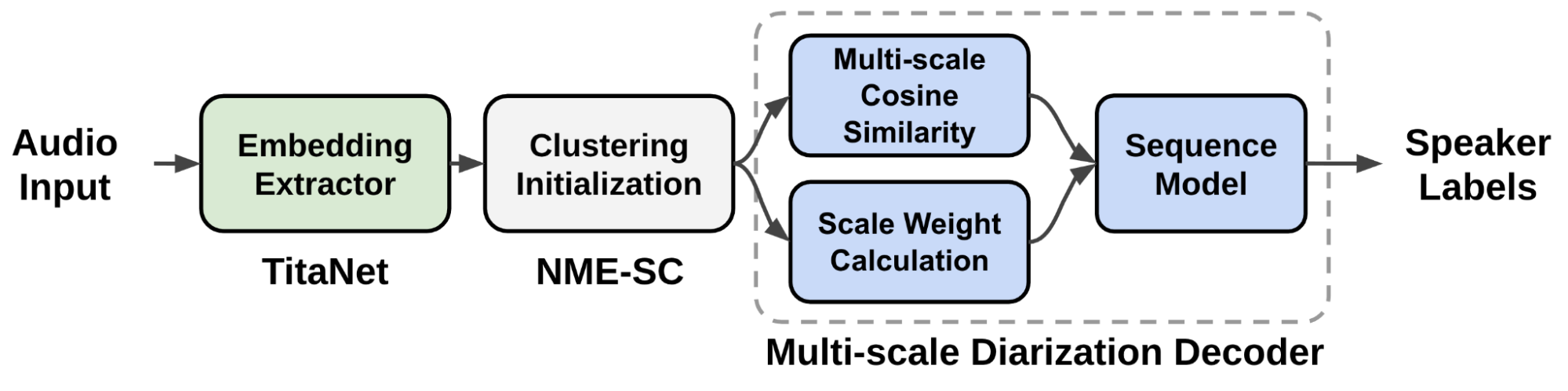

圖 2 顯示了多尺度揚聲器分辨率的關鍵技術解決方案。

多尺度方法通過使用多尺度分割和從每個尺度提取說話人嵌入來實現。在圖 2 的左側,在多尺度分割方法中執行了四種不同的尺度。

在段關聯性計算過程中,將合并從最長刻度到最短刻度的所有信息,但只對最短的段范圍作出決策。當組合每個音階的特征時,每個音階權重在很大程度上影響說話人的區分性能。

基于神經模型的多尺度分解流水線

由于刻度權重在很大程度上決定了說話人區分系統的準確性,因此應設置刻度權重以使說話人的區分性能達到最大。

我們提出了一種稱為 multiscale diarization decoder ( MSDD )的新型多尺度二值化系統,該系統在每個時間步長動態確定每個尺度的重要性。

說話人日記系統依賴于被稱為說話人嵌入的音頻特征向量捕獲的說話人特征。通過神經模型提取說話人嵌入向量,從給定的音頻信號中生成稠密浮點數向量。

MSDD 從多個尺度中提取多個說話人嵌入向量,然后估計所需的尺度權重。基于估計的音階權重,生成揚聲器標簽。如果輸入信號被認為在某些尺度上具有更準確的信息,則所提出的系統在大尺度上的權重更大。

圖 3 顯示了提議的多尺度說話人分離系統的數據流。從音頻輸入中提取多尺度分段,并使用揚聲器嵌入提取器( TitaNet )生成用于多尺度音頻輸入的相應揚聲器嵌入向量。

提取的多尺度嵌入通過聚類算法進行處理,以向 MSDD 模塊提供初始化聚類結果。 MSDD 模塊使用簇平均說話人嵌入向量與輸入說話人嵌入式序列進行比較。估計每個步驟的磅秤權重,以衡量每個磅秤的重要性。

最后,訓練序列模型輸出每個說話人的說話人標簽概率。

MSDD 機制

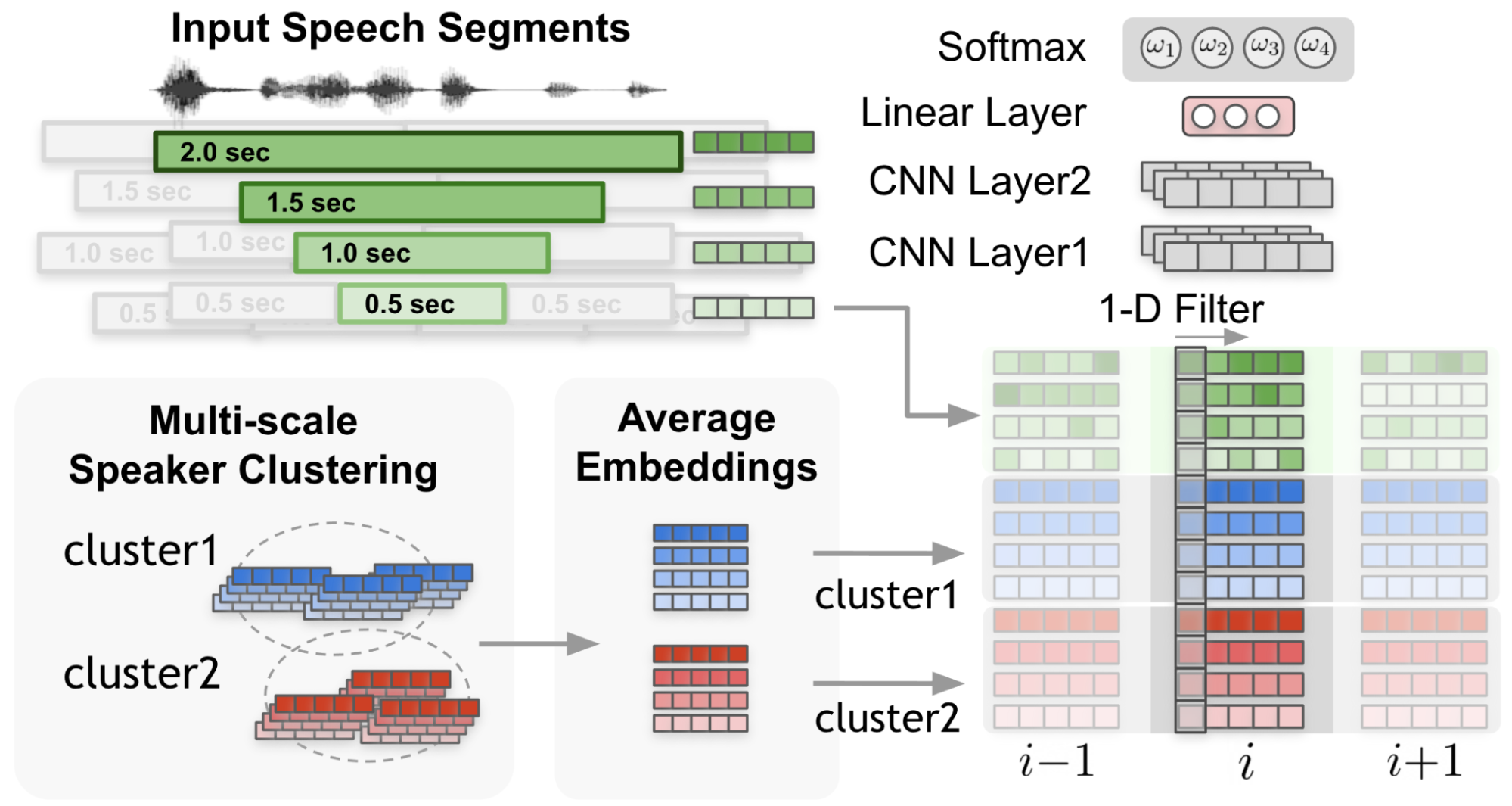

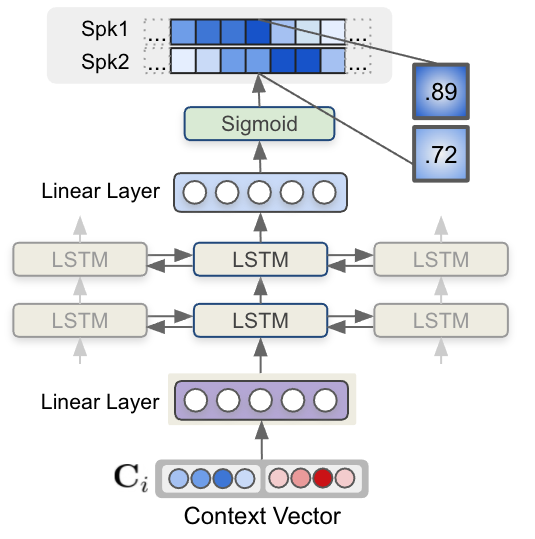

在圖 4 中, 1-D 濾波器 從輸入嵌入和集群平均嵌入捕獲上下文。

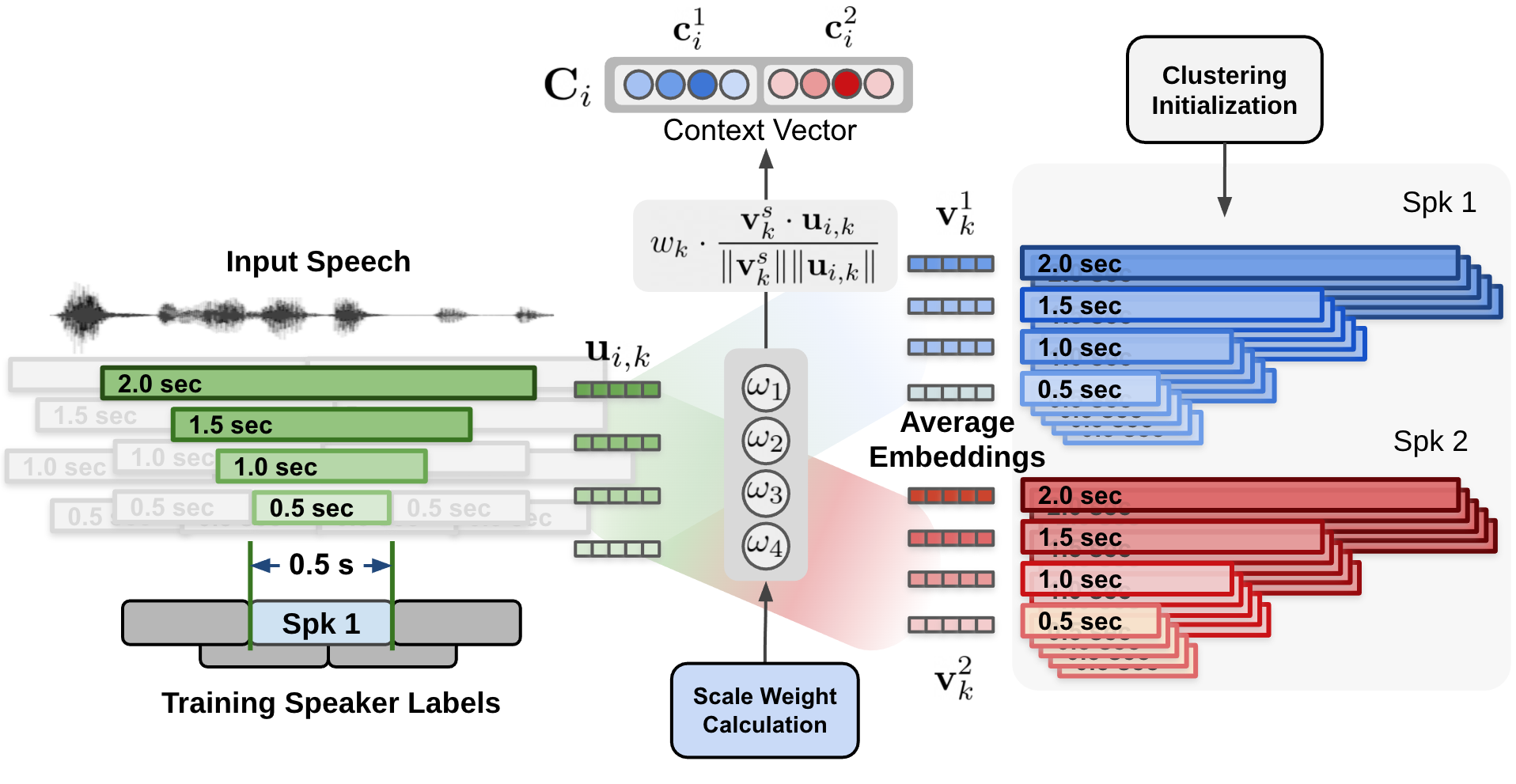

在圖 5 中,每個說話人和每個尺度的余弦相似性值由尺度權重加權,形成加權余弦相似向量。

通過動態計算每個尺度的權重,訓練神經網絡模型 MSDD 以利用多尺度方法。 MSDD 獲取初始聚類結果,并將提取的說話人嵌入與聚類平均說話人表示向量進行比較。

最重要的是,每個時間步長的每個尺度的權重是通過尺度權重機制確定的,其中尺度權重是通過應用于多尺度說話人嵌入輸入和簇平均嵌入的一維卷積神經網絡( CNN )計算得出的(圖 3 )。

估計的尺度權重應用于為每個說話人和每個尺度計算的余弦相似值。圖 5 顯示了通過對集群平均說話人嵌入和輸入說話人嵌入式之間計算出的余弦相似性(圖 4 )應用估計的比例權重來計算上下文向量的過程。

最后,每個步驟的每個上下文向量都被送入一個多層 LSTM 模型,該模型生成每個說話人的說話人存在概率。圖 6 顯示了 LSTM 模型和上下文向量輸入如何估計說話人標簽序列。

圖 6 ,使用 LSTM 的序列建模接受上下文向量輸入并生成說話人標簽。 MSDD 的輸出是兩個說話人在每個時間步存在說話人的概率值。

擬議的說話人日記系統旨在支持以下功能:

- 揚聲器數量靈活

- 重疊感知區分

- 預訓練說話人嵌入模型

揚聲器數量靈活

MSDD 使用兩兩推理來記錄與任意數量說話人的對話。例如,如果有四個說話人,則提取六對,并對 MSDD 的推理結果進行平均,以獲得四個說話人中每個人的結果。

重疊感知區分

MSDD 獨立估計每個步驟中兩個揚聲器的兩個揚聲器標簽的概率(圖 6 )。這可以在兩個揚聲器同時講話的情況下進行重疊檢測。

預訓練說話人嵌入模型

MSDD 基于預處理嵌入提取器( TitaNet )模型。通過使用預處理說話人模型,可以使用從相對大量的單說話人語音數據中學習的神經網絡權重。

此外, MSDD 設計為使用經過預處理的說話人進行優化,以在特定領域的說話者日記數據集上微調整個說話人日記系統。

實驗結果和定量效益

提出的 MSDD 系統有幾個定量優勢:卓越的時間分辨率和提高的準確性。

卓越的時間分辨率

雖然單尺度聚類分解器在 1.5 秒的分段長度上表現出最佳性能,其中單位決策長度為 0.75 秒(半重疊),但提議的多尺度方法的單位決策長度是 0.25 秒。通過使用需要更多步驟和資源的更短移位長度,可以進一步提高時間分辨率。

圖 2 顯示了多尺度方法的概念和 0.5 秒的單位決策長度。由于揚聲器功能的保真度降低,僅將 0.5 秒的片段長度應用于單刻度分劃器會顯著降低分劃性能。

提高準確性

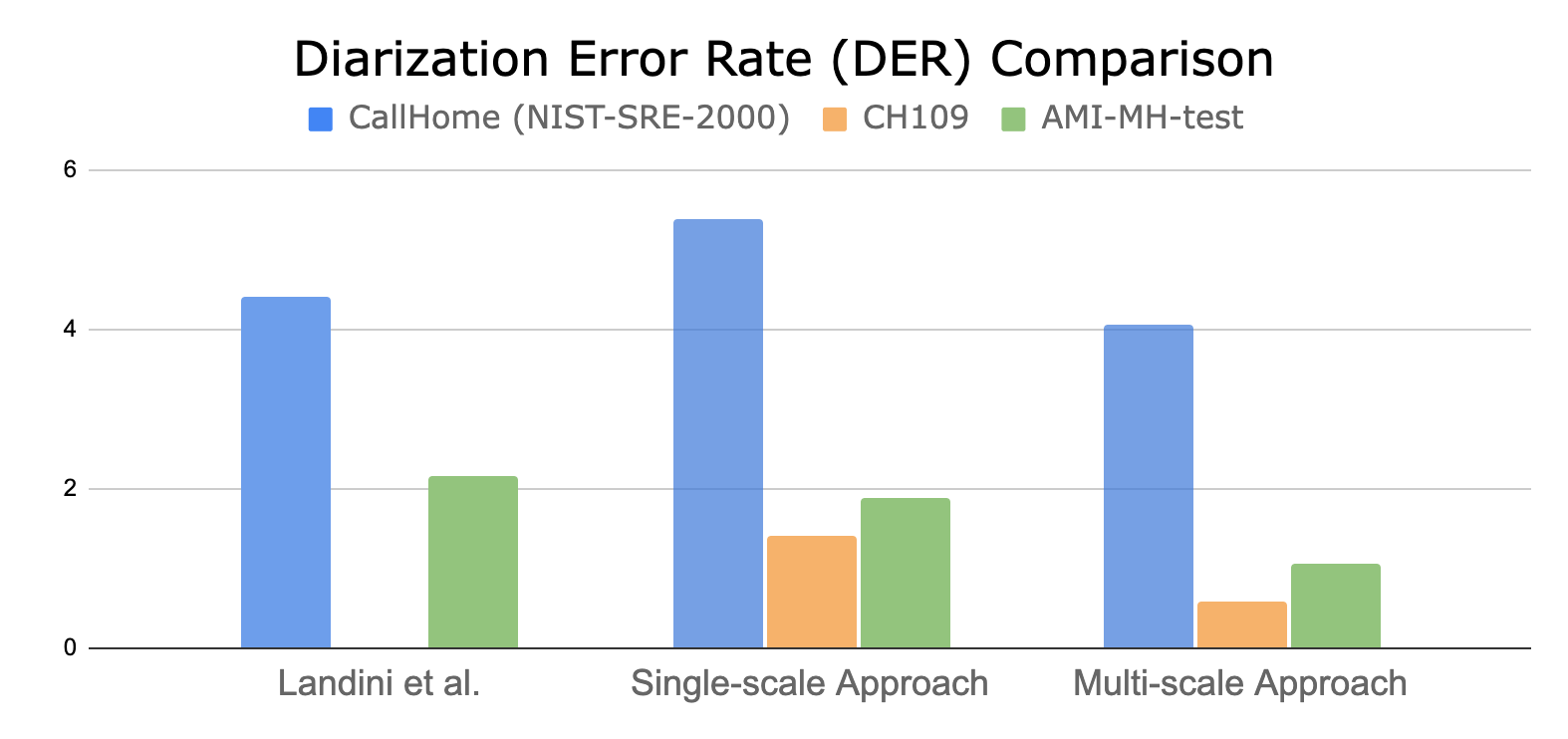

通過比較假設時間戳和地面真值時間戳來計算重化錯誤率( DER )。圖 7 顯示了多尺度二值化方法相對于最先進的單尺度聚類方法的量化性能。

與單尺度聚類日記器相比,所提出的 MSDD 方法可以在兩個說話人數據集上減少多達 60% 的 DER 。

結論

擬議系統具有以下優點:

- 這是第一個應用多尺度加權概念和基于序列模型( LSTM )的說話人標簽估計的神經網絡架構。

- 加權方案集成在單個推理會話中,不需要像其他說話人日記化系統那樣融合多個日記化結果。

- 提出的多尺度分解系統能夠實現重疊感知的分解,這是傳統基于聚類的分解系統無法實現的。

- 因為解碼器基于基于聚類的初始化,所以分音系統可以處理靈活數量的說話人。這表明您可以在兩個說話人數據集上訓練建議的模型,然后使用它對兩個或更多說話人進行分類。

- 雖然具有前面提到的所有優點,但與之前公布的結果相比,所提出的方法顯示了優越的區分性能。

關于擬議系統,未來有兩個研究領域:

- 我們計劃通過實現基于短期窗口聚類的二值化解碼器來實現該系統的流媒體版本。

- 可以研究從說話人嵌入提取器到二值化解碼器的端到端優化,以提高說話人二值化性能。

有關更多信息,請參閱 Multiscale Speaker Diarization with Dynamic Scale Weighting 或 Interspeech 2022 會議。

?