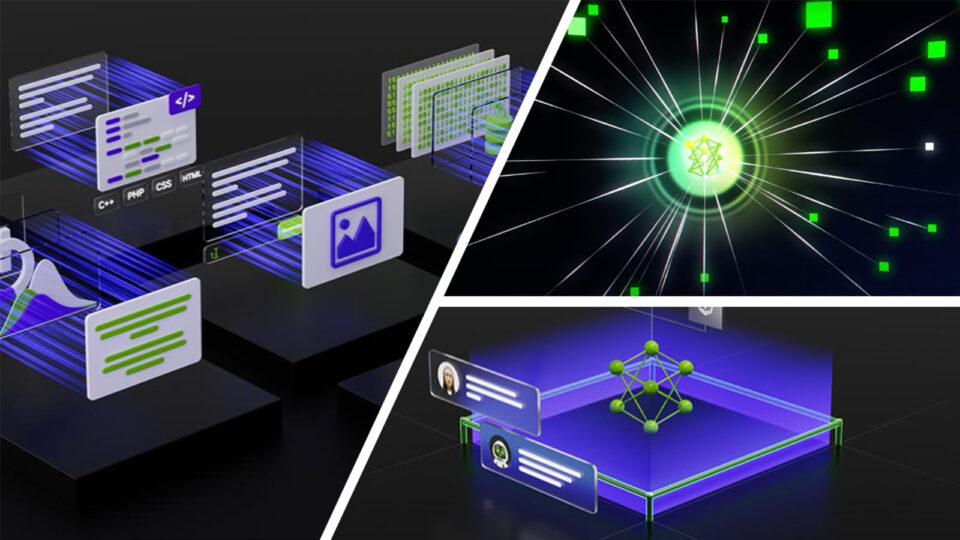

機密和自主的 AI 是一種新的 AI 開發、訓練和推理方法,其中用戶的數據是去中心化的、私有的,并由用戶自己控制。本文將探討如何通過使用區塊鏈技術的去中心化來擴展 Confidential Computing(CC)的功能。

通過使用個人 AI 智能體,可以非常清楚地看到所解決的問題。這些服務可幫助用戶完成許多任務,包括撰寫電子郵件、準備報稅和查看醫療記錄。毋庸置疑,所處理的數據是敏感的個人數據。

在集中式系統中,這些數據由人工智能服務提供商在云中處理,通常不透明。當用戶的數據離開設備時,他們將失去對自己數據的控制,而這些數據可能會被用于訓練、泄露、出售或以其他方式被誤用。屆時無法追蹤個人數據。

這種信任問題阻礙了 AI 行業發展的某些特定方面,尤其是對于尚未獲得聲譽或證據來支持其真實意圖的初創公司和 AI 開發者而言。機密且自主的 AI 云可為必須保護數據并確保數據主權的客戶提供解決方案。

解決自主 AI 云需求?

Super Protocol 基于機密性、去中心化和自主原則,構建了一個同名的 AI 云和市場。在 Super Protocol 云中,機密計算技術在執行期間保護數據,而基于區塊鏈的去中心化網絡則提供所有流程的編排、透明度和可驗證性。

NVIDIA Confidential Computing 使用 CPU 和 NVIDIA GPU 來保護使用中的數據,使惡意行為者以及主機所有者無法查看和訪問這些數據。

NVIDIA Hopper 架構 引入了 機密計算 能力,而 NVIDIA Blackwell 架構 增強了其性能,幾乎與大語言模型 (LLMs) 的未加密模式相同。

用例:在 Super Protocol 中微調和部署 AI 智能體即服務

以下是一個實際用例:AI 開發者希望通過從 Super Protocol AI Marketplace 租賃預訓練的基礎模型,并針對涉及處理最終用戶隱私和敏感數據的特定用途微調新層,來啟動商業 AI 代理服務。

預訓練模型是專有的,不可下載,只能在其所有者設置的特定條件下租用。微調可能包括各種方法,例如知識蒸餾、低秩適應(LoRA)、檢索增強生成(RAG),以及不改變基礎模型結構和權重的其他方法。

上傳和發布?

作為先決條件,基礎模型的所有者將其預訓練模型上傳到其去中心化文件存儲(DFS)系統的帳戶,并在超級協議 AI 市場(圖 2 中步驟 1-3)上發布了報價(模型的開放列表)。這使得模型能夠在預設條件下租用,在本用例中,預設條件是每小時使用一次的費用。

現在,作為 AI 開發者,您可以安全地將數據集上傳到您的帳戶中(圖 2 中的步驟 4-5)。這些是私有數據集,用于微調基礎模型。

以下是參與此步驟序列的組件和服務:

- DFS: 去中心化文件存儲 是諸如 Filecoin 和 Storj 等對等網絡,用于在去中心化文件系統中存儲和共享數據。由于 DFS 系統本身致力于自主原則,用戶對自己的數據和賬戶擁有完全的控制權。在通過 Web 界面或 CLI 上傳數據的過程中,數據會被存檔和加密。

- AI Marketplace: AI Marketplace 是模型開發者、數據所有者和計算機資源(CC)提供商發布的產品分類帳。它基于區塊鏈和智能合同,可通過 Web 界面或命令行界面(CLI)訪問。用于上傳和管理內容,以及創建和管理部署訂單和產品。

- 區塊鏈: 基于多邊形的透明去中心化分類帳,可存儲供應商、報價和訂單的信息。這些信息包括描述、定價條件(免費、每小時、固定、收益分成)、系統要求以及各種使用規則和限制。該記錄是透明的,但不可更改。

- 智能合同: 透明且去中心化的區塊鏈應用,可根據在優惠中指定的使用規則和限制來編排部署。

微調?

在 AI Marketplace 中,選擇適合未來 AI 服務用途的預訓練基礎模型。然后,創建部署順序,以便從 AI Marketplace 租用預訓練的基礎模型,并使用自己的數據集對其進行微調(圖 3 中的第 6 至第 7 步)。

然后,智能合約自動從機密計算云中選擇一臺或多臺滿足模型微調要求的機器。執行控制器位于每臺機器的 TEE 內的機密 VM 中,負責驗證順序、下載內容并將其發送給受信任的加載程序(圖 3 中的步驟 8-10)。

然后,受信任的加載程序會部署工作負載以執行。AI 訓練引擎會獲取基礎預訓練模型,并根據部署順序規格(圖 3 中步驟 11-12)使用數據集對其進行微調。

此過程可能會重復多次,直到您對結果感到滿意為止。新的微調層會上傳回您的 DFS 系統。我沒有在圖表中展示這些步驟,以避免不必要的視覺復雜性。

預訓練模型的所有者和計算機的所有者都可以按小時獲得產品和服務的報酬(圖 3 中的第 13 步)。

以下是參與這些步驟的組件和服務:

- 機密計算云

- TEE

- 機密虛擬機

- 執行控制器

- 可信加載程序

機密計算云

機密計算云 擁有分布在 CPU 和 NVIDIA H100 Tensor Core GPU 中啟用 CC 的強大機器集群。

由于 Super Protocol 是去中心化云,因此沒有中央數據中心。相反,疊加網絡將參與部署的容器連接到本地網絡,確保工作負載的分配類似于集中式數據中心,同時遵循去中心化原則。模型和數據集的所有者可能會將其產品分銷限制在特定的 TEE 設備和地理位置上。

所有機器均由獨立提供商在網絡上提供,與挖礦類似,但適用于有用的工作負載。這些機器由智能合約進行協調,供應商因提供資源而獲得網絡獎勵。

共識機制可驗證網絡上是否存在可接受訂單的計算機、其聲明的系統配置是否正確以及 TEE 是否有效,還可移除任何欺詐性或惡意計算提供商。

我們可以在多臺機器上跨不同的 GPU 云服務提供商(CSP)創建單個部署,從而提高未充分利用的 CSP 資源的利用率,提高穩定性和負載均衡能力,并提供更具競爭力的價格優惠。

容錯可確保,如果一臺計算機離線,系統會自動訂購另一臺計算機作為替代產品,整個部署將不間斷地繼續進行。

TEE

可信執行環境 (TEE)是 CC 的一個關鍵組件,也是 RAM 中的一個保護區域,可在每臺機器中執行實際工作負載。它專為每個部署順序創建,并使用會話密鑰進行加密。TEE 可以保護數據免受未經授權的第三方(包括主機所有者和 Super Protocol 團隊)的攻擊。

過去,傳統機密 VM 的 TEE 僅限于 CPU 及其分配的 RAM,而 NVIDIA CC 解決方案則擴展了 TEE,以包含 NVIDIA Hopper GPU。

配置為 CC 模式的 NVIDIA GPU 已激活基于硬件的加密引擎、防火墻和遠程認證流,以確保 TEE 的完整性,以便最終用戶可以確保并驗證其機密工作負載在 GPU 上使用時受到保護。

Hopper CC 使用 AES-GCM256 對 PCIe 總線上的所有用戶數據進行加密和簽名,并使用經簽名和可認證的固件配置的防火墻阻止基礎設施和帶外訪問。

NVIDIA 還提供公共遠程認證服務,以便最終用戶或依賴方可以獲得最新的證據,證明其驅動和固件未因錯誤或漏洞而被吊銷。

機密虛擬機

執行控制器、可信加載器和工作負載在每臺參與計算的計算機上運行的是機密虛擬機。

執行控制器

執行控制器(EC)根據寫入區塊鏈的資源路徑從 DFS 系統下載數據。它根據智能合同和參與優惠的區塊鏈條件創建主部署順序。

可信加載程序

可信加載程序會建立一個安全的 CC 層,適用于單個機器或集成到計算集群中的機器網絡。可信加載程序會在區塊鏈上發布 TEE 確認塊 (TCB),即遠程認證報告,解密工作流文件,通過比較哈希值驗證其完整性,并創建執行工作負載。

此處的目標是確認訂單的完整性:機密性不允許訪問 TEE 內部,只能驗證輸入和輸出。

生產啟動?

現在是生產啟動的時候了。步驟 14-19(圖 2-4)與上一階段類似。

主要區別始于步驟 20 (圖 5),其中部署的 AI 引擎具有 Web 界面,并支持多用戶交互和支付處理。它采用基礎預訓練模型,并使用新的微調層運行該模型。

此外,我們還部署了一系列機密隧道,以確保最終用戶能夠安全、穩定地訪問(圖 5 中的步驟 22-23)。我們為最終用戶提供訪問 AI 引擎 Web 界面的 URL。它也可以通過 Super Protocol 作為另一種解決方案的一部分啟動,但這是另一個用例。

最終用戶通過便捷的支付工具為 AI 代理服務付費,定價由開發者決定。

對于生產啟動,您需要訂購多臺機器并行運行,以確保負載平衡和容錯。隧道服務器應與隧道客戶端在單獨的機器上運行。

- AI 引擎 :用于部署的推理 AI 引擎。它具有用戶友好的 Web 界面,支持支付處理,并使用新的微調層執行預訓練模型。這些引擎是開源的,并通過 Super Protocol 驗證,以確保不會泄露數據。

- 機密隧道:Super Protocol 開發了一項技術,使您能夠在 TEE 內以機密模式啟動隧道網絡協議,其中隧道客戶端作為包含 AI 代理服務的 Web 服務運行。隧道服務器提供外部的公共 IP 地址。

- 支付工具: 一種開源服務,也可在 TEE 中運行,接受最終用戶的付款,并代表開發者使用 Payment tools。

AI 智能體即服務用例的結果?

在 Super Protocol 場景中微調和部署 AI 代理即服務可產生以下結果:

- 開發者通過訓練新層為基礎模型添加新功能,并將其作為商業服務的機密 AI 代理發布。

- 基礎模型所有者使用其預訓練模型的每一小時都會獲得相應的費用。

- CC 資源提供商按小時使用其機器獲得補償。

- 最終用戶可以通過網絡訪問有用的 AI 智能體,該智能體提供便捷的付款方式,并且確信其敏感數據不會泄露或用于模型訓練。

- 超級協議云可確保已部署的 AI 服務的容錯和去中心化。

安全性、透明度和可驗證性?

Super Protocol 通過流程完整性和組件的真實性實現安全性和透明度,這些組件可由獨立安全研究人員進行驗證:

- 區塊鏈和智能合同透明

- 由可信加載程序進行內容驗證

- TCB 驗證

- 開源驗證

- AI 引擎開源驗證

- E2E 加密

- TEE 認證

- 分布式機密

區塊鏈和智能合同透明?

所有區塊鏈記錄和智能合同都是不可更改的,對互聯網上的任何人都是透明的。報價、訂單和供應商可見,但匿名,并且部署訂單的內容是保密的。

由可信加載程序進行內容驗證?

部署順序的所有輸入數據(models、datasets 和 solutions)的完整性通過哈希和簽名的計算得到驗證,然后由可信加載程序在運行時驗證。

可信加載程序會向任何相關方提供運行時報告,以便獨立驗證報告中的哈希是否與所提供內容的哈希相匹配,以及是否未被篡改。

GPU 報告可直接與 NVIDIA 遠程認證云服務 一起使用,以獨立驗證 GPU 的 CC 狀態。

TCB 驗證?

TCB 由 TCB 服務自動編寫在區塊鏈上。然而,任何人也可以手動驗證 TCB。這是通過驗證 TEE 設備簽名和設備本身是否真實,然后將 VM 鏡像的哈希值與 TCB 的哈希值進行比較來完成的。

可信加載程序的開源驗證?

完成測試網絡階段后,執行控制器、可信加載器、隧道和其他 Super Protocol 中間件可在 GitHub 上以開源形式獲取。

模型和數據的所有者會在創建部署順序之前證明包含可信加載器密鑰的 TCB,然后傳輸機密以訪問其數據。如此一來,所有者便確信可信加載程序應用程序未被篡改,并且與官方開源版本完全相同。

AI 引擎開源驗證?

Super Protocol 中的所有 AI 引擎均以開源形式提供。這使安全研究人員能夠對其進行審計,以確定是否存在內置漏洞,例如數據泄露。

E2E 加密?

整個過程中都使用 E2E 加密。上傳到 DFS 系統的數據經過加密,并且僅在可信加載程序中解密。

TEE 認證?

要獲得機密環境的完整證明,可信加載程序首先會收到 NVIDIA GPU TEE 的簽名報告。該報告和可信加載器公鑰包含在通過遠程證明接收的常規 CPU TEE 報告中。

將由兩個相互關聯的認證報告組成的 TCB 寫入區塊鏈。Super Protocol 使用 NVIDIA 和 Intel 庫來驗證報告和證明、檢查可信加載程序哈希,然后驗證機密 VM 環境。

分布式機密?

它是 DFS 系統上的加密秘密庫,包含部署在 Super Protocol 上的解決方案生成的任何隱私或敏感用戶數據。

目標是確保解決方案開發者無法訪問存儲的數據。密鑰在受信任的加載程序之間生成和共享,而 vault 本身可由具有相同 solution hash 的不同部署實例訪問。

結束語?

歷史上,大多數 AI 模型都是開源的,任何人都可以自由使用和重復使用。然而,新興趨勢是模型和數據集正變得越來越專有

CC 和自主 AI 為您提供了保護和商業化您的工作的機會,并進一步激勵您提供安全、透明和可驗證的 AI 服務。尤其是在政府對 AI 行業日益嚴格審查的背景下,這一點尤為重要。

有關更多信息,請參閱以下資源:

- 超級協議

- 機密計算對于 Web3 AI 的優勢

- 實時 AI 處理研討會 (NVIDIA 通過 NVIDIA LaunchPad 為本次研討會提供 H100 TEE 訪問權限。)

- NVIDIA 機密計算

- 通過 NVIDIA Launchpad 訪問此實驗室和其他實驗室

?