在生產規模上部署推理模型

很多人喜歡構建機器學習模型。挑戰包括確定要預測的變量、尋找最佳模型體系結構的實驗,以及對正確的訓練數據進行采樣。但是,如果您無法訪問該模型,它又有什么好處呢?

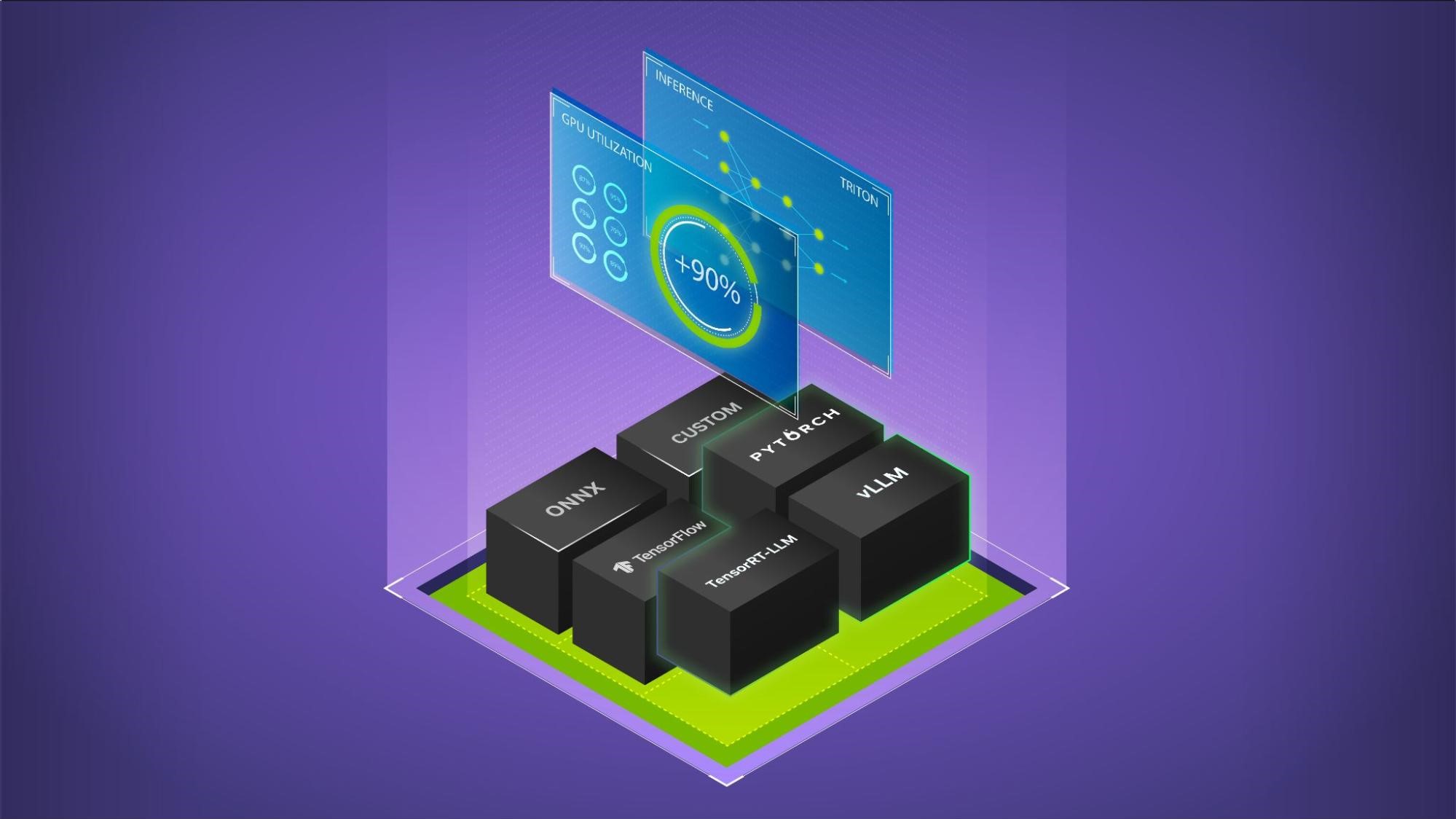

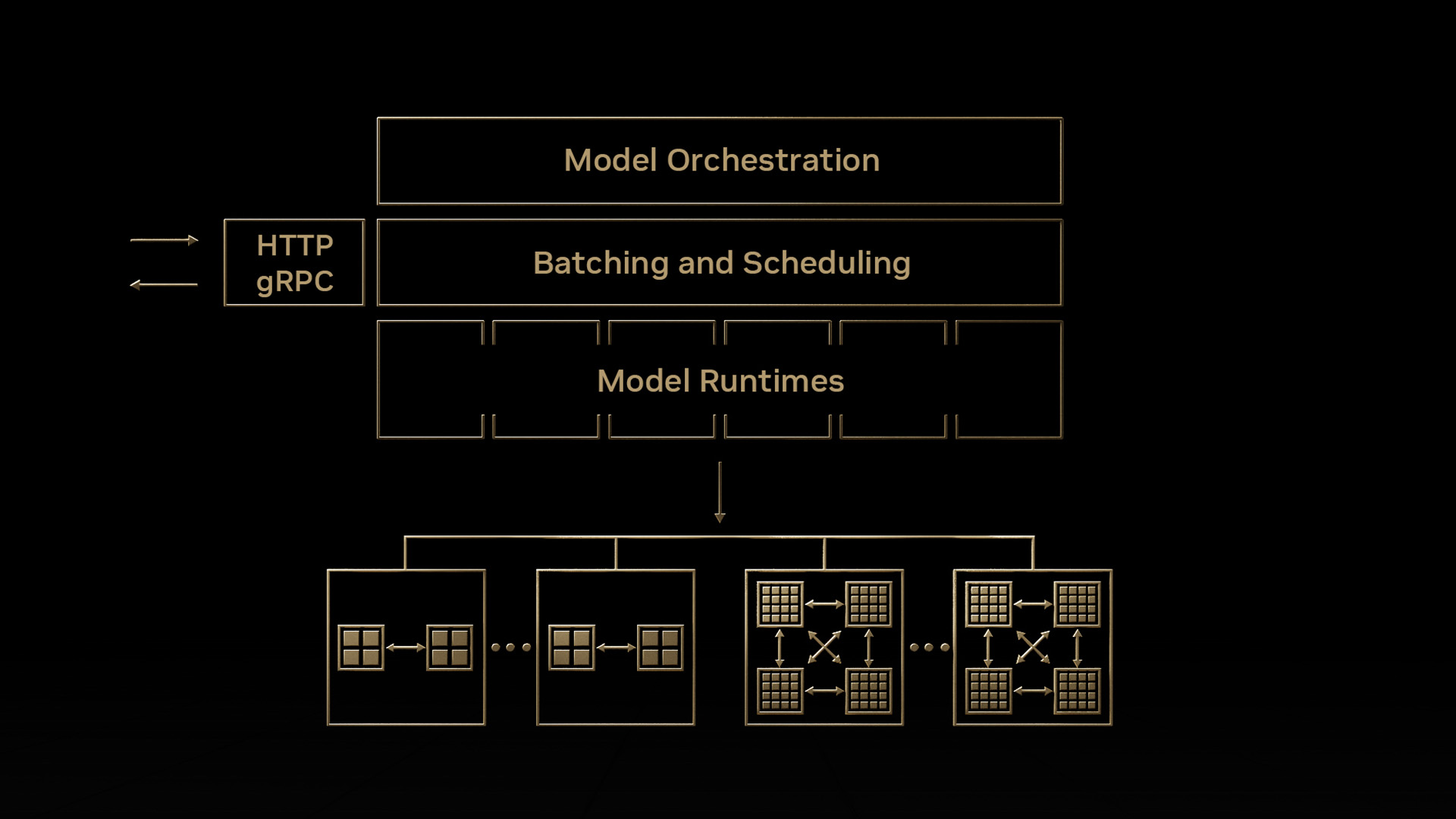

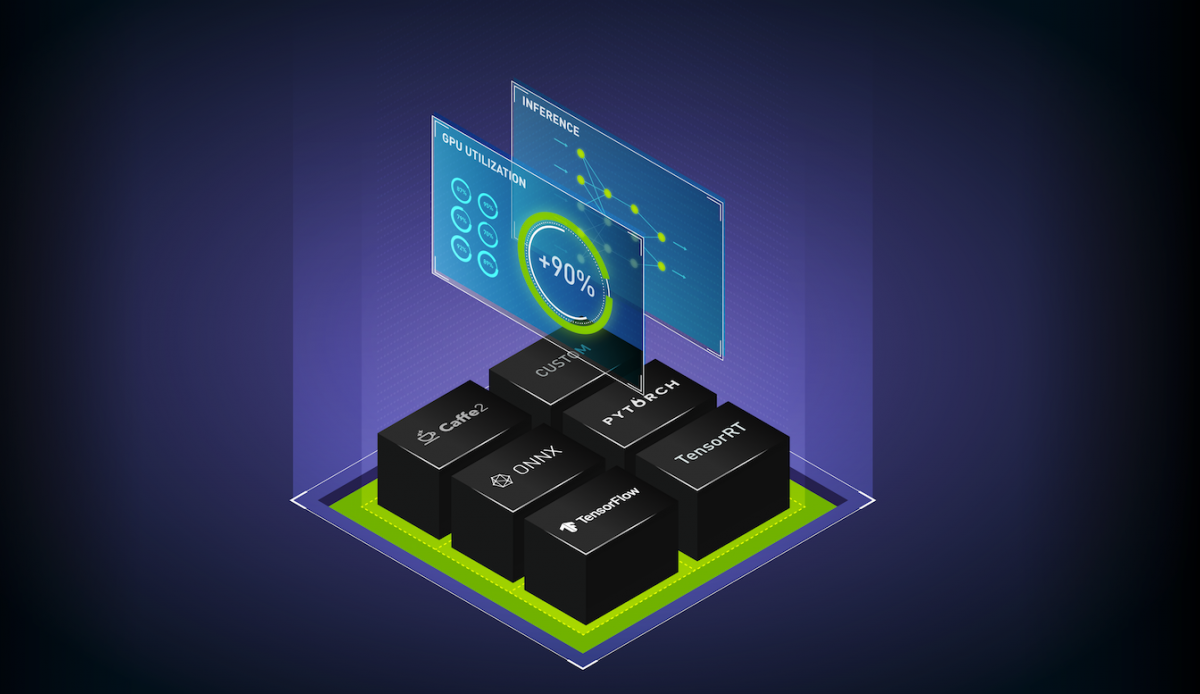

進入 NVIDIA Triton 推理服務器 . NVIDIA Triton 幫助數據科學家和系統管理員將用于訓練模型的機器轉變為用于模型預測的 web 服務器。雖然不需要 GPU ,但 NVIDIA Triton 推理服務器可以利用多個安裝的 GPU 快速處理大批量請求。

為了獲得實時服務器的實踐, NVIDIA?深度學習培訓中心(DLI) 提供了一個名為大規模推理部署模型的 4 學時在線自主培訓課程。

MLOps 概述

NVIDIA Triton 是在考慮到 機器學習操作 或 MLOps 的情況下創建的。 MLOps 是從開發人員操作( DevOps )演變而來的一個相對較新的領域,其重點是在生產環境中擴展和維護機器學習模型。 NVIDIA Triton 配備了模型版本控制等功能,以方便回滾。它還與 Prometheus 兼容,以跟蹤和管理服務器指標,如延遲和請求計數。

課程信息

本課程介紹 MLOps ,并結合現場 NVIDIA Triton 推理服務器的實踐。

學習目標包括:

- 將各種框架中的神經網絡部署到實時 NVIDIA Triton 服務器上。

- 使用普羅米修斯測量 GPU 使用率和其他指標。

- 發送異步請求以最大化吞吐量。

完成后,開發人員將能夠在 NVIDIA Triton 服務器上部署自己的模型。

有關更多實踐培訓,請訪問 NVIDIA?深度學習培訓中心(DLI) 。

?