部署 AI 賦能的應用和服務給企業帶來了重大的挑戰:

- 性能至關重要,因為它直接影響用戶體驗和競爭優勢,并影響部署成本,影響整體投資回報率。

- 實現可擴展性對于在不超過配置計算資源的情況下有效滿足已部署 AI 應用程序不斷變化的需求至關重要。這需要在高峰期間動態擴展資源以確保平穩運行,并在較安靜的時間縮減資源以優化成本。

- 復雜性使問題更加復雜,涉及優化多個 AI 模型的性能、將這些模型無縫集成到現有工作流程中,以及管理底層基礎設施等任務。

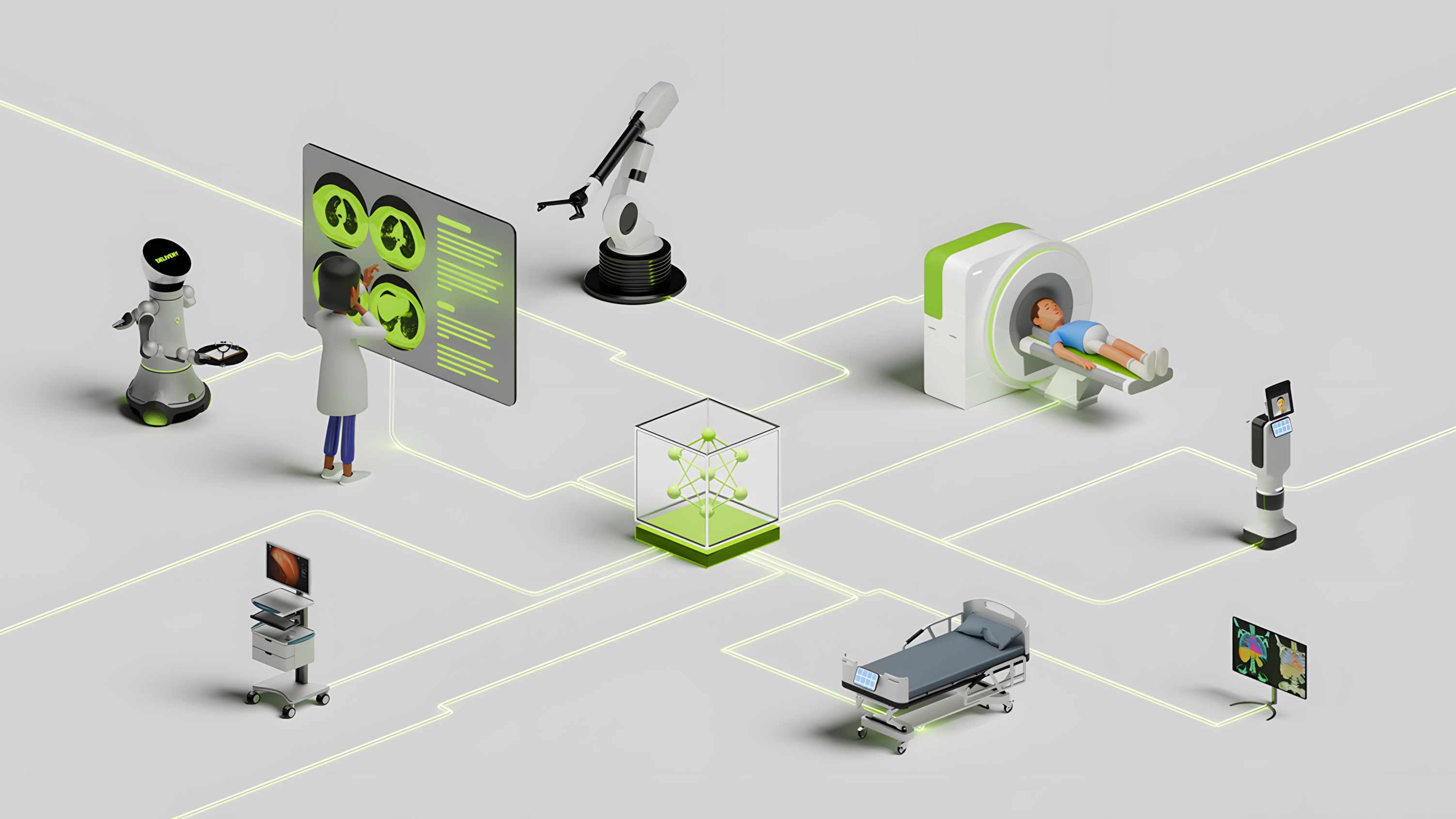

應對這些挑戰需要一種全棧方法,該方法可以優化性能、有效管理可擴展性并駕部署的復雜性,使組織能夠在保持運營效率和成本效益的同時最大限度地發揮AI的全部潛力。

Google Cloud 和 NVIDIA 攜手合作,通過結合 NVIDIA AI 平臺的性能和云端無服務器計算的易用性,應對這些挑戰并簡化 AI 推理部署。

Google Cloud 的完全托管式無服務器容器運行時 Cloud Run 增加了對 NVIDIA L4 Tensor Core GPU 的支持(可在預覽版中獲取)。現在,您可以按需運行大規模加速的實時 AI 應用程序,而無需擔心基礎設施管理。結合 NVIDIA NIM 微服務的強大功能,Cloud Run 能夠顯著簡化生產優化和服務 AI 模型的復雜性,同時更大限度地提高應用程序性能。

部署支持 AI 的實時應用

借助 Cloud Run,您可以抽象化基礎架構管理并根據需要動態分配資源,從而部署和運行容器化應用程序。它可以根據傳入流量自動擴展應用程序,這樣您就不必調配剩余的計算資源來處理峰值負載。憑借其快速實例啟動和擴展到零,您也不必在需求較低期間保持空閑資源。

NVIDIA L4 Tensor Core GPU 的 Cloud Run 支持標志著其與之前僅使用 CPU 的產品相比實現了重大的飛躍。

NVIDIA L4 GPU針對包括推薦系統、基于語音的AI助手、生成式AI、視覺搜索和聯系中心自動化等多種AI應用的大規模推理進行了優化,可以提供出色的個性化體驗。與CPU解決方案相比,L4 GPU可以提供高達120倍的AI視頻性能,生成式AI推理性能是上一代產品的2.7倍。

Google Cloud 是第一家為其 G2 VM 提供 NVIDIA L4 GPU 的云,包括 Google Compute Engine (GCE)、Google Kubernetes Engine (GKE) 和 Vertex AI 在內的 Google Cloud 服務均支持這些 GPU。

讓我們看看,Let’s Enhance、Wombo、Writer、Descript 和 AppLovin 等公司正在利用 NVIDIA L4 GPU 的強大功能,將生成式 AI 驅動的應用程序變為現實,并為客戶提供愉快的體驗。

通過在 Cloud Run 上添加對 NVIDIA L4 的支持,您可以使用輕量級生成式 AI 模型(例如 Gemma-2B/7B、Llama3-8B 和 Mistral-8x7B)部署實時推理應用程序。這與 Cloud Run 的無服務器平臺的可擴展性、每秒計費、低延遲和快速冷啟動時間相結合。

性能經過優化的無服務器 AI 推理

優化所部署的 AI 模型的性能至關重要,因為它直接影響所需的資源,并影響部署 AI 應用程序的總體成本。

為應對這一挑戰,NVIDIA 推出了 NVIDIA NIM,這是一套經過優化的云原生微服務,旨在簡化和加速 AI 模型的部署。NIM 提供預先優化的容器化模型,可以輕松集成到應用程序中,從而縮短開發時間并最大限度地提高資源效率。

通過在 Cloud Run 上使用 NVIDIA NIM,您可以使用經過優化的推理引擎部署高性能 AI 應用程序,從而充分發揮 NVIDIA L4 GPU 的潛力,并提供出色的吞吐量和延遲,而無需具備推理性能優化方面的專業知識。

作為 Google Cloud Marketplace 上 NVIDIA AI Enterprise 的一部分,NIM 提供與 OpenAI API 兼容的編程模型和自定義擴展程序的靈活集成,同時通過使用安全張量、持續監控和修補 CVE 以及定期進行內部滲透測試來優先考慮企業級安全性,從而確保 AI 應用穩健、安全且受支持良好,從而促進從開發到生產的平穩過渡。

除了 Cloud Run 之外,NVIDIA NIM 還可以部署在不同的 Google Cloud 服務中,包括 Google Kubernetes Engine (GKE) 或 Google Compute Engine (GCE),讓您選擇構建和部署 AI 應用程序所需的抽象級別。

借助 NVIDIA L4 在 Google Cloud Run 上部署 Llama3-8B-Instruct NIM 微服務

以下是如何使用 NIM 在 NVIDIA L4 GPU 上使用 Cloud Run 部署 Llama3-8B-Instruct 模型。Cloud Run 目前支持每個 Cloud Run 實例連接一個 NVIDIA L4 GPU。作為前提條件,請在工作站上安裝 Google Cloud SDK。

克隆資源庫:

$ git clone https://github.com/NVIDIA/nim-deploy$ cd nim-deploy/cloud-service-providers/google-cloud/cloudrun |

設置啟動所需的環境變量:

$ cat envexport SERVICE_ACCOUNT_ID=<Put your service account>export PROJECTID=<Put your project ID>export PROJECTUSER=<Put your user name>export PROJECTNUM=<Put your project number>export REGION=<Put your region>export GCSBUCKET=<Put your GCS bucket>export SERVICE_NAME=llama-3-8b-instruct# ---- entries below created by build_nim.sh |

使用部署所需的適當 NIM 微服務名稱編輯 Dockerfile。在 FROM 語句中放置來自 NVIDIA NGC 的所需模型 URL。

FROM nvcr.io/nim/meta/llama3-8b-instruct:1.0.0 |

構建用于啟動的容器:

$ source ./env && ./build_nim.sh |

通過執行run.sh腳本部署容器:

$ source ./env && ./run.sh |

準備好了嗎?

NVIDIA AI 平臺(包括 NVIDIA NIM 和 NVIDIA L4 GPU)與 Google Cloud Run 的強強聯合,解決了部署 AI 應用程序所固有的性能、可擴展性和復雜性方面的關鍵挑戰。這一種協同作用不僅加速了部署,而且提高了應用程序性能,幫助組織充分利用 AI,同時保持運營效率和低成本。

您可以通過 NVIDIA API 目錄使用 NVIDIA NIM 微服務進行體驗和原型設計,從而測試和優化應用程序。然后,您可以下載 NIM 容器,在 Google Cloud Run 上繼續開發、研究和測試,這是免費的 NVIDIA 開發者計劃的一部分。

如果您正在尋求企業級安全性、支持和 API 穩定性,可以通過 90 天免費的 NVIDIA AI Enterprise 許可證訪問 NIM。您還可以在 NVIDIA LaunchPad 上試用 NIM 實戰實驗室。

支持 NVIDIA L4 GPU 的 Cloud Run 目前處于預覽階段,可在 us-central1 Google Cloud 區域使用。欲了解此功能的更多信息并觀看實際演示,請查看發布活動直播,并立即注冊以獲取訪問權限!

?