生成式 AI 具有改變各個行業的巨大潛力。人類工作者已經開始使用 大型語言模型(LLM) 來解釋、推理和解決復雜的認知任務。檢索增強生成(RAG) 將 LLM 與數據連接起來,通過允許 LLM 訪問準確和最新的信息,擴展了 LLM 的功能。

許多企業已經開始探索 RAG 如何幫助他們實現業務流程自動化和挖掘數據以獲取見解。盡管大多數企業已經啟動了多個與生成式 AI 用例一致的試點,據估計,其中 90%的模型在不久的將來不會超出評估階段。將引人入勝的 RAG 演示轉化為可提供真正商業價值的生產服務仍然具有挑戰性。

在這篇博客中,我們將介紹 NVIDIA AI 如何通過四個步驟幫助您將 RAG 應用從試點階段遷移到生產階段。

構建企業就緒型 RAG 工作流

開發和部署生產就緒型企業 RAG 工作流會遇到許多障礙。

IT 管理員面臨著與 LLM 安全性、可用性、可移植性和數據治理相關的挑戰。企業開發者可能難以滿足 LLM 的準確性和 LLM 編程框架的整體成熟度。開源創新的絕對速度對每個人來說都是巨大的,新的 LLM 模型和 RAG 技術每天都在出現。

用于簡化生產 RAG 開發和部署的基礎模組

NVIDIA 通過為云原生端到端 RAG 應用提供參考架構來幫助管理這種復雜性。該參考架構是模塊化的,將熱門開源軟件與 NVIDIA 加速相結合。利用全套模塊化構建模塊具有以下優勢。

- 首先,企業可以有選擇地將新組件集成到現有基礎架構中。

- 其次,他們可以為流程的每個階段選擇商用組件和開源組件。企業可以為自己的用例選擇合適的組件,同時避免供應商鎖定。

- 最后,模塊化架構簡化了管道每個階段的評估、觀察和故障排除。

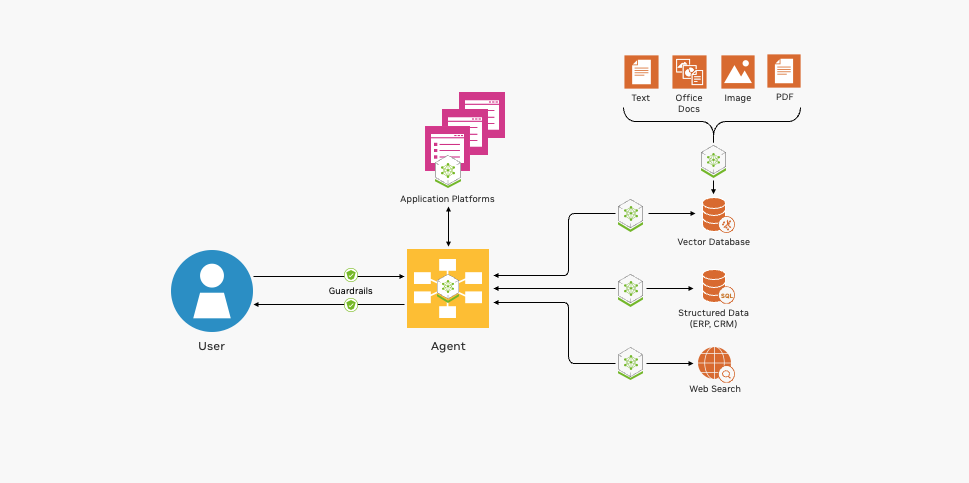

圖 1 顯示了部署 RAG 管道的基本構建塊。

NVIDIA 提供開源集成、GPU 加速容器等,幫助您開發 RAG 應用。

與熱門框架和工具的開源集成

NVIDIA 提供流程示例,幫助啟動 RAG 應用程序開發。 NVIDIA RAG 流程示例向開發者展示如何將主流開源 LLM 編程框架 (包括 LangChain、LamaIndex 和干草堆棧) 與 NVIDIA 加速軟件相結合。通過將這些示例作為起點,企業開發者可以享受兩全其美的體驗,將開源創新與加速性能和規模相結合。

這些示例還展示了與熱門開源工具的集成,用于評估、工作流可觀察性和數據提取,從而使第二天的工作流操作更加簡單且更具成本效益。

GPU 加速容器可實現快速、準確的響應

LLM 驅動的企業 RAG 應用必須快速響應且準確無誤。基于 CPU 的系統無法提供企業級可接受的性能。NVIDIA API 目錄 提供了支持 RAG 管道各個階段的容器,這些管道受益于 GPU 加速。

- NVIDIA NIM 提供了優化 LLM 推理的性能和可擴展性。

- NVIDIA NeMo Retriever 可以簡化并加速 RAG 流程的核心功能,包括文檔嵌入、檢索和查詢。

- NVIDIA RAPIDS 加速了對存儲在數據庫中的企業數據向量表示的搜索和索引。

支持多模態輸入、輸出和數據處理

RAG 應用程序正迅速從基于文本的聊天機器人發展為復雜的事件驅動型工作流,涉及圖像、音頻和視頻等各種模式。 NVIDIA AI 軟件增強了 RAG 流程的可用性和功能,以解決這些新興用例。

- NVIDIA Riva 提供 GPU 加速的文本轉語音、語音轉文本和翻譯接口,以便使用口語與 RAG 流程進行交互。

- NVIDIA RAPIDS 可以通過 GPU 加速由 LLM 代理觸發的操作。例如,LLM 代理可以調用 RAPIDS cuDF 對結構化數據執行統計數學計算。

- NVIDIA Morpheus 可以用來預處理大量企業數據,并能實時提取這些數據。

- NVIDIA Metropolis 和 NVIDIA Holoscan 為 RAG 管道添加了視頻和傳感器處理功能。

企業開發者可以利用 NVIDIA AI Enterprise 來為生成式 AI 應用提供更快速、更高效的運行時。

將 RAG 應用從試點階段推向生產的四個步驟

構建生產級 RAG 應用需要許多利益相關者之間的協作。

- 數據科學家評估 LLM 的性能和準確性。

- 企業 AI 開發者編寫、測試和改進 RAG 應用。

- 數據工程師連接和轉換企業數據以進行索引和檢索。

- MLOps、DevOps 和現場可靠性工程師 (SRE) 部署和維護生產系統。

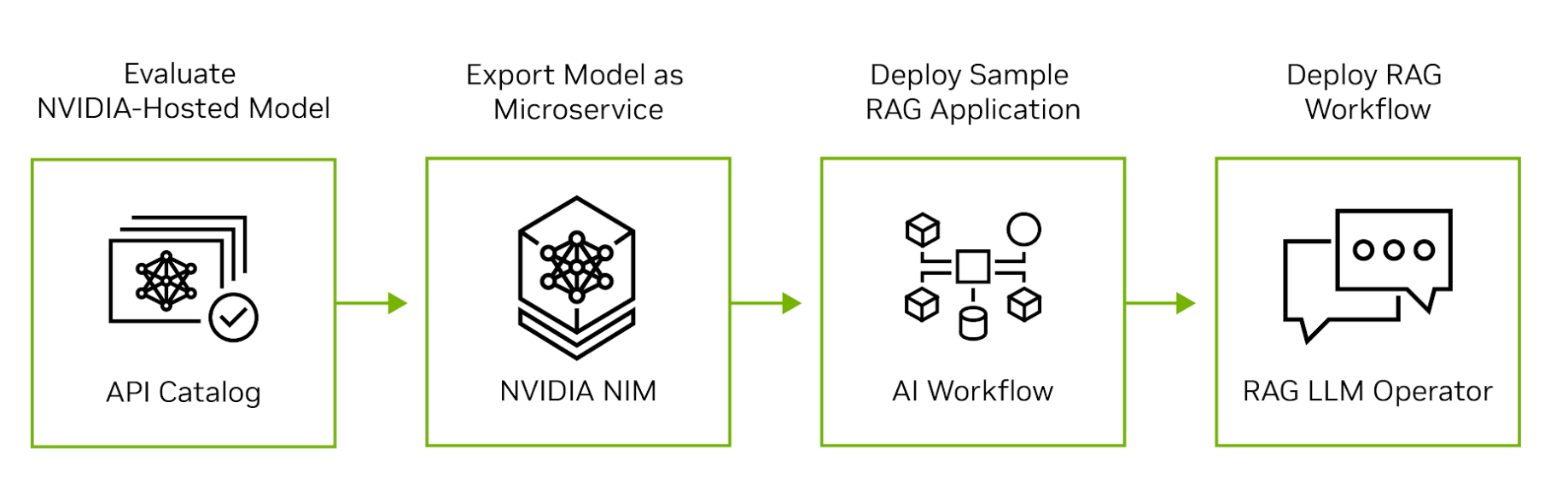

NVIDIA AI 從云擴展到芯片,為 RAG 應用開發、部署和運營的每個階段提供支持。圖 2 顯示了將 RAG 應用從評估遷移到生產的四個步驟。

第 1 步:評估 NVIDIA API 目錄中的 LLM

首先,請訪問 NVIDIA API 目錄,體驗在 NVIDIA GPU 上運行的領先開源和商用模型。開發者可以通過用戶界面與模型進行交互,然后查看交互生成的后端 API 調用。API 調用可以導出為 Python、Go 或 TypeScript 代碼片段,也可以導出為 shell 腳本。

第 2 步:將模型導出為微服務

接下來,將模型導出為 NVIDIA NIM.NIM 是一種易于使用的自托管微服務,旨在加速生成式 AI 的部署。該微服務可以在任何主要云上作為虛擬機中的容器運行,也可以通過 Helm 將其安裝到 Kubernetes 集群中。如果您對數據隱私或安全有任何疑問,可以在自己的數據中心或虛擬私有云中評估模型。

第 3 步:開發 RAG 示例應用

在評估自托管模型后,探索 NVIDIA 生成式 AI 示例,以編寫 RAG 應用示例。這些示例展示了 NVIDIA 微服務如何與流行的開源 LLM 編程框架集成,從而實現端到端的 RAG 流程。數據科學家可以使用這些示例來調整應用性能并評估其準確性。 NVIDIA AI Enterprise 客戶還可以訪問 NVIDIA AI 工作流程,以了解如何將生成式 AI 示例應用于行業特定的用例。

第 4 步:將 RAG 工作流部署到生產環境

應用程序開發完成后,MLOps 管理員可以使用 NVIDIA RAG LLM Operator 將它部署到測試或生產命名空間。通過搶先體驗RAG LLM Operator,可以快速輕松地將 RAG 應用程序部署到 Kubernetes 集群中,而不需要重寫任何應用程序代碼。

RAG LLM 運算符在 NVIDIA GPU Operator 中運行,這是一款流行的基礎設施軟件,可以在 Kubernetes 上自動部署和管理 NVIDIA GPU。它簡化了生命周期管理的復雜性,并實現了 RAG 流程的無縫部署、擴展和管理。

提高生產力的 RAG 流程

生產 RAG 系統可以通過減輕工作量、使相關數據更易于查找以及實現事件自動化來提高工人的生產力。

NVIDIA 使用 RAG 流程來幫助構建安全的企業軟件。 NVIDIA CVE 分析工具將 NVIDIA NIM、NeMo Retriever 和 Morpheus 網絡安全 AI 框架相結合,以識別和篩選 NGC 容器中的常見漏洞和暴露 (CVE).這一關鍵的業務流程 (確保發布到 NGC 容器注冊表的所有容器的完整性) 現在需要數小時而不是幾天。

Deepset、桑迪亞國家實驗室、Infosys、Quantiphi、Slalom 和 Wipro 等組織正在利用 NVIDIA 生成式 AI 獲得寶貴見解,從而實現對企業數據的語義搜索。

Deepset 的全新“干草堆棧 2.0 (Haystack 2.0)”與 NVIDIA NIM 和 NeMo Retriever 的集成 幫助組織高效檢查 GPU 加速的 LLM,以支持 RAG 應用程序的快速原型設計。

**桑迪亞國家實驗室和 NVIDIA 正在合作評估新興的生成式 AI 工具,以便在提高準確性和性能的同時,更大限度地獲取數據見解。

Infosys 擴大了與 NVIDIA 的戰略合作,作為Infosys 生成式 AI的一部分,Infosys Topaz 借助 NVIDIA NeMo 為各行各業創建企業就緒型 RAG 應用。這些應用顛覆了規范,并為生物制藥臨床試驗報告自動化以及從超過 100000 份專有財務文檔中尋找見解等用例提供價值。

Quantiphi 采用 NVIDIA 加速的生成式 AI 來開發基于 RAG 的解決方案,這些解決方案可以從龐大的藥物研發文檔庫中提取見解,并通過優化針對人口統計和地理位置定制的零售供應鏈來幫助實現突破性成果。

Slalom 正在利用可靠的框架協助組織駕生成式 AI 和 RAG 的復雜性,包括設計、實施和治理,以降低風險并確保負責任地應用 AI。

借助 生成式 AI 工具,Wipro 正在幫助醫療健康組織改善向全美數百萬患者提供的服務,從而提高醫療效果。

開始使用

越來越多的企業開始采用生成式 AI 來應對復雜的業務挑戰并提高員工工作效率。許多企業還將在其產品中采用生成式 AI.企業可以依靠 NVIDIA AI Enterprise 提供的安全性、支持和穩定性,將其 RAG 應用程序從試點轉向生產。通過標準化 NVIDIA AI,企業獲得了忠實的合作伙伴,幫助他們跟上快速發展的 LLM 生態系統的步伐。

通過探索 NVIDIA 生成式 AI 示例,您可以開始構建聊天機器人,這些機器人能夠利用最新信息,并以自然語言準確回答特定領域的問題。

如果您想了解構建 RAG 應用的新創新和最佳實踐,請查看檢索增強生成會話,該會將在NVIDIA GTC 2024的3月18日至21日舉行。此外,您還可以參加 RAG 開發者日,了解如何使用人類語音界面構建由 RAG 驅動的應用。