NVIDIA 的使命是加快我們的時代達芬奇和愛因斯坦的工作,并賦予他們解決社會的巨大挑戰。隨著 人工智能?( AI )、 高性能計算 ( HPC )和數據分析的復雜性呈指數級增長,科學家需要一個先進的計算平臺,能夠在一個十年內實現百萬次的加速,以解決這些非同尋常的挑戰。

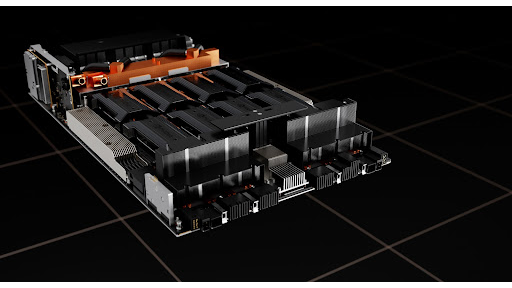

為了回答這個需求,我們介紹了NVIDIA HGX H100 ,一個由 NVIDIA Hopper 架構 供電的密鑰 GPU 服務器構建塊。這一最先進的平臺安全地提供了低延遲的高性能,并集成了從網絡到數據中心級計算(新的計算單元)的全套功能。

在這篇文章中,我將討論NVIDIA HGX H100 是如何幫助我們加速計算數據中心平臺的下一個巨大飛躍。

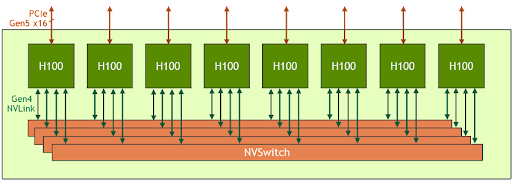

HGX H100 8-GPU

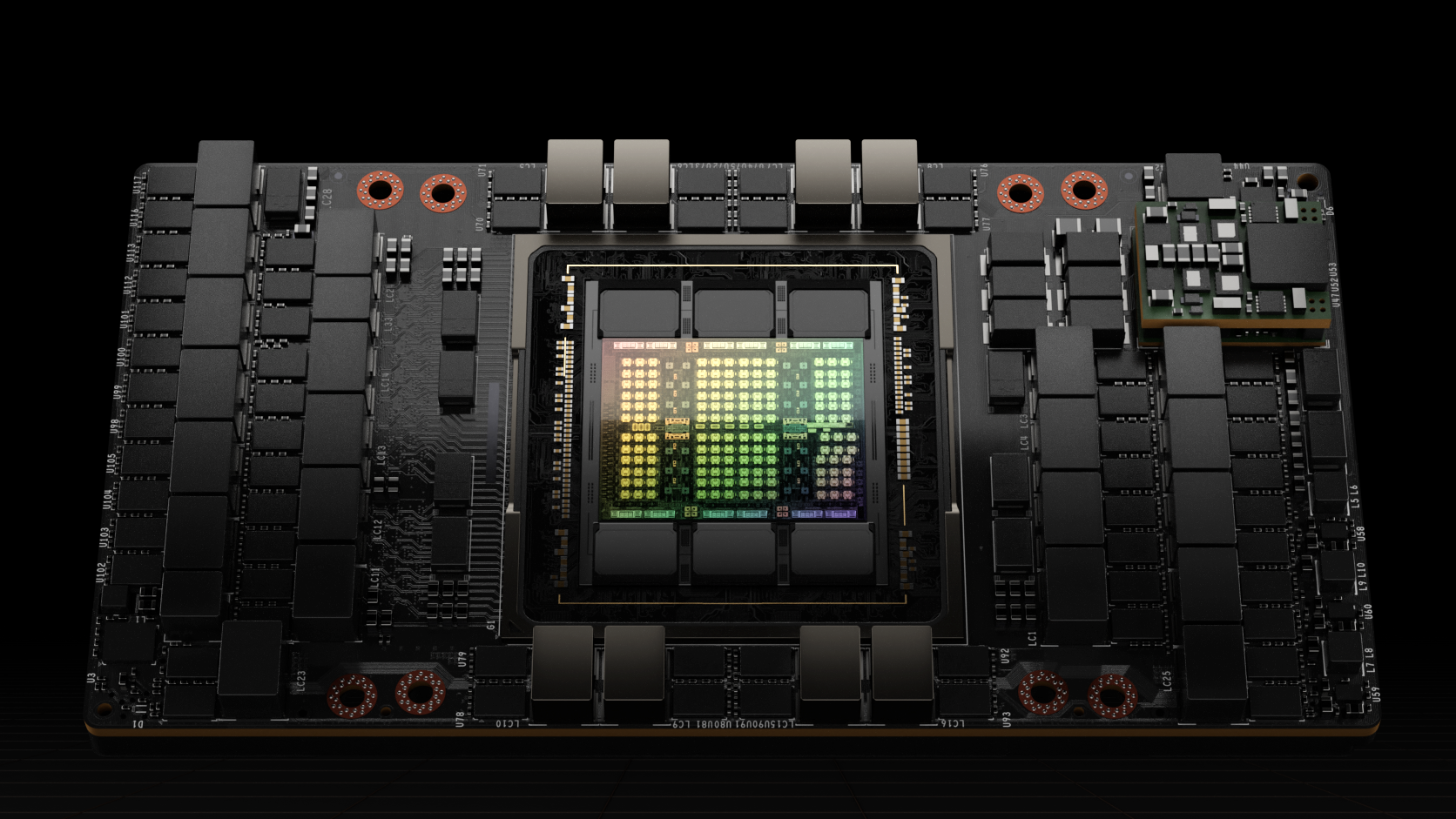

HGX H100 8- GPU 是新一代 Hopper GPU 服務器的關鍵組成部分。它擁有八個 H100 張量核 GPU 和四個第三代 NV 交換機。每個 H100 GPU 都有多個第四代 NVLink 端口,并連接到所有四個 NVLink 交換機。每個 NVSwitch 都是一個完全無阻塞的交換機,完全連接所有八個 H100 Tensor Core GPU 。

NVSwitch 的這種完全連接的拓撲結構使任何 H100 都可以同時與任何其他 H100 通話。值得注意的是,這種通信以每秒 900 千兆字節( GB / s )的 NVLink 雙向速度運行,這是當前 PCIe Gen4 x16 總線帶寬的 14 倍多。

第三代 NVSwitch 還為集體運營提供了新的硬件加速,多播和 NVIDIA 的網絡規模大幅縮減。結合更快的 NVLink 速度,像all-reduce這樣的普通人工智能集體操作的有效帶寬比 HGX A100 增加了 3 倍。集體的 NVSwitch 加速也顯著降低了 GPU 上的負載。

| ? | HGX A100 8-GPU | HGX H100 8-GPU | Improvement Ratio |

| FP8 | – | 32,000 TFLOPS | 6X (vs A100 FP16) |

| FP16 | 4,992 TFLOPS | 16,000 TFLOPS | 3X |

| FP64 | 156 TFLOPS | 480 TFLOPS | 3X |

| In-Network Compute | 0 | 3.6 TFLOPS | Infinite |

| Interface to host CPU | 8x PCIe Gen4 x16 | 8x PCIe Gen5 x16 | 2X |

| Bisection Bandwidth | 2.4 TB/s | 3.6 TB/s | 1.5X |

*注: FP 性能包括稀疏性

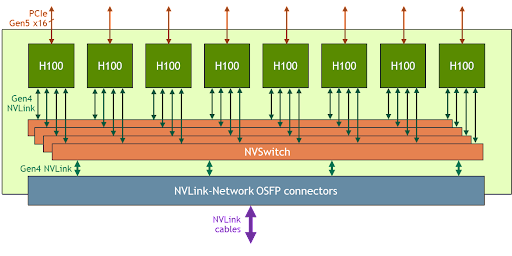

HGX H100 8- GPU 支持 NVLink 網絡

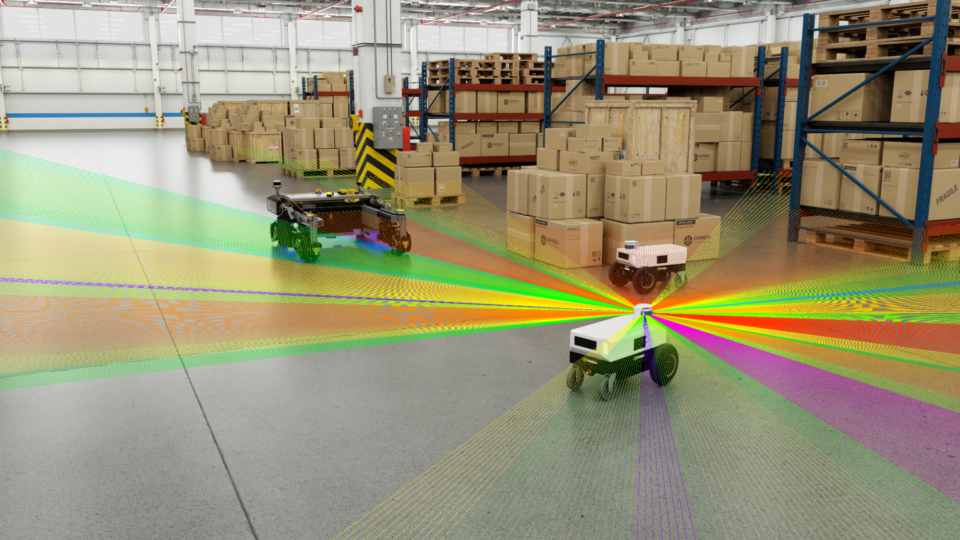

新興的 exascale HPC 和萬億參數人工智能模型(用于精確對話人工智能等任務)需要數月的訓練,即使是在超級計算機上。將其壓縮到業務速度并在數小時內完成培訓需要服務器集群中每個 GPU 之間的高速、無縫通信。

為了解決這些大的使用案例,新的 NVLink 和 NVSwitch 旨在使 HGX H100 8- GPU 能夠通過新的 NVLink 網絡擴展并支持更大的 NVLink 域。 HGX H100 8- GPU 的另一個版本具有這種新的 NVLink 網絡支持。

使用 HGX H100 8- GPU 和 NVLink 網絡支持構建的系統節點可以通過八進制小尺寸可插拔( OSFP ) LinkX 電纜和新的外部 NVLink 交換機完全連接到其他系統。此連接最多支持 256 個 GPU NVLink 域。圖 3 顯示了集群拓撲。

| ? | 256 A100 GPU Pod | 256 H100 GPU Pod | Improvement Ratio |

| NVLINK Domain | 8 GPU | 256 GPU | 32X |

| FP8 | – | 1,024 PFLOPS | 6X (vs A100 FP16) |

| FP16 | 160 PFLOPS | 512 PFLOPS | 3X |

| FP64 | 5 PFLOPS | 15 PFLOPS | 3X |

| In-Network Compute | 0 | 192 TFLOPS | Infinite |

| Bisection Bandwidth | 6.4 TB/s | 70 TB/s | 11X |

*注: FP 性能包括稀疏性

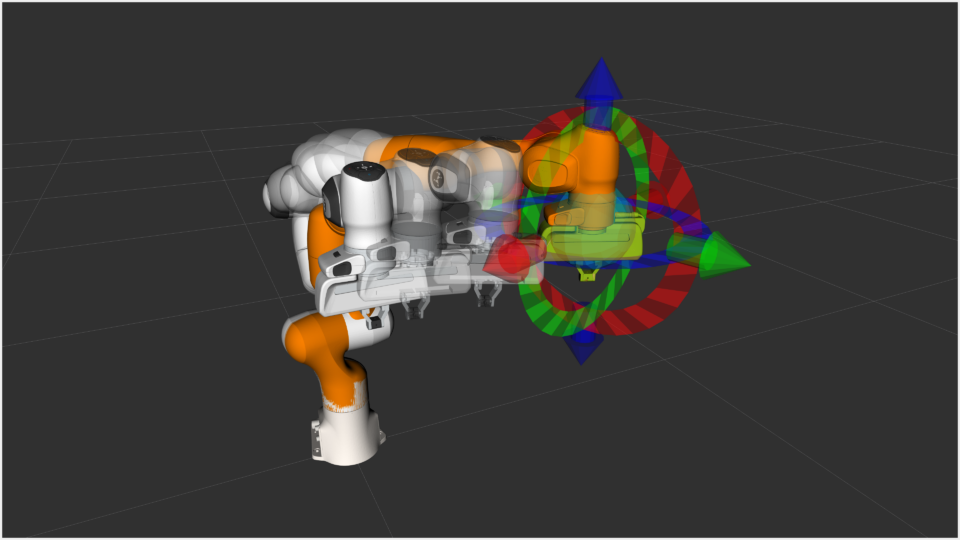

目標用例和性能優勢

隨著 HGX H100 計算和網絡能力的大幅增加, AI 和 HPC 應用程序的性能得到了極大的提高。

今天的主流 AI 和 HPC 模型可以完全駐留在單個節點的聚合 GPU 內存中。例如, BERT -Large 、 Mask R-CNN 和 HGX H100 是最高效的培訓解決方案。

對于更先進、更大的 AI 和 HPC 模型,該模型需要多個聚合 GPU 內存節點才能適應。例如,具有 TB 級嵌入式表的深度學習推薦模型( DLRM )、大量混合專家( MoE )自然語言處理模型,以及具有 NVLink 網絡的 HGX H100 加速了關鍵通信瓶頸,是此類工作負載的最佳解決方案。

圖 4 來自 NVIDIA H100 GPU 體系結構 白皮書顯示了 NVLink 網絡帶來的額外性能提升。

所有性能數據都是基于當前預期的初步數據,可能會隨著運輸產品的變化而變化。 A100 集群: HDR IB 網絡。 H100 集群: NDR IB 網絡和 NVLink 網絡,如圖所示。

# GPU :氣候建模 1K , LQCD 1K ,基因組學 8 , 3D-FFT 256 , MT-NLG 32 (批次大小: A100 為 4 , 1 秒 H100 為 60 , A100 為 8 , 1.5 和 2 秒 H100 為 64 ), MRCNN 8 (批次 32 ), GPT-3 16B 512 (批次 256 ), DLRM 128 (批次 64K ), GPT-3 16K (批次 512 ), MoE 8K (批次 512 ,每個 GPU 一名專家)?

HGX H100 4-GPU

除了 8- GPU 版本外, HGX 系列還具有一個 4-GPU 版本,該版本直接與第四代 NVLink 連接。

H100 對 H100 點對點對等 NVLink 帶寬為 300 GB / s 雙向,比今天的 PCIe Gen4 x16 總線快約 5 倍。

HGX H100 4- GPU 外形經過優化,可用于密集 HPC 部署:

- 多個 HGX H100 4- GPU 可以裝在 1U 高液體冷卻系統中,以最大化每個機架的 GPU 密度。

- 帶有 HGX H100 4- GPU 的完全無 PCIe 交換機架構直接連接到 CPU ,降低了系統材料清單并節省了電源。

- 對于 CPU 更密集的工作負載, HGX H100 4- GPU 可以與兩個 CPU 插槽配對,以提高 CPU 與 GPU 的比率,從而實現更平衡的系統配置。

人工智能和高性能計算的加速服務器平臺

NVIDIA 正與我們的生態系統密切合作,在今年晚些時候將基于 HGX H100 的服務器平臺推向市場。我們期待著把這個強大的計算工具交給你們,使你們能夠以人類歷史上最快的速度創新和完成你們一生的工作。

?