使用基礎模型構建 AI 系統需要在內存、延遲、存儲、計算等資源之間實現微妙的平衡。在將生成式 AI 功能引入快速發展的 AI 應用生態系統時,管理成本和用戶體驗的開發者無法做到一刀切。

您需要高質量、可定制的模型選項,以便支持在數據中心、邊緣計算和設備端用例等不同計算環境中托管和部署的大規模服務,例如使用 GPU、DPU 和 Jetson 等硬件加速。

Google DeepMind 剛剛宣布推出 Gemma 3,這是一系列新的多模態和多語言開放模型。Gemma 3 由一個 1B 純文本小語言模型 (SLM) 和三個大小為 4B、12B 和 27B 的圖像文本模型組成。您可以使用 Hugging Face 中的模型,并在 NVIDIA API Catalog 中演示 1B 模型。

Gemma 3 1B 模型經過優化,可在需要低內存占用的設備應用程序或環境中高效運行,輸入高達 32K 個令牌。Gemma 3 4B、12B 和 27B 模型可接受多達 128K 個令牌的文本、圖像和多圖像輸入。

使用優化的 Gemma 3 模型進行實驗和原型設計

在 NVIDIA API Catalog 中探索此模型,您可以在其中試驗自己的數據并配置參數,例如最大 tokens 數以及溫度和 top P 的采樣值。

預覽還將在 Python、NodeJS 和 Bash 中生成所需的代碼,以便將模型集成到您的程序或工作流程中。如果您將 LangChain 用于構建代理、連接外部數據或關聯操作,則可以使用使用 NVIDIA LangChain 庫 生成的可重復使用客戶端。

要開始使用您自己的環境,請執行以下步驟:

- 使用 NVIDIA API Catalog 創建一個免費帳戶。

- 前往 Gemma 3 模型卡。

- 選擇 使用此 NIM 進行構建 以及 生成 API 密鑰 。

- 將生成的密鑰另存為

NVIDIA_API_KEY。

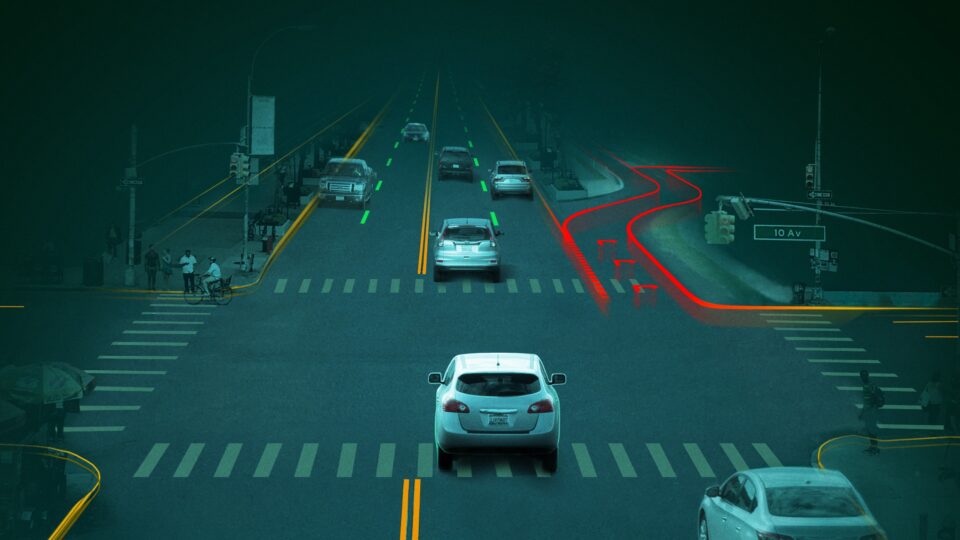

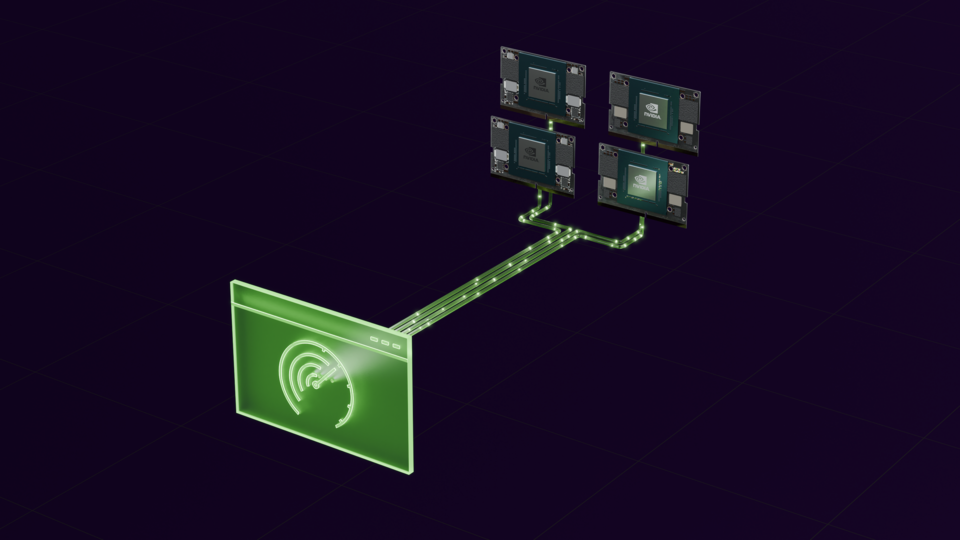

適用于新一代機器人和邊緣解決方案的下一代人工智能(Next-level AI)

每個 Gemma 3 模型都可以部署到 NVIDIA Jetson 系列嵌入式計算板上,用于機器人和邊緣 AI 應用。較小的版本 1B 和 4B 可在 Jetson Nano 這樣的小型設備上使用。專為高需求應用打造的 27B 模型可在支持高達 275 TOPS 的 Jetson AGX Orin 上提供服務。有關更多信息,請參閱最新的 Jetson Orin Nano Developer Kit 公告。

NVIDIA 和 Google 的持續合作

Google DeepMind 和 NVIDIA 合作開發了 Gemma 的每個版本。NVIDIA 在優化 GPU 模型方面發揮了關鍵作用,為 JAX、Python 機器學習庫、Google 的 XLA 編譯器、OpenXLA 等做出了貢獻。

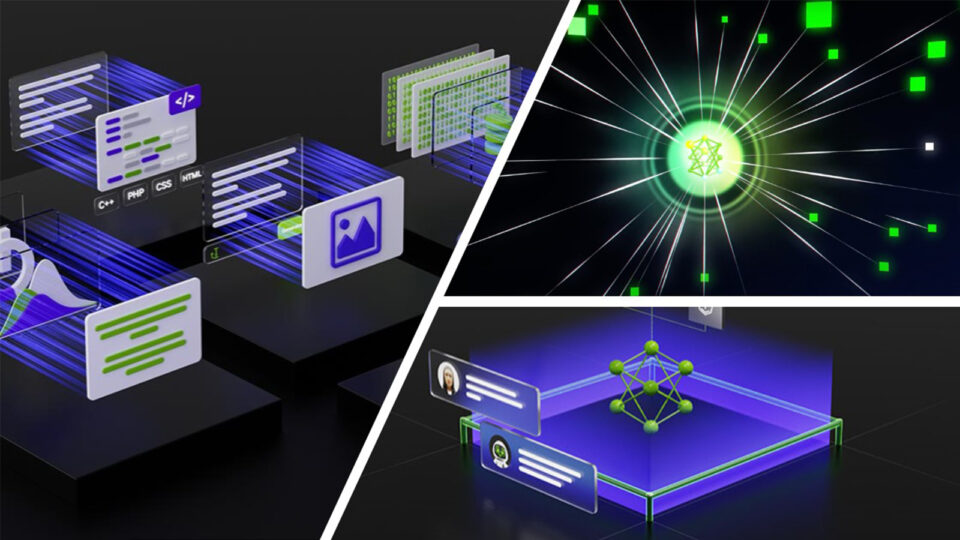

推進社區模型和協作

NVIDIA 是開源生態系統的積極貢獻者,已根據開源許可證發布了 數百個項目 。

NVIDIA 致力于開發 Gemma 等開放模型,以提高 AI 透明度,并讓用戶廣泛分享在 AI 安全性和彈性方面的工作。借助 NVIDIA NeMo 平臺 ,這些開放模型可以根據專有數據進行定制和調整,適用于各行各業的 AI 工作流。

立即開始使用

在 NVIDIA API Catalog 中的 Gemma 模型 上引入您的數據并在 NVIDIA 加速平臺上試用 Gemma。

?

?