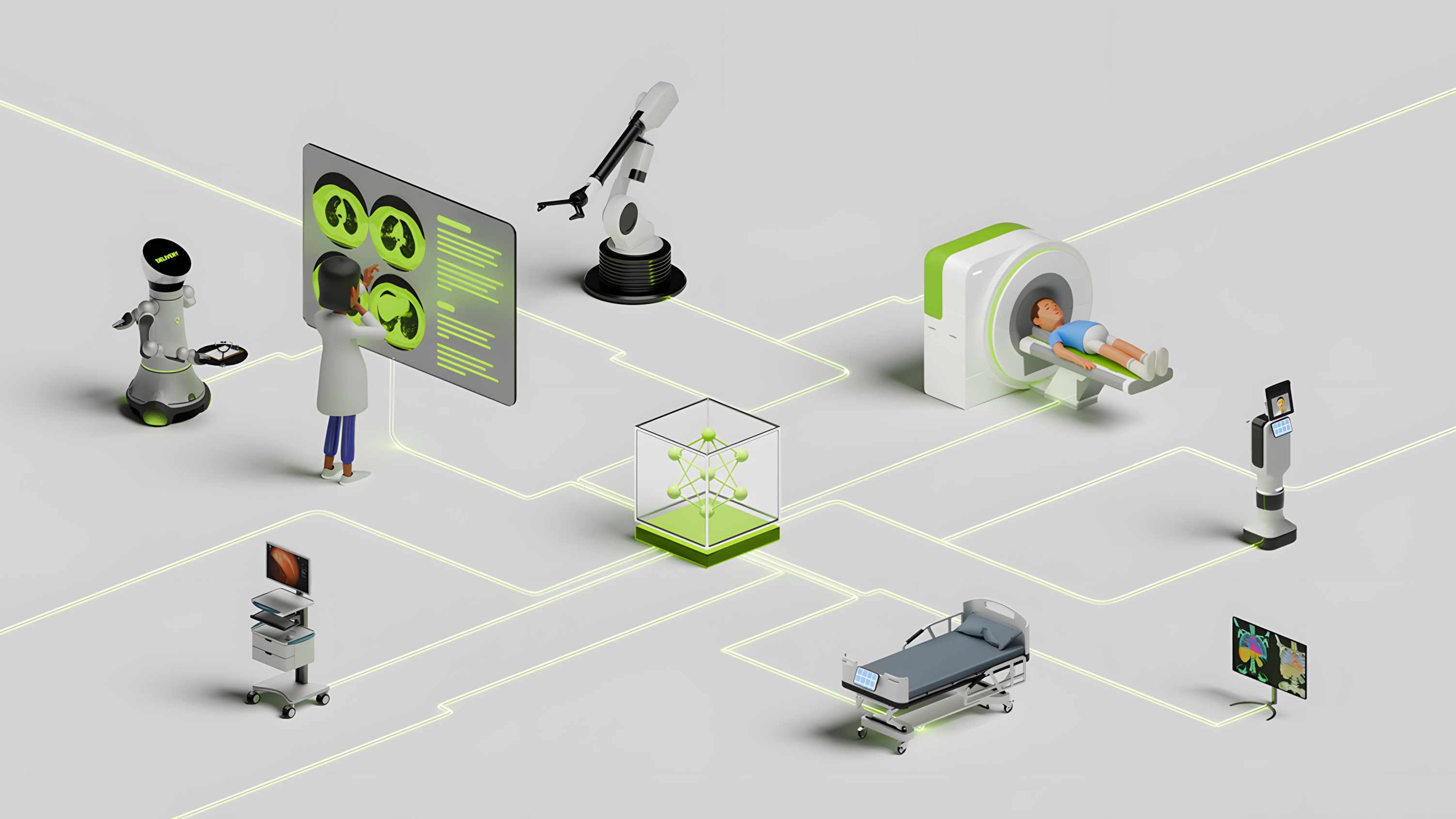

醫療數據的數量和復雜性不斷增加,以及對早期疾病診斷和提高醫療效率的迫切需求,正在推動醫療 AI 取得前所未有的進步。該領域最具變革性的創新包括同時處理文本、圖像和視頻的多模態 AI 模型。與傳統的單模態系統相比,這些模型能夠更全面地理解患者數據。

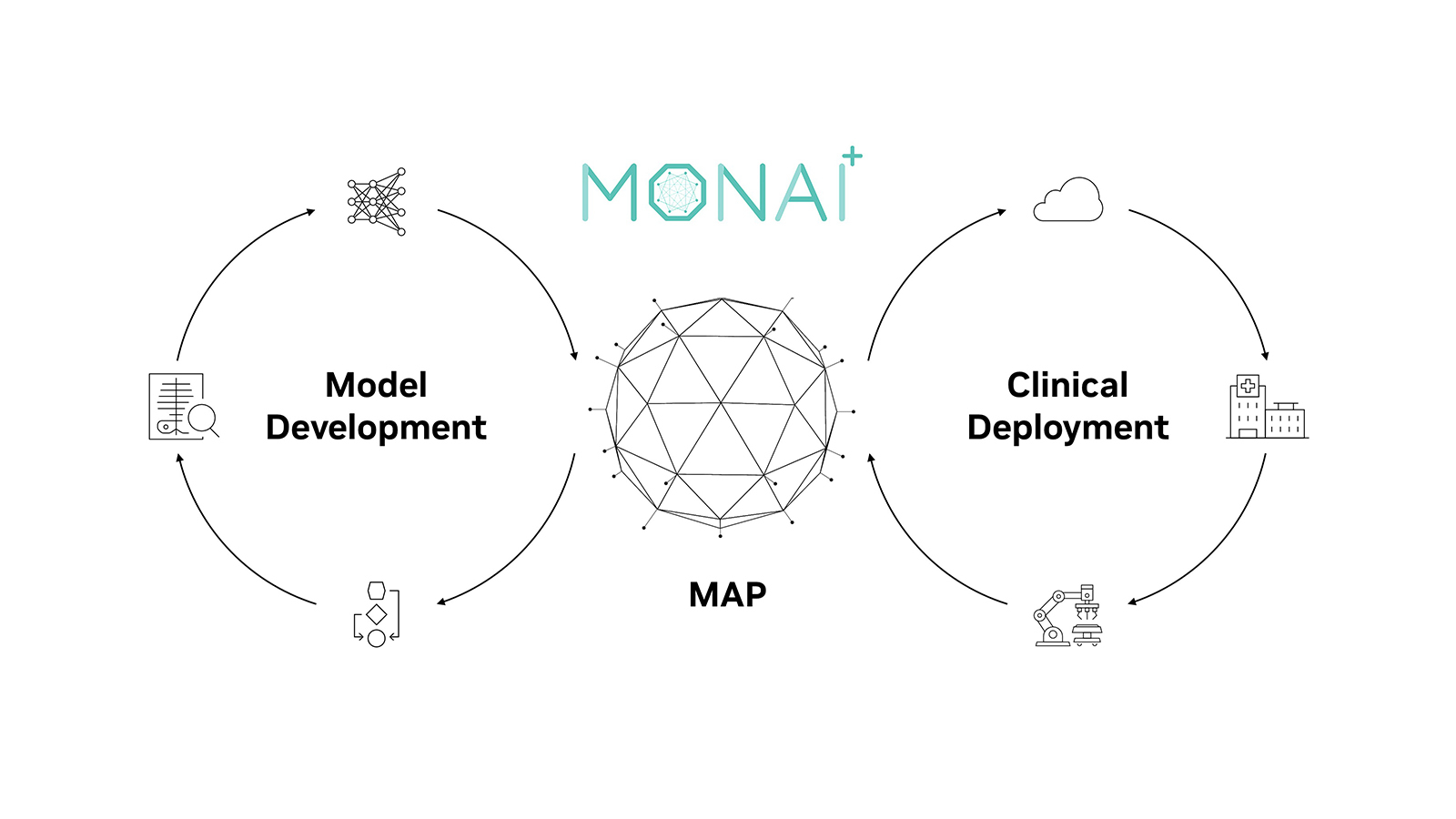

MONAI 是發展最快的開源醫學影像框架,它正在不斷發展,以集成強大的多模態模型,從而徹底改變臨床工作流程和診斷精度。在過去五年中,MONAI 已成為領先的醫療 AI 平臺,也是影像 AI 研究的事實框架。它的下載量超過 4.5 萬次,出現在 3,000 多篇已發表的論文中。

本文介紹了 MONAI 如何利用先進的 代理式 AI (自主、工作流驅動的推理) ,將其從成像擴展到多模態生態系統。該生態系統集成了從 CT 和 MRI 到 EHR 和臨床文檔的各種醫療健康數據,以推動放射學、外科和病理學領域的研究開發和創新。

MONAI 多模態:連接醫療健康數據孤島

隨著醫療數據變得越來越多樣化和復雜,對統一不同數據源的全面解決方案的需求從未如此強烈。MONAI Multimodal 代表了一項集中努力,旨在將傳統的成像分析擴展到集成的研究生態系統。它將各種醫療健康數據 (包括 CT、MRI、X 光、超聲波、EHR、臨床文檔、DICOM 標準、視頻流和全切片成像) 相結合,為研究人員和開發者實現多模態分析。

主要增強功能包括:

- 代理式 AI 框架:使用自主智能體對圖像和文本進行多步驟推理

- 專用 LLMs 和 VLMs:專為支持跨模態數據集成的醫療應用而設計的定制模型

- 數據 IO 組件:集成各種數據 IO 讀取器,包括:用于醫學影像的 DICOM (例如 CT 和 MRI)適用于結構化和非結構化臨床數據的 EHR 手術記錄和動態成像的視頻適用于大型高分辨率病理學圖像的 WSI 臨床筆記和其他文本數據的文本病理學切片或靜態圖像的圖像 (PNG、JPEG、BMP)

Monai 多模態平臺采用先進的代理式 AI,利用自主智能體對圖像和文本以及專用 LLM 和 VLM 進行多步驟推理,這些模型專為醫療應用設計,可簡化跨模態數據集成。協作生態系統涉及 NVIDIA、主要研究機構、醫療健康組織和學術中心。這種統一的方法通過為醫療 AI 創新提供一致、可復制的框架,加速研究并增強臨床協作。

RadImageNet 的放射科醫生兼管理合作伙伴 Tim Deyer MD 表示:“通過通過先進的多模態模型集成不同的數據流,我們不僅提高了診斷準確性,還從根本上改變了臨床醫生與患者數據的交互方式。”“這項創新為醫療健康領域更快、更可靠的決策鋪平了道路。”

適用于統一醫療 AI 研究平臺的 MONAI 多模態構建塊

作為更廣泛計劃的一部分,MONAI 多模態框架由幾個旨在支持跨模態推理和集成的核心組件組成。

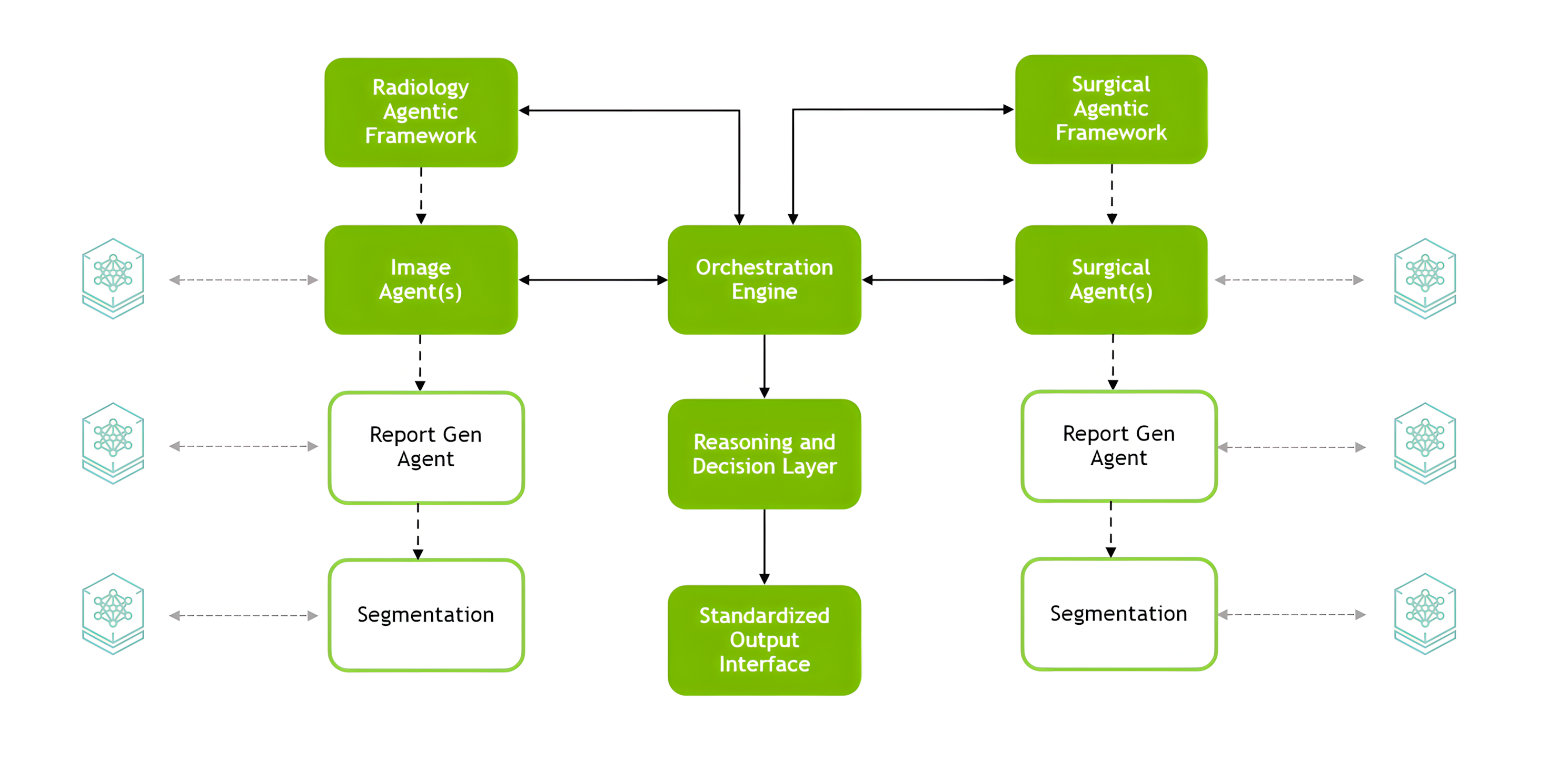

代理式框架

智能體框架是一種用于部署和編排多模態 AI 智能體的參考架構,通過將圖像和文本數據與類似人類的邏輯集成來實現多步驟推理。它通過基于代理的可定制處理支持自定義工作流,并通過輕松橋接視覺和語言組件來降低集成復雜性。

MONAI 智能體架構采用模塊化設計,支持醫療 AI 的跨模態推理。它具有協調專用智能體 (例如 Radiology Agent Framework 和 Surgical Agent Framework) 的中央編排引擎、用于一致部署的接口,以及提供標準化輸出的推理和決策層 (圖 1)。

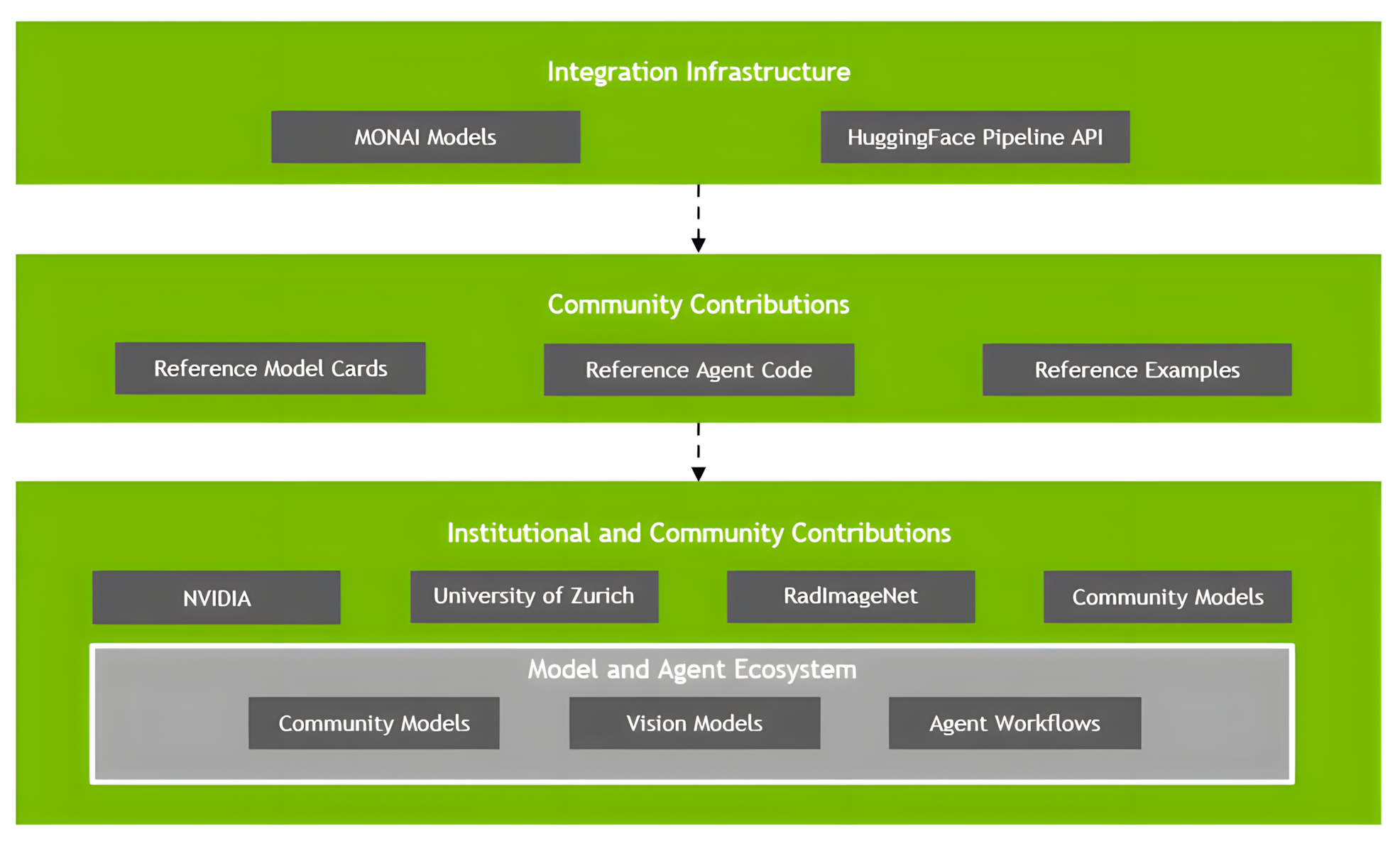

基金會模型和社區貢獻

MONAI 多模態平臺由一套先進的模型提供支持,將 NVIDIA 主導的框架與社區合作伙伴的創新相結合,詳情如下。

NVIDIA 主導的框架

NVIDIA 主導的框架包括以下內容。

Radiology Agent Framework (Multimodal Radiology Agentic Framework) :以放射學為重點的智能體框架,將醫學影像與文本數據相結合,協助放射科醫生進行診斷和解讀。

主要特性:

- 將 3D CT/MR 成像與患者 EHR 數據集成

- 利用大語言模型(LLMs)和視覺語言模型(VLMs)進行全面分析

- 按需訪問專業模型(VISTA-3D、MONAI BraTS、TorchXRayVision)

- 使用 Meta Llama 3 構建

- 處理多個數據流以獲得詳細輸出

- 通過將問題分解為可管理的步驟來執行復雜的推理任務

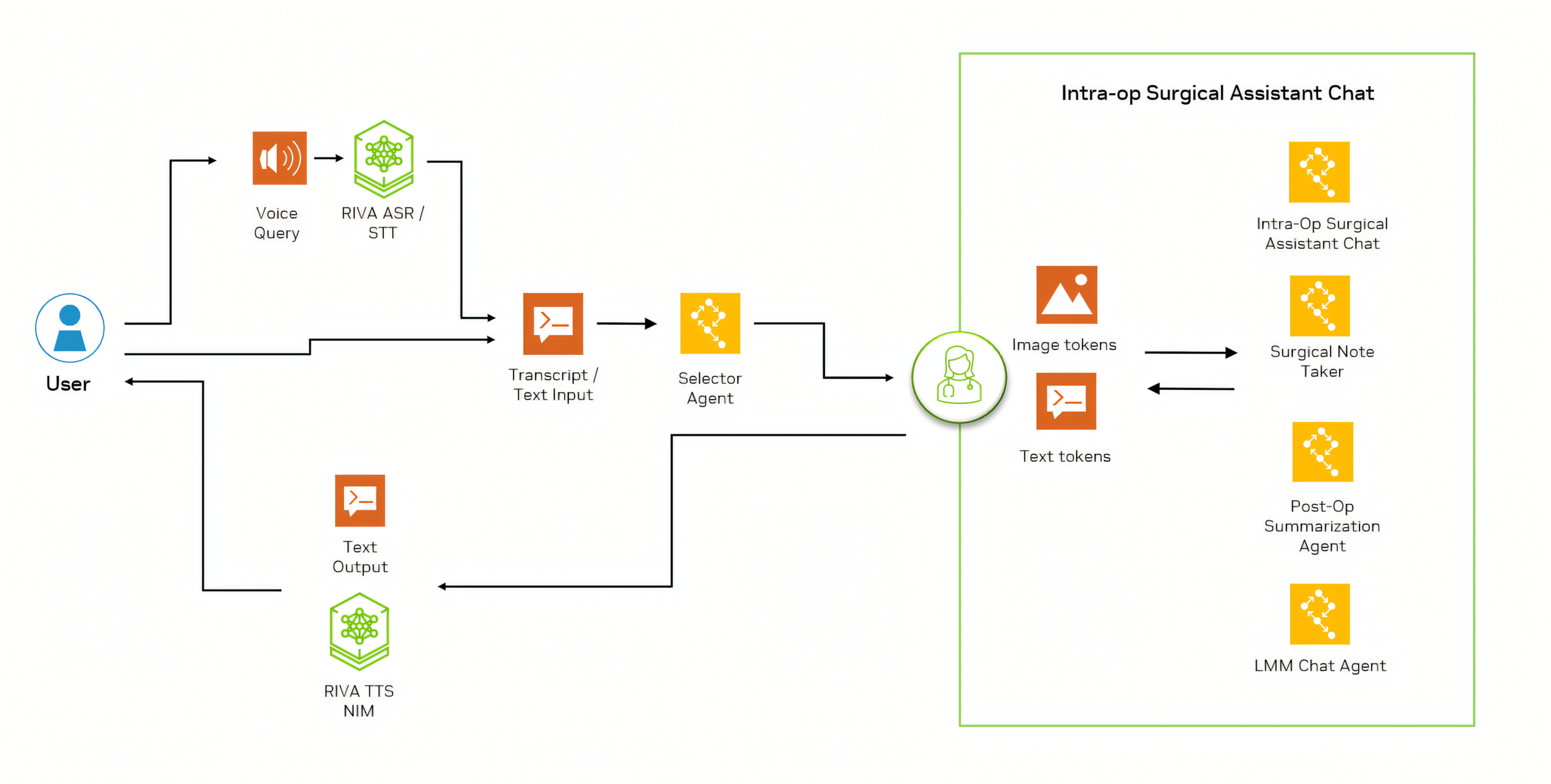

Surgical Agent 框架 (Multimodal Surgical Agentic Framework) : VLM 和檢索增強生成 (RAG) 的定制組合,專為手術應用而設計。它通過多智能體系統為手術工作流程提供端到端支持。

主要特性:

- 通過 Whisper 實現實時語音轉錄

- 用于查詢路由、Q&A、文檔、注釋和報告的專用智能體

- 用于圖像分析的計算機視覺(Computer Vision)集成

- 可選的語音響應功能

- 集成患者特定的術前數據、臨床醫生偏好和醫療設備知識

- 實時處理術中數據

- 在手術的所有階段(訓練、規劃、指導和分析)中發揮數字助理的作用

社區主導的合作伙伴模式

社區主導的合作伙伴模式包括以下內容。社區主導的合作伙伴模式包括

RadViLLA:RadViLLA 是一款用于放射學的 3D VLM,由 Rad Image Net 、 西奈山伊坎醫學院的生物醫學工程和影像研究所 和 NVIDIA 共同開發,擅長回答胸部、腹部和骨盆的臨床查詢。 RadViLLA 基于 75,000 次 3D CT 掃描和超過 1 million 個視覺問答對進行訓練。

它側重于頻繁成像的解剖結構,如胸部、腹部和骨盆,并采用新穎的兩階段訓練策略,將 3D CT 掃描與文本數據集成在一起。RadviLLA 可自主響應臨床查詢,并在 F1 評分和跨多個數據集的平衡準確性方面展現出卓越的性能。

CT-CHAT:由蘇黎世大學開發的 CT-CHAT 是一種先進的視覺語言基礎聊天模型,專門用于增強 3D 胸部 CT 成像的解釋和診斷能力。 它利用 CT-CLIP 框架 和根據 CT-RATE 改編的視覺問答 (VQA) 數據集。

它基于 CT-RATE 提供的 270 多萬個問答對進行訓練,利用 3D 空間信息,使其優于基于 2D 的模型。CT-CHAT 通過將 CT-CLIP 的視覺編碼器與預訓練的大語言模型相結合,在減少解釋時間和提供準確的診斷見解方面表現出色,這使其成為醫學成像的強大工具。

Hugging Face 集成

標準化工作流支持,可將 MONAI Multimodal 與 Hugging Face 研究基礎架構相連接:

- 用于研究的模型共享

- 集成新模型

- 更廣泛地參與研究生態系統

社區整合

用于模型共享、驗證和協作開發的基礎架構

- 標準化模型卡和智能體工作流

- 知識交流和最佳實踐共享

- 協作研究的基礎

使用 MONAI 多模態構建醫療 AI 的未來

MONAI 多模態代表了 MONAI 這是領先的醫學影像 AI 開源平臺。在此基礎上,MONAI Multimodal 不僅擴展了成像領域,還集成了放射學和病理學、臨床筆記和 EHR 等各種醫療健康數據類型。

通過由 NVIDIA 主導的框架和合作伙伴貢獻組成的協作生態系統,MONAI Multimodal 通過專門的代理式架構提供先進的推理能力。通過打破數據孤島并實現無縫的跨模態分析,該計劃解決了跨專業的關鍵醫療挑戰,加速了研究創新和臨床翻譯。

通過統一不同的數據源并利用最先進的模型,MONAI Multimodal 正在改變醫療保健行業,助力臨床醫生、研究人員和創新者在醫學影像和診斷精度方面取得突破性成果。

我們共同創造的不僅僅是軟件,我們還在構建一個蓬勃發展的醫療 AI 創新生態系統,使全球研究人員、臨床醫生和患者受益。 開始使用 MONAI 。

與我們一起參加 NVIDIA GTC 2025 ,并查看以下相關會議: