自動音頻字幕 (Automated Audio Captioning) 任務的核心是從音頻輸入中生成自然語言描述。鑒于輸入 (音頻) 和輸出 (文字) 之間的不同模式,AAC 系統通常依靠 audio encoder 從聲音中提取相關信息,表示為 feature vectors,然后 decoder 用于生成文本描述。

這一研究領域對于開發使機器能夠更好地解釋周圍聲學環境并與之交互的系統至關重要。意識到其重要性的 Detection and Classification of Acoustic Scenes and Events(DCASE)社區自 2020 年以來舉辦了年度 AAC 競賽,吸引了全球超過 26 個學術界和行業的團隊參加。

收聽 Audio Example of a Recording Environment in a Forest 的結果。

在本文中,我們將深入探討在 DCASE 2024 AAC 挑戰賽 (將于 10 月 23 日至 25 日在日本東京舉辦) 中獲勝背后的核心創新。

- 通過采用多個音頻編碼器來增強編碼器-解碼器架構。

- 使用基于 LM 的任務激活提示來豐富信息的后期編輯。

這種架構通過使用不同粒度的編碼器提高了系統捕獲各種音頻特征的能力。多編碼器方法使我們能夠向解碼器提供更豐富、更互補的信息,從而顯著提高性能。

卡內基梅隆大學(CMU) 語言技術研究所 (LTI)的 Shinji Watabe 教授說:“這是一個很酷的方式,展示了我們的團隊與開源研究人員合作,為音頻和語言理解社區的進步做出的貢獻。”

多 agent 協作以提升性能

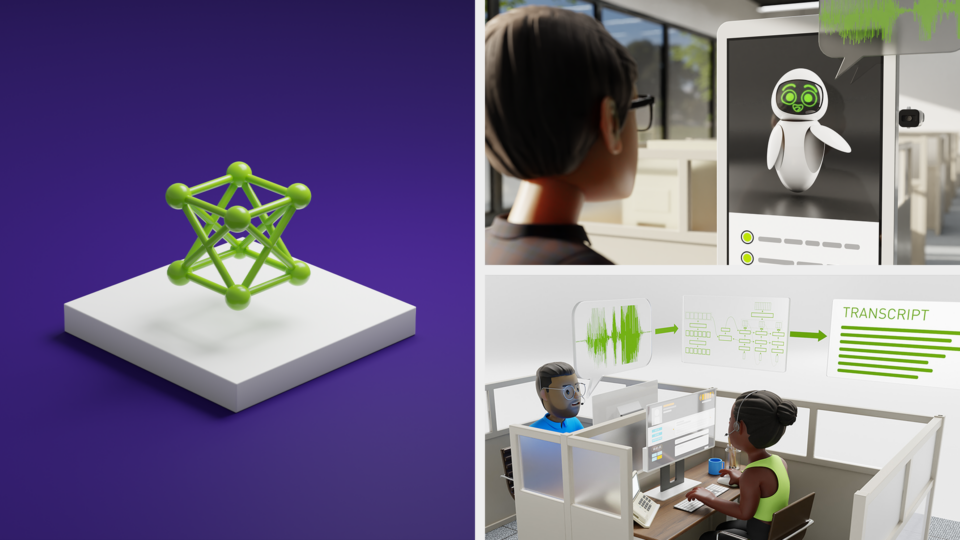

我們的方法最具創新性的方面之一是不同編碼器模型之間的多智能體協作,事實證明這是提高性能的關鍵因素。通過集成具有不同粒度的多個編碼器(例如 BEAT 和 ConvNeXt ),我們實現了音頻功能的更大覆蓋范圍。

這種融合編碼器的策略與多模態 AI 研究的近期突破性成果有相似之處,例如 MERL 和 CMU 的 2023 解決方案 ,其中結合不同的 agents ——每個 agent 專門處理任務的不同方面——可產生出色的結果。

在我們的系統中,我們采用了與那些論文中使用的概念類似的編碼器融合策略,使我們能夠利用每個編碼器的優勢。我們進一步考慮了基于文本假設的豐富性,包括近期 ACL 2024 中的 GenTranslate 和 NVIDIA Research 在 Taiwan 的 EMNLP 2024 中的 Generative Image Captioning ( GIC ) 評估,這些工作可實現描述豐富度自定義。例如,GenTranslate 和 GIC 均展示了多種語言模型如何協同提高跨語言語音翻譯的準確性,而 GenTranslate 則強調了多代理系統在生成式語音翻譯任務中的效率。

這兩個示例都強調了為復雜任務集成互補模型的價值,同時強化了我們的方法顯著提高 AAC 性能的潛力。我們介紹了如何在基于 GPU 的預訓練流程和后編輯流程中使用核心技術。

借助 NVIDIA DGX 和 NVIDIA OVX 平臺,先進的 NVIDIA 計算機技術,例如 Taipei-1 ( 全球 500 強中排名第 38 位的超級計算機集群 ),在加速這一先進的探索和研究開發方面也發揮了重要作用。

圖 2 顯示了基于編碼器融合、描述過濾和生成式摘要的建模。生成式摘要部分基于 NVIDIA Research 之前的工作 GenTranslate?。

模型背后的核心聲學建模技術

我們的系統架構受到 CMU 和 MERL 去年的獲獎開源模型 的啟發,并引入了一些改進:

- 多編碼器融合 :我們采用兩個預訓練音頻編碼器(BEATs 和 ConvNeXt)來生成互補的音頻表示。這使得解碼器能夠處理更廣泛的特征集池,從而獲得更準確、更詳細的字幕。

- 多層聚合 :不同的編碼器層捕獲輸入音頻的各個方面,通過聚合所有層的輸出,我們進一步豐富了輸入解碼器的信息。

- 生成式字幕建模 :為了優化自然語言描述的生成,我們應用了基于 大語言模型(LLM) 的摘要過程,這與 RobustGER 中使用的方法類似。此步驟將多個候選描述整合為一個流暢的輸出,使用 LLM 確保描述的語法一致性和類似人類的感覺。

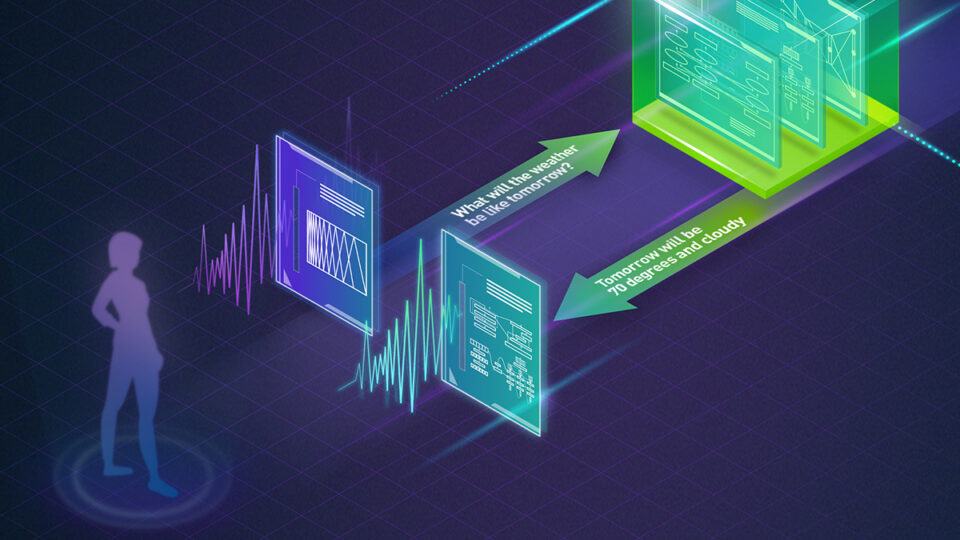

多智能體協作通過音頻、文本和 LLM 集成

除了多編碼器架構之外,我們還開發了一種新的多智能體協作推理管道。近期的研究顯示了在 AAC 任務中進行 nucleus sampling 的優勢,因此我們改進了傳統的 beam search 方法。

我們的推理流程遵循一個三階段管道:

- 基于 CLAP 的字幕過濾 :我們生成多個候選字幕,并使用 Contrastive Language-Audio Pretraining (CLAP) 模型過濾相關性較低的字幕,從而將候選字幕的數量減半。

- 混合重排名 :然后使用我們的混合重排名方法對其余標題進行排名,以選擇排名靠前的 k 個最佳標題。

- LLM 總結 :最后,我們使用任務激活 (即 [conditional prompt] do you know audio captioning?) LLM 將 k-best 描述總結為單個連貫的一致的描述,確保最終輸出捕獲音頻的所有關鍵方面。

這種新型推理工作流利用了音頻處理和語言建模的優勢,顯著提高了模型在上下文中準確描述的能力,將文本解碼為下游文本代理的特征圖形式。

影響和性能?

我們的多編碼器系統的 Fluency Enhanced Sentence-BERT Evaluation (FENSE) 評分為 0.5442,優于基準評分 0.5040。通過整合多 agent 系統,我們為進一步改進 AAC 任務開辟了新的途徑。

未來的工作將探索集成更先進的融合技術,并研究專業代理之間的進一步協作如何提高生成的描述的粒度和質量。

我們希望,我們的貢獻能夠激發我們對多智能體 AI 系統的持續探索,并鼓勵其他團隊采用類似策略來融合各種模型來處理復雜的多模態任務,如 AAC。

在圖 3 中,分數越高意味著從音頻上下文中捕獲的詳細信息越多,信息越豐富。

使用 NVIDIA 的 GPU 技術實現性能和可擴展性

得益于多編碼器融合和 LLM-driven summarization 之間的協同作用,我們的解決方案在語義理解分數方面比其他參與者高出(相對)10%以上。這一成功凸顯了多代理、多模態系統在推進通用理解方面的潛力。

使用基于 LLM 的多對一文本校正是此過程中的一項關鍵創新,使模型能夠更好地利用文本建模代理的計算能力。這方法檢索和優化嵌入音頻中的隱藏信息,從而提高系統的整體性能。

這種方法基于 NVIDIA 在多模態 AI 領域的先進工作成果,例如擅長多語種語音和文本翻譯的 GenTranslate 模型。同樣,我們最近的 Audio Flamingo 項目、 Synthio 項目以及 NVIDIA 應用深度學習研究 (ADLR)的 數據集 也展示了先進的音頻編碼器預訓練技術的強大功能。

這些系統以及我們屢獲殊榮的 AAC 解決方案均受益于 NVIDIA A100 和 NVIDIA H100 GPUs,不僅加速了 AI 開發,還突破了多模態學習的極限。來自 NVIDIA Research 的 Huck Yang 受邀在 DCASE Workshop 2024 計劃期間參加了有關音頻語言技術的技術小組討論。

?