幾年前,NVIDIA 創始人兼首席執行官黃仁勛親自交付了世界上第一臺NVIDIA DGX AI 系統到 OpenAI 。至今,OpenAI 的 ChatGPT 已經在全球范圍內大受歡迎,這凸顯了人工智能(AI)以及如何將其應用于各行各業,無論是小型企業還是大型企業。

現在,你有沒有停下來思考一下托管和支持 ChatGPT 所需的技術和基礎設施?

在這段視頻中,微軟 Azure 首席技術官 Mark Russinovich 解釋了他們專門構建的人工智能超級計算機基礎設施背后的技術堆棧。它是由 NVIDIA、Microsoft Azure 和 OpenAI 合作開發的,用于托管 ChatGPT 和其他大型語言模型(LLMs)以任何規模。

主要收獲

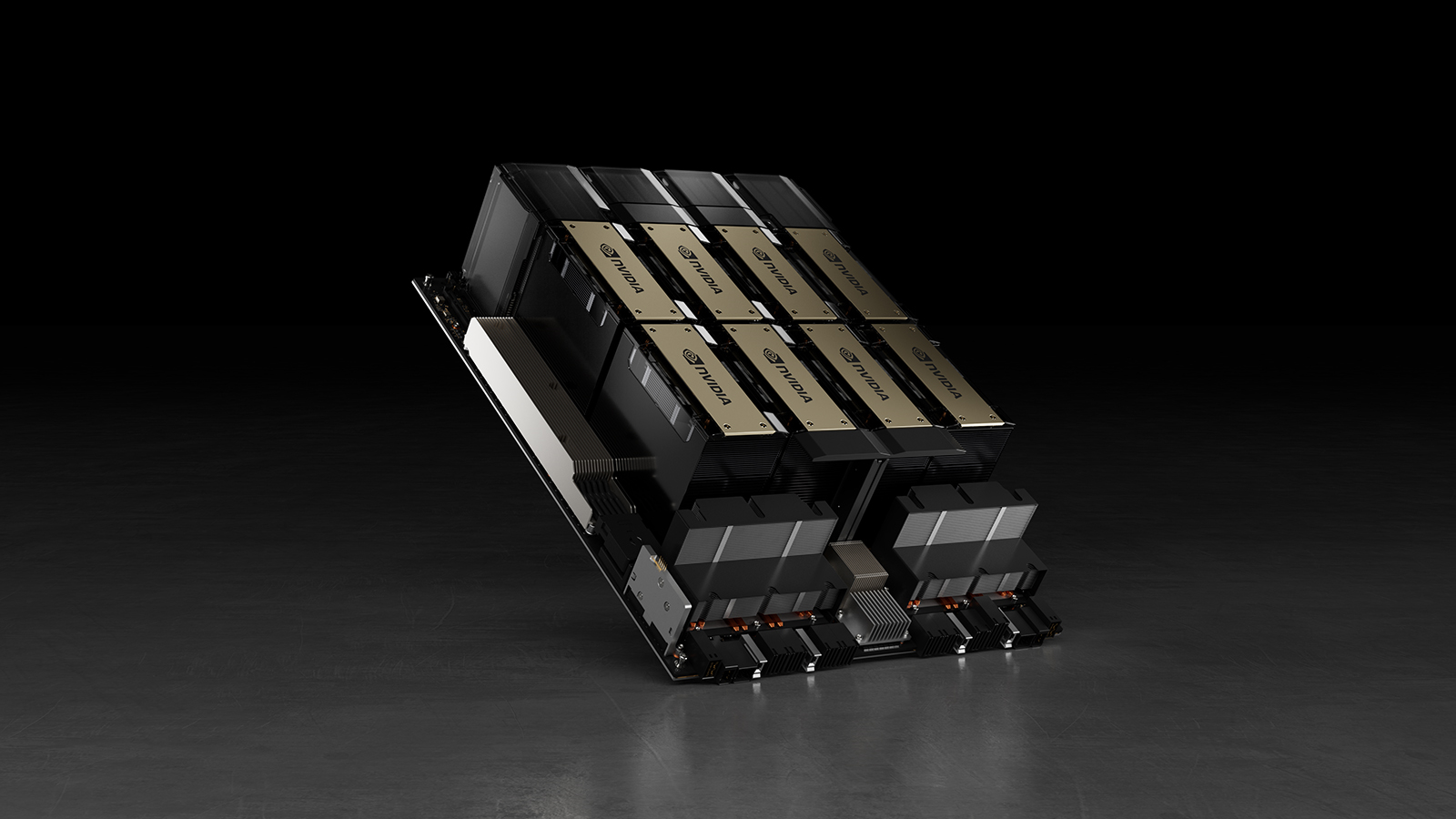

- NVIDIA H100 Tensor Core GPUs 的數據并行方法使推理性能提高了 30 倍,模型訓練性能提高了 4 倍。

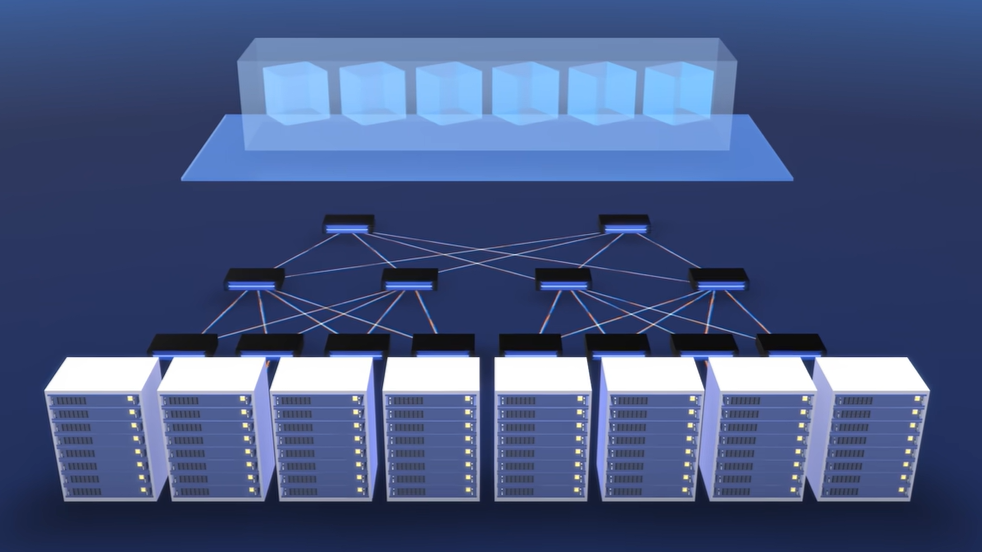

- 滿足LLM 的更高處理要求,虛擬機可以使用NVIDIA Quantum-2 InfiniBand聯網進行擴展。

- 大規模訓練不可避免地會出現服務器故障和網絡故障。微軟的 Project Forge 引入了透明的檢查點,以快速恢復工作并在全球范圍內保持高水平的利用率

- 處理億級參數模型時,可以參考大型語言模型、提示工程和 P-Tuning 的介紹。

- Wayve 等行業先驅正在利用人工智能超級計算機基礎設施來實現計算密集型工作負載。

- 即將提供的支持機密計算可以在 Azure 上使用 NVIDIA H100 GPU,有助于保護敏感數據,保護正在使用的有價值的人工智能模型,實現人工智能的安全多方協作用例。

視頻 1. 什么在運行 ChatGPT ?微軟人工智能超級計算機內幕|馬克·魯西諾維奇

總結

當訓練具有數千億參數的人工智能模型時,高效的數據中心基礎設施是關鍵:從提高吞吐量和最大限度地減少服務器故障,到利用多 GPU 集群進行計算密集型工作負載。

有關優化數據中心基礎架構以可靠地大規模部署大型模型的更多信息,請參閱以下資源:

- NVIDIA AI platform:通過從計算到軟件、人工智能模型和服務的全棧創新,使 AI 開發更容易。

- Modern Data Centers:了解 IT 領導者如何擴展和管理數據中心,以輕松實現 NVIDIA AI 的采用。

- H100 Tensor Core GPU:結合技術創新,LLM 比上一代性能提升了 30 倍。

- NVIDIA NeMo:可以幫助您的企業構建、自定義和部署 LLM,以增強生成式 AI應用程序。

- NVIDIA Quantum InfiniBand 平臺

?