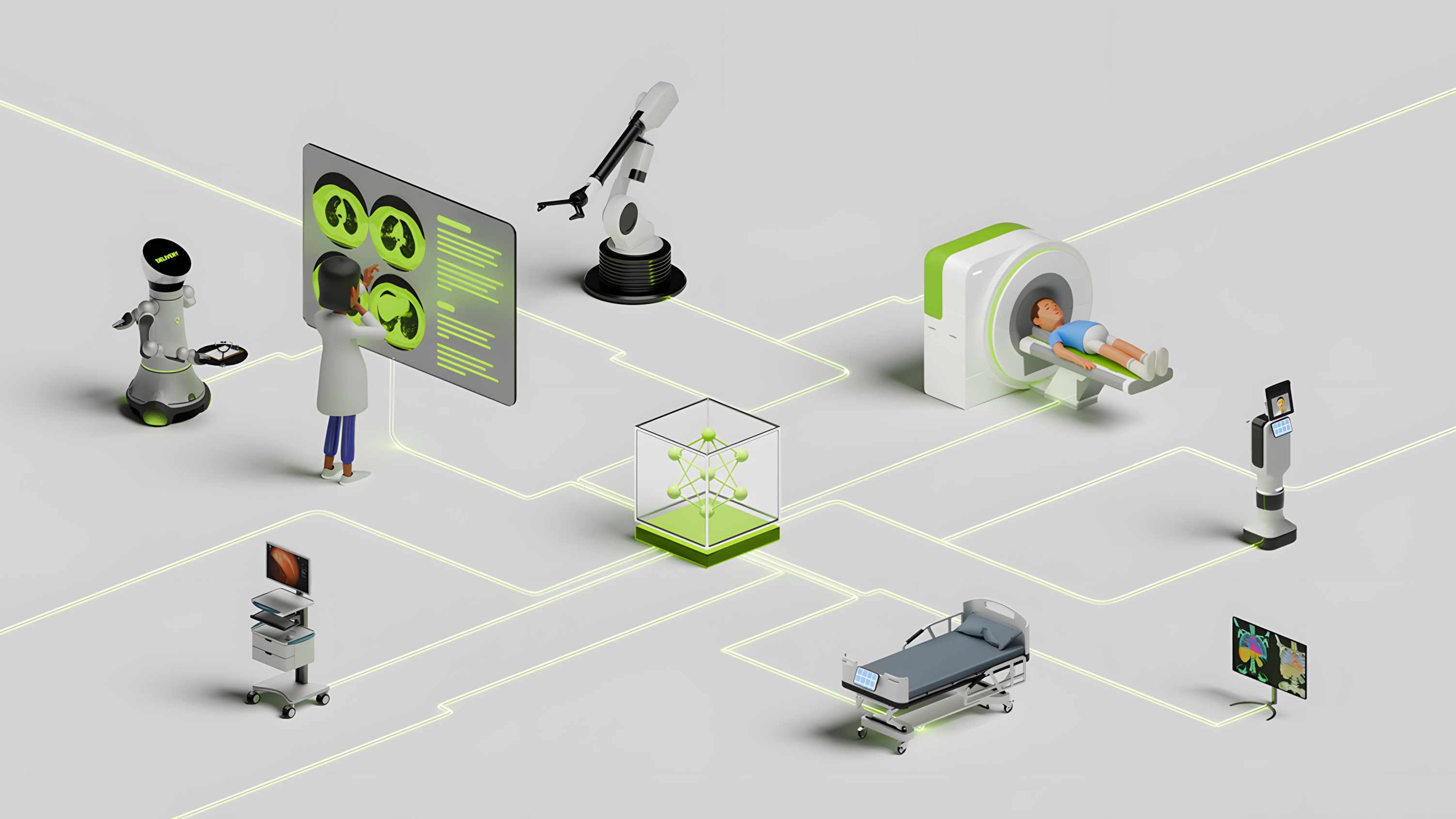

隨著生成式 AI 的快速增長,社區通過兩種重要方式加強了這種擴展:快速發布先進的基礎模型,以及簡化其與應用程序開發和生產的集成。

NVIDIA 通過優化基礎模型來增強性能、允許企業更快地生成令牌、降低模型運行成本,以及借助 NVIDIA NIM 改善最終用戶體驗,來幫助實現這一目標。

NVIDIA NIM

NVIDIA NIM 推理微服務旨在簡化和加速生成式人工智能模型在 NVIDIA 加速基礎設施(包括云、數據中心和工作站)中的部署。

NIM 利用 TensorRT-LLM 推理優化引擎、行業標準 API 和預構建容器,可提供低延遲、高吞吐量的 AI 推理,并可根據需求進行擴展。它支持各種 LLM,包括 Llama 3 8B, Mixtral 8x22B, Phi-3 以及 Gemma 以及針對特定領域應用的優化 speech, image, video, healthcare 等等。

NIM 可提供出色的吞吐量,使企業生成令牌的速度提升高達 5 倍。對于生成式 AI 應用,令牌處理是關鍵的性能指標,而令牌吞吐量的增加直接轉化為企業收入的增加。

通過簡化集成和部署流程,NIM 使企業能夠快速從 AI 模型開發轉向生產,從而提高效率、降低運營成本,并使企業專注于創新和發展。

現在,我們將在 Hugging Face 方面更進一步,幫助開發者在幾分鐘內運行模型。

只需單擊幾下,即可在 Hugging Face 上部署 NIM

Hugging Face 是適用于 AI 模型的領先平臺,由于它增強了 AI 模型的可訪問性,因此已成為 AI 開發者的首選平臺。

借助 NVIDIA NIM 利用無縫部署的強大功能,首先是通過您首選的云服務提供商訪問 Llama 3 8B 和Llama 3 70B,所有這些都可以直接從 Hugging Face 訪問。

NIM 可提供出色的吞吐量,并通過多個并發請求實現接近 100%的利用率,使企業生成文本的速度提高 3 倍。對于生成式 AI 應用程序,令牌處理是關鍵的性能指標,而令牌吞吐量的增加直接轉化為企業收入的增加。

Hugging Face 上的專用 NIM 端點可在您喜歡的云上旋轉實例,自動獲取并部署 NVIDIA 優化模型,并使您只需單擊幾下即可開始推理,這一切只需幾分鐘即可完成。

讓我們深入了解一下。

第 1 步:前往 Llama 3 8B 或7 億條指令 在 Hugging Face 上的模型頁面,然后單擊這些“Deploy”(部署)下拉菜單,然后從菜單中選擇“NVIDIA NIM 端點”。

第 2 步:系統將顯示一個帶有“Create a new Dedicated Endpoint”(使用 NVIDIA NIM 創建新的專用端點) 的新頁面。選擇您首選的 CSP 實例類型以在其上運行模型。AWS 上的 A10G/A100 和 GCP 實例上的 A100/H100 利用 NVIDIA 優化的模型引擎實現最佳性能。

第 3 步:在`Advanced configuration`(高級配置) 部分中,從 Container Type (容器類型) 下拉列表中選擇` NVIDIA NIM`,然后單擊`Create Endpoint`(創建端點)。

第 4 步:幾分鐘內即可啟動并運行推理端點。

開始使用?

部署 Llama 3 8B 和70B 在 Hugging Face 中的 NIM,可以縮短生成式人工智能解決方案的上市時間,通過高令牌吞吐量提高收入,并降低推理成本。

要體驗目前支持 40 多個多模態 NIM 的應用程序并對其進行原型設計,請訪問 ai.nvidia.com, NVIDIA 人工智能官方網站。

借助免費的 NVIDIA Cloud Credits,您只需幾行代碼即可集成 NVIDIA 托管的 API 端點,從而構建和測試原型應用。

?