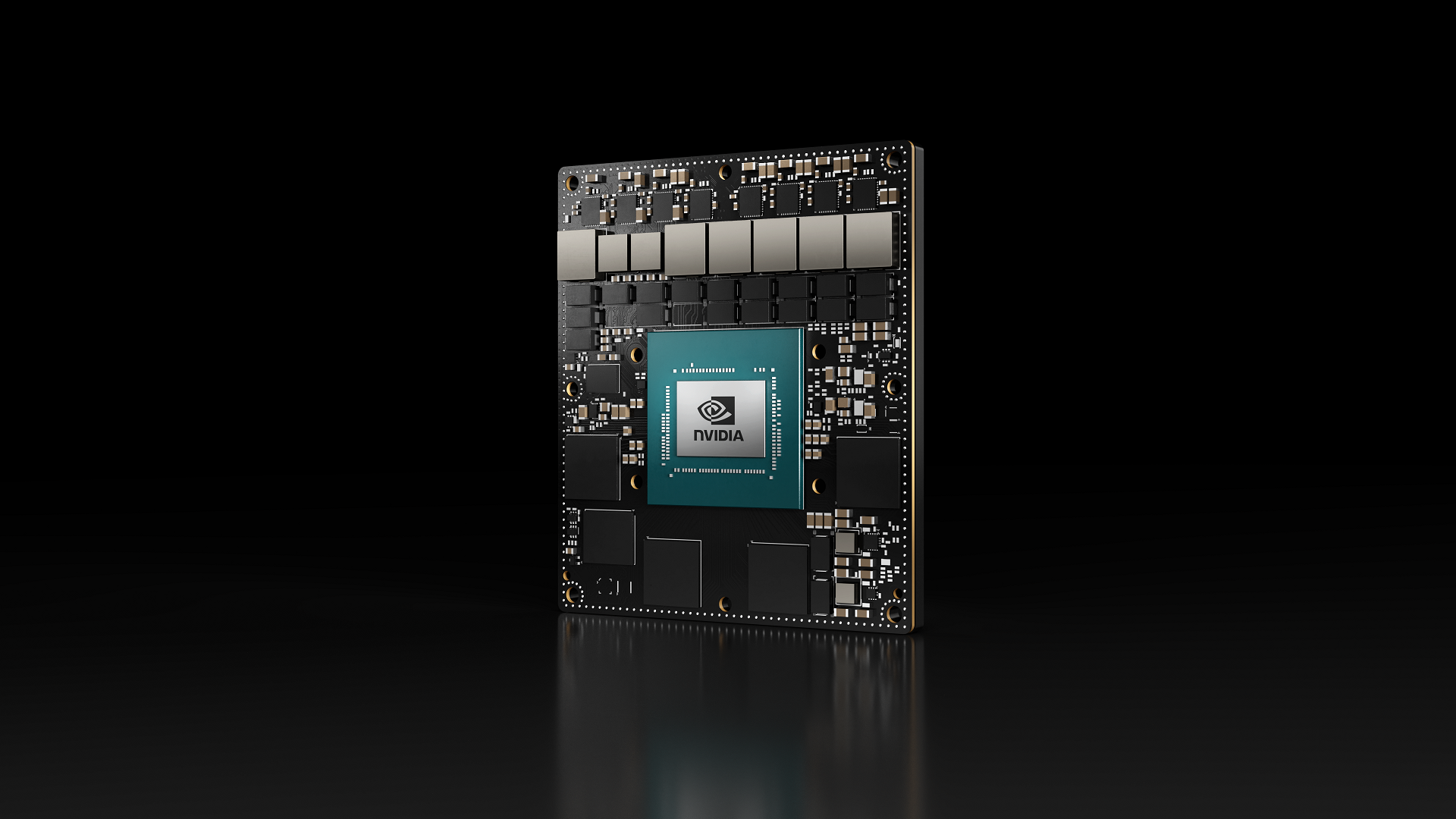

NVIDIA Jetson Orin Nano 超級開發者套件 的推出為小型邊緣設備開啟了 生成式 AI 的新時代。新的 超級模式 在開發者套件上實現了前所未有的生成式 AI 性能提升,最高可達 1.7 倍,使其成為最經濟實惠的生成式 AI 超級計算機。

JetPack 6.2 現已支持 Jetson Orin Nano 和 Jetson Orin NX 生產模組的超級模式,可將生成式 AI 模型的性能提升高達 2 倍。現在,您可以為新的和現有的機器人和邊緣 AI 應用釋放更多價值并降低總體擁有成本。

本文討論了 Super Mode 的詳細信息,包括新的功率模式、Jetson Orin Nano 和 Orin NX 模組上熱門生成式 AI 模型的基準測試、文檔更新,以及對支持 Super Mode 的 NPN 合作伙伴的見解。

Jetson Orin Nano 和 Jetson Orin NX 系列上的新參考功率模式

JetPack 6.2 通過在 GPU、DLA 內存和 CPU 時鐘上解鎖更高的頻率,提升 Jetson Orin Nano 和 Jetson Orin NX 系列的功耗。

| 模塊 | 現有參考電源模式 ( 適用于現有刷寫配置 ) | NEW POWER MODES (僅適用于新的刷寫配置) |

| NVIDIA Jetson Orin Nano 4GB | 7 瓦、10 瓦 | 10 瓦、25 瓦、 最大值 超級 (SUPER) |

| NVIDIA Jetson Orin Nano 8GB | 7 瓦、15 瓦 | 15 瓦、25 瓦、 最大值 超級 (SUPER) |

| NVIDIA Jetson Orin NX 8GB | 10 瓦、15 瓦、20 瓦、MAXN | 10 瓦、15 瓦、20 瓦、40 瓦, 最大值 超級 (SUPER) |

| NVIDIA Jetson Orin NX 16GB | 10 瓦、15 瓦、25 瓦、MAXN | 10 瓦、15 瓦、25 瓦、40 瓦, 最大值 超級 (SUPER) |

Jetson Orin Nano 模組現提供 25W 模式和全新的無上限 MAXN SUPER 模式。同樣,Jetson Orin NX 模組現在可以使用更高的 40W 參考功率模式以及不設上限的 MAXN SUPER 模式。

MAXN SUPER 是不設上限的功率模式,可為 CPU、GPU、DLA、PVA 和 SOC 引擎提供最高數量的核心數和時鐘頻率。在此模式下,如果模組總功率超過熱設計功率(TDP)預算,系統會將模組調低頻率,從而在保持熱預算的同時降低性能。

我們強烈建議您構建自己的自定義功率模式,以便根據您的應用和需求,在功耗或熱穩定性與性能之間找到適當的平衡。

表 2 比較了 Jetson Orin Nano 4GB 和 8GB 以及 Jetson Orin NX 8GB 和 16GB 在原始模式和 Super Mode 下的詳細規格。

| ? | Orin Nano 4GB* | Orin Nano 4GB (SUPER)* |

Orin Nano 8GB* | Orin Nano 8GB* (SUPER)* |

ORIN NX 8GB* | ORIN NX 8GB* (SUPER)* |

Orin NX 16GB* | Orin NX 16GB* (SUPER)* |

| AI 性能峰值 * INT8 * | 20 TOPS (Sparse) 10 TOPS (Dense) | 34 TOPS (Sparse) 17 TOPS (Dense) | 40 TOPS (Sparse) 20 TOPS (Dense) | 67 TOPS (Sparse) 33 TOPS (Dense) | 70 TOPS (Sparse) 35 TOPS (Dense) | 117 TOPS (Sparse) 58 TOPS (Dense) | 100 TOPS (Sparse) 50 TOPS (Dense) | 157 TOPS (Sparse) 78 TOPS (Dense) |

| NVIDIA Ampere GPU | 512 個 CUDA Cores 16 個 Tensor Cores 625 MHz 20/10 INT8 TOPs (S/D) 5 FP16 TFLOPs | 512 個 CUDA Cores 16 個 Tensor Cores 1020 MHz 34/17 INT8 TOPS (S/D) 8.5 FP16 TFLOPS | 1024 個 CUDA Cores 32 個 Tensor Cores 625 MHz 40/20 INT8 TOPs (S/D) 10 FP16 TFLOPs | 1024 個 CUDA Cores 32 個 Tensor Cores 1020 MHz 67/33 INT8 TOPs (S/D) 17 FP16 TFLOPs | 1024 個 CUDA Cores 32 個 Tensor Cores 765 MHz 50/25 INT8 TOPs (S/D) 13 FP16 TFLOPs | 1024 個 CUDA Cores 32 個 Tensor Cores 1173 MHz 77/38 INT8 TOPs (S/D) 19 FP16 TFLOPs | 1024 個 CUDA Cores 32 個 Tensor Cores 918 MHz 60/30 INT8 TOPs (S/D) 15 FP16 TFLOPs | 1024 個 CUDA Cores 32 個 Tensor Cores 1173 MHz 77/38 INT8 TOPs (S/D) 19 FP16 TFLOPs |

| CPU * | 6 塊 A78+ 1.5 GHz* |

6 塊 A78+ 1.7 GHz * |

6 塊 A78+ 1.5 GHz* |

6 塊 A78+ 1.7 GHz * |

6 塊 A78+ 2.0 GHz* |

6 塊 A78+ 2.0 GHz* |

8 塊 A78+2 .0 GHz 以上 |

8 塊 A78+ 2.0 GHz* |

| DLA (S/D)* | NA* | NA* | NA* | NA* | 20/10 INT8 TOPS* | 40/20 INT8 TOPS * | 40/20 INT8 TOPS* | 80/40 INT8 TOPS * |

| DRAM 重制版 * | 34 GB/秒* | 51 GB/秒 * | 68 GB/秒* | 102 GB/秒 * | 102 GB/秒* | 102 GB/秒* | 102 GB/秒* | 102 GB/秒* |

| 模組功耗 * | 7 瓦 10 瓦以上 |

7 瓦 10 瓦 25 瓦 * |

7 瓦 15 瓦以上 |

7 瓦 15 瓦 25 瓦 * |

10 瓦 15 瓦 20 瓦以上 |

10 瓦 15 瓦 25 瓦 40 瓦 * |

10 瓦 15 瓦 25 瓦以上 |

10 瓦 15 瓦 25 瓦 40 瓦 * |

在使用新的功率模式時,請確保您產品的現有或新的散熱設計能夠適應新的功率模式規格。有關更多信息,請參閱更新的 Thermal Design Guide 。

更新了功耗估算器工具?

功耗估算器工具是 NVIDIA 提供的一款功能強大的工具,可通過修改 GPU、CPU、DLA 上的核心、最大頻率和負載級別等系統參數來創建自定義功耗配置文件和 nvpmodel 配置文件。該工具通過各種設置提供估計功耗,并可用于創建最佳參數設置,以在性能和功耗之間實現所需的平衡。

我們更新了 Power Estimator Tool 的超級模式。我們強烈建議您使用 Power Estimator Tool 并在實踐中進行驗證,然后再通過高性能應用程序進行部署。

提升熱門生成式 AI 模型的性能

隨著 JetPack 6.2 超級模式的引入,Jetson Orin Nano 和 Jetson Orin NX 模組可將推理性能提升高達 2 倍。我們對熱門的大語言模型 (LLMs)、視覺語言模型 (VLMs) 和視覺轉換器 (ViTs) 進行了基準測試。

大語言模型?

以下圖表和表格顯示了 Llama3.1 8B、Qwen2.5 7B 和 Gemma2 2B 等熱門 LLM 的超模性能基準測試。

DNR 意味著模塊上的內存不足以運行特定模型。模型性能將受到節流行為的影響。

在下表中,LLM 生成性能(每秒令牌數)是使用 MLC API 通過 INT4 量化測量的。

表 3 顯示了搭載 JetPack 6.2 的 Jetson Orin Nano 4GB 上的 LLM 性能提升。

| 模型 | Orin Nano 8GB (原始版本) | Orin Nano 8GB (超級模式) | 性能增益 (倍) |

| Gemma 2 2B | 11.40 | 18.60 歐元 | 1.64 |

| SmolLM2 1.7 B | 23.00 | 35.80 | 1.56 |

表 4 顯示了搭載 JetPack 6.2 的 Jetson Orin Nano 8GB 上的 LLM 性能提升。

| 模型 | Orin Nano 8GB (原始版本) | Orin Nano 8GB (超級模式) | 性能增益 (倍) |

| Llama 3.1 8B | 14.00 | 19.10 | 1.37 |

| Llama 3.2 3B | 27.70 | 43.10 | 1.55 |

| Qwen 2.5 7B | 14.20 | 21.80 | 1.53 |

| Gemma 2 2B | 21.5 | 35.0 | 1.63 |

| Gemma 2 9B | 7.20 | 9.20 | 1.28 |

| Phi-3.5 38 B | 24.70 | 38.10 | 1.54 |

| SmolLM2 1.7 B | 41.00 | 64.50 | 1.57 |

表 5 顯示了搭載 JetPack 6.2 的 Jetson Orin NX 8GB 上的 LLM 性能提升。

| 模型 | Orin NX 8GB (原始版本) | Orin NX 8GB (超級模式) | 性能增益 (倍) |

| Llama 3.1 8B | 15.90 | 23.10 | 1.46 |

| Llama 3.2 3B | 34.50 | 46.50 | 1.35 |

| Qwen 2.5 7B | 17.10 | 23.80 | 1.39 |

| Gemma 2 2B | 26.60 | 39.30 | 1.48 |

| Gemma 2 9B | 8.80 | 13.38 | 1.52 |

| Phi-3.5 38 B | 30.80 | 評分:41.30 | 1.34 |

| SmolLM2 1.7 B | 51.50 | 69.80 | 1.35 |

表 6 顯示了搭載 JetPack 6.2 的 Jetson Orin NX 16GB 上的 LLM 性能提升。

| 模型 | Orin NX 16GB (原始版本) | Orin NX 16GB (超級模式) | 性能增益 (倍) |

| Llama 3.1 8B | 20.50 | 22.80 | 1.11 |

| Llama 3.2 3B | 40.40 | 45.80 | 1.13 |

| Qwen 2.5 7B | 20.80 | 23.50 | 1.13 |

| Gemma 2 2B | 31.60 歐元 | 39.00 | 1.23 |

| Gemma 2 9B | 10.56 | 13.26 | 1.26 |

| Phi-3.5 38 B | 35.90 | 40.90 | 1.14 |

| SmolLM2 1.7 B | 59.50 | 68.80 | 1.16 |

視覺語言模型?

以下圖表和表格顯示了熱門 VLM (例如 VILA1.5 8B、LLAVA1.6 7B 和 Qwen2 VL 2B) 的超模性能基準測試。

DNR 意味著模塊上的內存不足以運行特定模型。模型性能將受到節流行為的影響。

表 7 顯示了搭載 JetPack 6.2 的 Jetson Orin Nano 4GB 的 VLM 性能提升情況。

| 模型 | Orin Nano 4GB (原始) | Orin Nano 4GB (超級模式) | 性能增益 (倍) |

| PaliGemma2 3B | 7.2 | 11.2 | 1.56 |

表 8 顯示了搭載 JetPack 6.2 的 Jetson Orin Nano 8GB 上的 VLM 性能提升。

| 模型 | Orin NX 16GB (原始版本) | Orin NX 16GB (超級模式) | 性能增益 (倍) |

| VILA 1.5 3B | 0.7 | 1.1 | 1.51 |

| VILA 1.5 8B | 0.6 | 0.8 | 1.45 |

| LLAVA 1.6 7B | 0.4 | 0.6 | 1.38 |

| Qwen2 VL 2B | 2.8 | 4.4 | 1.57 |

| InterVL2.5 4B | 2.5 | 5.1 | 2.04 |

| PaliGemma2 3B | 13.7 | 21.6% | 1.58 |

| SmolVLM 2B | 8.1 | 12.9 | 1.59 |

表 9 顯示搭載 JetPack 6.2 的 Jetson Orin NX 8GB 上的 VLM 性能提升。

| 模型 | Orin NX 16GB (原始版本) | Orin NX 16GB (超級模式) | 性能增益 (倍) |

| VILA 1.5 3B | 0.8 | 1 | 1.25 |

| VILA 1.5 8B | 0.7 | 1.04 | 1.50 |

| LLAVA 1.6 7B | 0.5 | 1.2 | 2.54 |

| Qwen2 VL 2B | 3.4 | 4.8 | 1.41 |

| InterVL2.5 4B | 3 | 4.1 | 1.37 |

| PaliGemma2 3B | 17.1 | 23.9 | 1.40 |

| SmolVLM 2B | 9.7 | 14.4 | 1.48 |

表 10 顯示配備 JetPack 6.2 的 Jetson Orin NX 16GB 上的 VLM 性能提升。

| 模型 | Orin NX 16GB (原始版本) | Orin NX 16GB (超級模式) | 性能增益 (倍) |

| VILA 1.5 3B | 1 | 1.3 | 1.23 |

| VILA 1.5 8B | 0.8 | 1 | 1.25 |

| LLAVA 1.6 7B | 0.6 | 0.7 | 1.07 |

| Qwen2 VL 2B | 4 | 4.8 | 1.20 |

| InterVL2.5 4B | 2.8 | 4.4 | 1.57 |

| PaliGemma2 3B | 20 | 23.8 | 1.19 |

| SmolVLM 2B | 11.7 | 14.3 | 1.22 |

所有 VILA 和 LLAVA 模型均使用 MLC 以 INT4 精度運行,而其余模型則使用 Hugging Face Transformers 以 FP4 精度運行。

視覺 Transformer 模型

以下圖表和表格顯示了 CLIP、DINO 和 SAM2 等熱門 ViTs 的 Super Mode 性能基準測試。

DNR 意味著模塊上的內存不足以運行特定模型。模型性能將受到節流行為的影響。

表 11 顯示搭載 JetPack 6.2 的 Jetson Orin Nano 4GB 的 ViT 性能提升情況。

| 模型 | Orin Nano 4GB (原始) | Orin Nano 4GB (超級模式) | 性能增益 (倍) |

| clip-vit-base-patch32 | 126.8 | 189.5 | 1.49 |

| clip-vit-base-patch16 | 63.2 | 112.4 | 1.78 |

| 基于 DINOv2 的補丁 14 | 49.3% | 79.3 | 1.61 |

| 基于 SAM2 | 2.5 | 3.8 | 1.54 |

| Vit-base-patch16-224 | 62.4% | 103.3 | 1.66 |

表 12 顯示搭載 JetPack 6.2 的 Jetson Orin Nano 8GB 的 ViT 性能提升情況。

| 模型 | Orin Nano 8GB (原始版本) | Orin Nano 8GB (超級模式) | 性能增益 (倍) |

| clip-vit-base-patch32 | 196 | 214 | 1.60 |

| clip-vit-base-patch16 | 95% | 151 | 1.69 |

| 基于 DINOv2 的補丁 14 | 75 | 126 | 1.68 |

| 基于 SAM2 | 4.4 | 6.3 | 1.43 |

| 支持恐龍 | 4.1 | 6.2 | 1.52 |

| Vit-base-patch16-224 | 98 | 158 | 1.61 |

| Vit-base-patch32-224 | 172 | 273 | 1.60 |

表 13 顯示配備 JetPack 6.2 的 Jetson Orin NX 8GB 上的 ViT 性能提升。

| 模型 | Orin NX 8GB (原始版本) | Orin NX 8GB (超級模式) | 性能增益 (倍) |

| clip-vit-base-patch32 | 224.0 | 361.1 | 1.54 |

| clip-vit-base-patch16 | 101.7 | 204.3 | 2.01 |

| 基于 DINOv2 的補丁 14 | 81.4% | 160.3 | 1.97 |

| 基于 SAM2 | 3.9 | 7.4 | 1.92 |

| 支持恐龍 | 4.2 | 7.4 | 1.75 |

| Vit-base-patch16-224 | 98.6% | 192.5 | 1.95 |

| Vit-base-patch32-224 | 192.1 | 313.5 | 1.62 |

表 14 顯示配備 JetPack 6.2 的 Jetson Orin NX 16GB 上的 ViT 性能提升。

| 模型 | Orin NX 16GB (原始版本) | Orin NX 16GB (超級模式) | 性能增益 (倍) |

| clip-vit-base-patch32 | 322.2 | 356.7 | 1.10 |

| clip-vit-base-patch16 | 163.5 | 192.6 | 1.18 |

| 基于 DINOv2 的補丁 14 | 127.5 | 159.8 | 1.25 |

| 基于 SAM2 | 6.2 | 7.3 | 1.18 |

| 支持恐龍 | 6.2 | 7.2 | 1.16 |

| Vit-base-patch16-224 | 158.6 | 190.2 | 1.20 |

| Vit-base-patch32-224 | 271.2 | 209.5 | 1.10 |

所有 ViT 模型均使用 NVIDIA TensorRT 以 FP16 精度運行,且測量以 FPS 進行。

使用 NVIDIA Jetson Orin Nano 和 NVIDIA Jetson Orin NX 的 JetPack 6.2 入門

NVIDIA Jetson 生態系統提供了多種使用 JetPack 鏡像刷寫開發者套件和生產模組的方式。

要在 Jetson Orin Nano 開發者套件或模組上安裝 JetPack 6.2,請使用以下方法之一:

- JetPack SDK 頁面中的 SD-Card 鏡像 。

- SDK Manager ,用于 根據下載和安裝說明 進行刷寫。

- 根據 刷寫支持 ,刷寫 bootloader、kernel 和 root file system 的腳本。

新的刷寫配置?

新的電源模式僅適用于新的刷寫配置。默認刷寫配置未發生變化。要啟用新的電源模式,您必須在刷寫時使用新的刷寫配置。

以下是用于刷寫的新刷寫配置:

jetson-orin-nano-devkit-super.conf |

刷寫或更新到 JetPack 6.2 后,運行以下命令以啟動新提供的超級模式。

Jetson Orin Nano 模組上的 MAXN SUPER 模式:

sudo nvpmodel -m 2 |

Jetson Orin NX 模組上的 MAXN SUPER 模式:

sudo nvpmodel -m 0 |

您還可以從頁面右上角的電源模式菜單中選擇 MAXN SUPER 和其他電源模式。

Jetson AI 實驗室?

Jetson AI 實驗室是 NVIDIA 探索和試驗針對邊緣設備優化的生成式 AI 技術的中心。它為開發者提供支持,并為協作社區提供了近 50 個教程、預構建容器和資源,用于使用優化的推理基礎架構部署設備上的 LLM、SLM、VLM、diffusion policies 和 speech models。

通過簡化對先進 AI 工具的訪問,該實驗室使各級別的開發者能夠在本地創新和部署生成式 AI,從而推進開源邊緣 AI 和機器人學習。

通過這些易于學習的教程,為由 JetPack 6.2 提供支持的開發者套件輕松深入了解生成式 AI:

- 使用 Open Web UI 的 Ollama :入門級 LLM 應用示例

- NanoOWL: 采用先進 ViT 模型的交互式演示

- LeRobot :Hugging Face LeRobot 的物理 AI 示例

更新文檔:Datasheets 和設計指南

借助更新的性能提升,以下資源已更新,可從 Jetson Download Center 下載:

- Jetson Orin NX 模組數據表

- Jetson Orin Nano 模組數據表

- Jetson Orin NX 系列和 Jetson Orin Nano 系列設計指南

- 散熱設計指南

Jetson 生態系統合作伙伴為 Super Mode 做好準備

為支持客戶部署,Jetson 生態系統合作伙伴已增強其解決方案,以支持這種提升的性能。

| 類別 | Jetson 生態系統合作伙伴 |

| ISV 解決方案 | DeepEdge Edge Impulse RidgeRun Ultralytics |

| 硬件系統合作伙伴 | AAEON Advantech Aetina AIMobile ASUSTek Axiomtek Connect Tech Seeed Studio Syslogic Vecow Yuan High-Tech |

| 散熱解決方案 |

NVIDIA Jetson Orin 生命周期和路線圖

鑒于客戶對 Jetson Orin 的需求日益增長,NVIDIA 最近宣布 將 Jetson Orin 的產品生命周期延長至 2032 年。憑借這種性能提升,Jetson Orin Nano 和 Orin NX 系列成為當前和未來模型的理想平臺。

即將推出的 JetPack 5.1.5 還將為 Jetson Orin NX 和 Jetson Orin Nano 模組啟用超級模式。使用 JetPack 5 進行開發的開發者和客戶將從性能提升中受益。

使用 JetPack 6.2 提升應用性能

JetPack 6.2 是一個開創性版本。它可在現有 Jetson 模組上實現驚人的 2 倍推理性能提升,且無需增加任何成本。對于希望為其應用程序提供強效助力的 Jetson 開發者和客戶而言,此次升級必不可少。立即升級到 JetPack 6.2,充分發揮 Jetson 平臺的全部潛力。

?