隨著 生成式 AI 重塑各行各業,對可立即部署的高性能推理的需求也在不斷增長。 NVIDIA NIM 為 AI 模型推理提供生產就緒型微服務容器,不斷提高企業級生成式 AI 性能。即將推出的 NIM 版本 1.4 定于 12 月初發布,開箱即用的請求性能可提升高達 2.4 倍,并提供相同的單命令部署體驗。

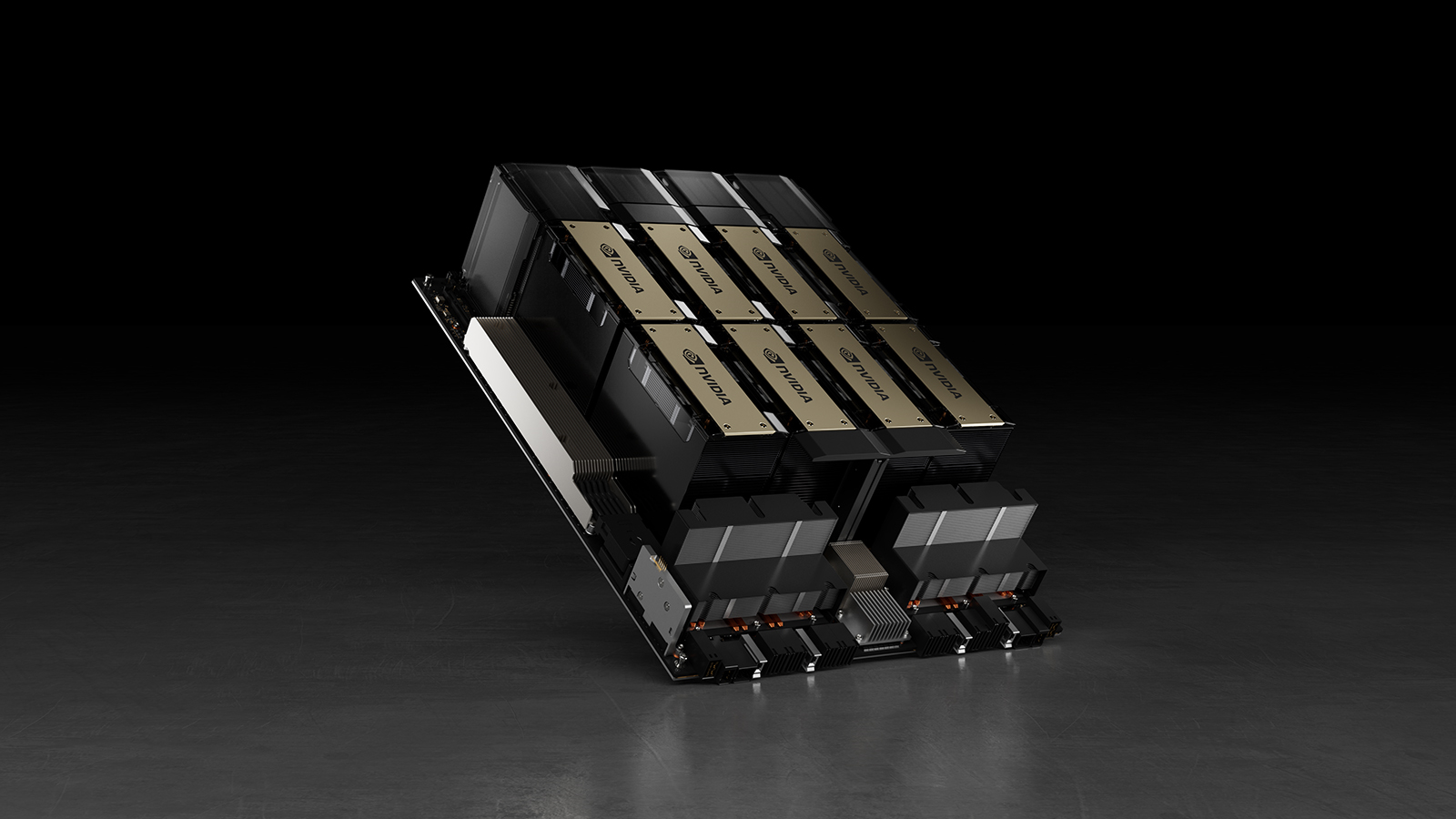

NIM 的核心是多個 LLM 推理引擎,包括 NVIDIA TensorRT-LLM ,可實現光速推理性能。在每個版本中,NIM 都整合了來自這些引擎的內核優化、內存管理和調度方面的最新進展,以提高性能。

在 NIM 1.4 中,內核效率、運行時啟發式算法和內存分配有了顯著改進,推理速度提高了 2.4 倍。這些進步對于依賴快速響應和高吞吐量的生成式 AI 應用的企業至關重要。

NIM 還受益于全棧加速計算的持續更新,可提升計算堆棧各個級別的性能和效率。這包括對最新的 NVIDIA TensorRT 和 NVIDIA CUDA 版本的支持,進一步提高了推理性能。NIM 用戶無需手動更新軟件,即可從這些持續改進中受益。

NIM 整合了全套預配置軟件,提供高性能 AI 推理,并且配置簡單,使開發者能夠快速開始使用高性能推理。

持續創新循環意味著 TensorRT-LLM、CUDA 和其他核心加速計算技術的每項改進都會立即使 NIM 用戶受益。更新通過 NIM 微服務容器的更新無縫集成和交付,消除了手動配置的需求,并減少了通常與維護高性能推理解決方案相關的工程開銷。

立即開始使用?

NVIDIA NIM 是實現高性能生成式 AI 的捷徑,無需傳統模型部署和管理的復雜性。憑借企業級可靠性和支持以及持續的性能增強,NIM 使企業能夠使用高性能 AI 推理。 了解詳情 并 立即開始使用 。

?