AI 驅動的應用的爆炸式發展對開發者提出了前所未有的要求,他們必須在提供先進的性能與管理運營復雜性和成本以及 AI 基礎設施之間取得平衡。

NVIDIA 正在為開發者提供涵蓋芯片、系統和軟件的全棧創新,重新定義 AI 推理 的可能性,使其比以往更快、更高效、更具可擴展性。

輕松部署高吞吐量、低延遲推理

六年前,NVIDIA 著手打造 AI 推理服務器,專為構建高吞吐量、延遲關鍵型生產應用的開發者而設計。當時,許多開發者都在努力使用定制的、特定于框架的服務器,這些服務器增加了復雜性,增加了運營成本,并且難以滿足嚴格的服務水平協議(service-level agreements)關于延遲和吞吐量的要求。

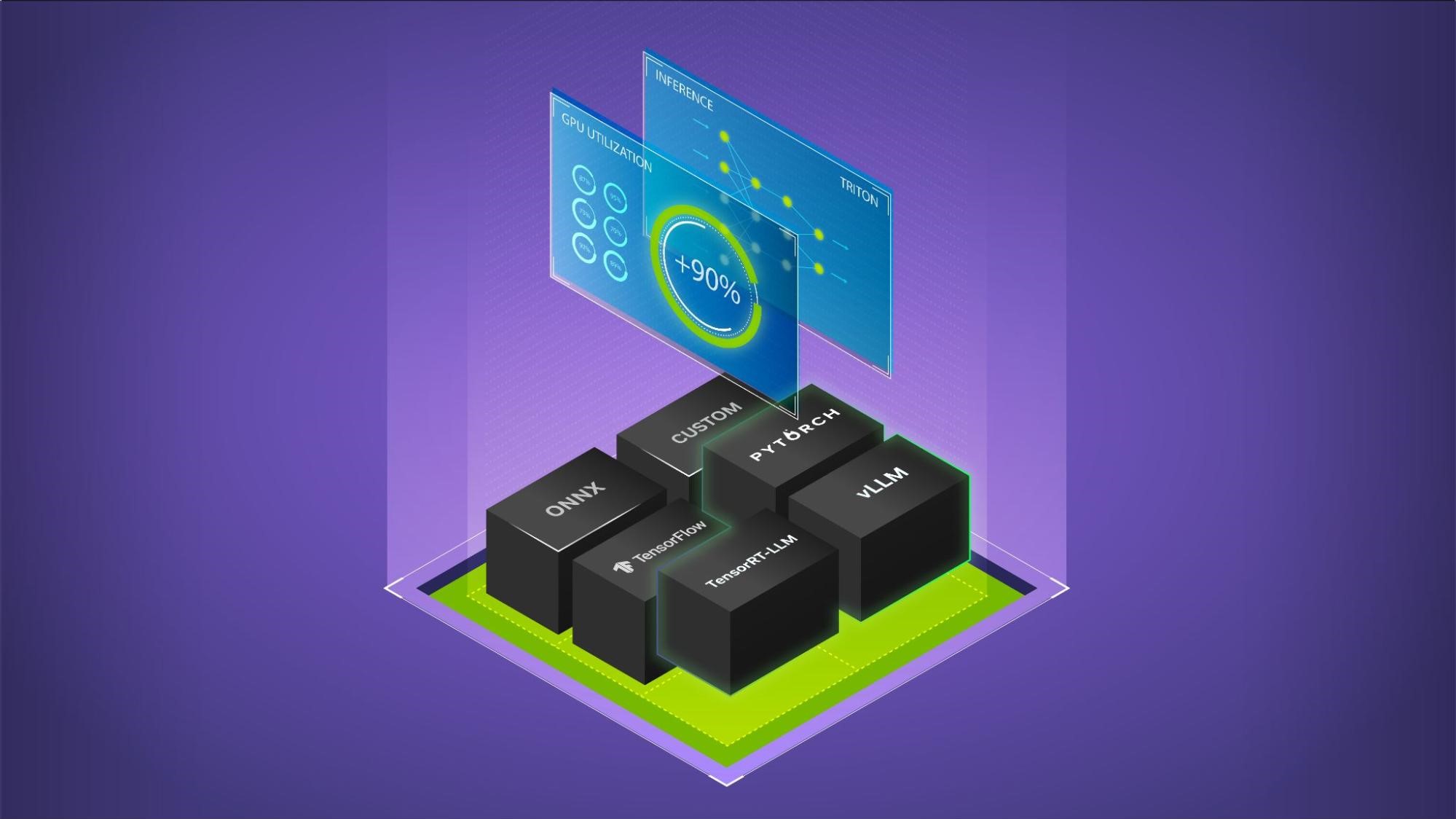

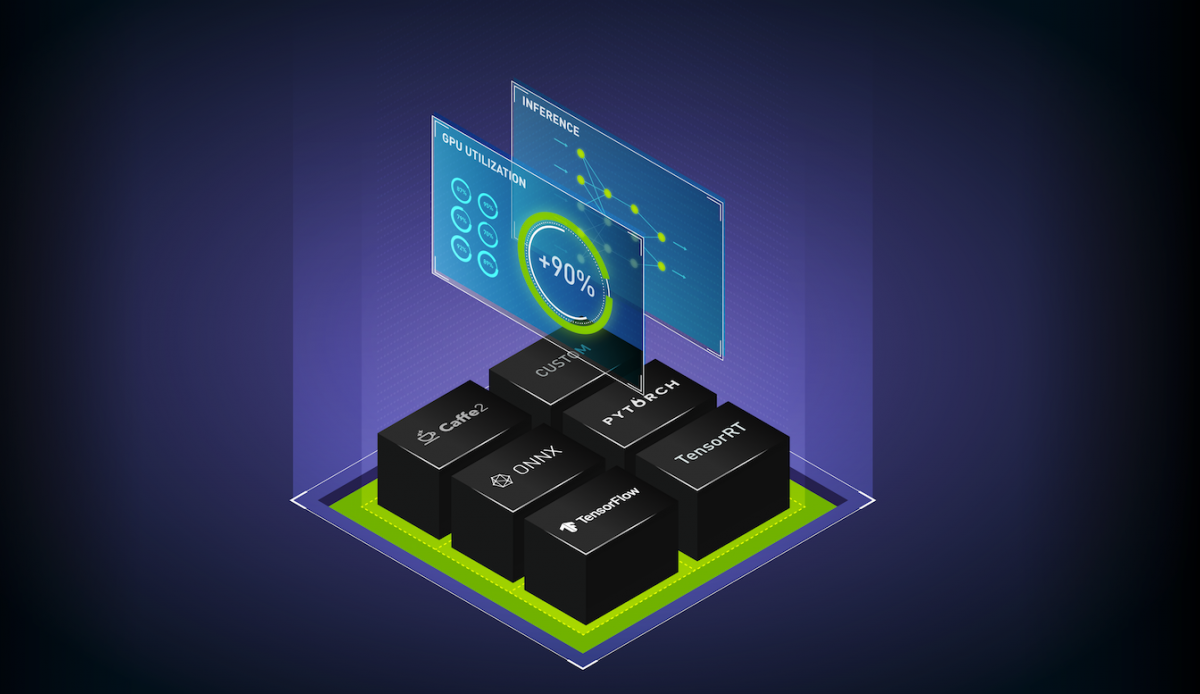

為解決這一問題,NVIDIA 開發了 NVIDIA Triton Inference Server ,這是一個開源平臺,能夠為來自任何 AI 框架的模型提供服務。通過整合特定于框架的推理服務器,Triton 簡化了 AI 推理部署,并提高了 AI 預測能力。這種方法使 Triton 成為廣泛采用的 NVIDIA 開源項目之一,現已被數百家領先的組織用于高效部署生產級 AI 模型。

除 Triton 外,NVIDIA 還提供廣泛的 AI 推理解決方案生態系統。對于尋求功能強大的可定制工具的開發者, NVIDIA TensorRT 提供了一個高性能深度學習推理庫,其 API 可實現細粒度優化。 NVIDIA NIM 微服務提供了一個靈活的框架,用于在云端、數據中心或工作站中部署 AI 模型。

針對 AI 推理工作負載進行優化

推理是當今的全棧問題,需要高性能基礎架構和高效軟件來有效利用該基礎架構。此外,隨著模型大小不斷增長和延遲限制日益嚴格,推理工作負載的挑戰性也越來越高,同時利用這些 AI 服務的用戶數量也在不斷增加。隨著推理時間擴展(一種擴展模型智能的新范式)的引入,推理過程中應用了更多的計算來增強模型性能。

這些趨勢意味著,即使在相同的底層硬件平臺上,繼續提高交付的推理性能也很重要。通過將模型并行、混合精度訓練、剪枝、量化和數據預處理優化等成熟方法與推理技術的前沿進步相結合,開發者可以在速度、可擴展性和成本效益方面實現顯著提升。

TensorRT-LLM 庫包含許多先進功能,可加速 大語言模型(LLMs) 的推理性能,如下所述。

預填充和 KV 緩存優化

- 鍵值 (KV) 緩存提早復用 :通過在不同用戶中重復使用系統提示,KV 緩存提早復用功能可將首個令牌 (TTFT) 的時間縮短高達 5 倍。靈活的 KV 塊大小和高效的驅逐協議可確保無縫管理內存,即使在多用戶環境中也能縮短響應時間。

- 分塊預填充 :為實現更智能的部署,分塊預填充可將預填充階段劃分為較小的任務,從而提高 GPU 利用率并降低延遲。這項創新可簡化部署,并確保一致的性能,即使在用戶需求波動的情況下也是如此。

- 強效助力多圈交互:NVIDIA GH200 超級芯片架構可實現高效的 KV 緩存卸載,在與 Llama 模型進行多圈交互時,將 TTFT 性能提升高達 2 倍,同時保持高吞吐量。

解碼優化?

- 長序列的 多塊注意力 :TensorRT-LLM 多塊注意力通過在流多處理器 (SM) 中分配任務,更大限度地提高 GPU 利用率,從而解決長輸入序列的挑戰。此技術可將系統吞吐量提高 3 倍以上,從而在不增加硬件成本的情況下支持更大的上下文長度。

- 用于加速吞吐量的推理吞吐量:通過利用較小的草稿模型和較大的目標模型,推理吞吐量可將推理吞吐量提升高達 3.6 倍。這種方法可確保高速、高精度地生成模型輸出,簡化大規模 AI 應用的工作流。

- 使用 Medusa 進行推理解碼:Medusa 推理解碼算法可作為 TensorRT-LLM 優化的一部分提供。通過同時預測多個后續令牌,Medusa 在 NVIDIA HGX H200 平臺上將 Llama 3.1 模型的吞吐量提高了 1.9 倍。這項創新可加快客戶支持和內容創建等依賴 LLM 的應用的響應速度。

多 GPU 推理?

- MultiShot 通信協議 :傳統的 Ring AllReduce 操作可能會成為多 GPU 場景中的瓶頸。TensorRT-LLM MultiShot 由 NVSwitch 提供支持,無論 GPU 數量如何,都可以將通信步驟減少到兩個。這項創新將 AllReduce 速度提升高達 3 倍,使低延遲推理具有可擴展性并十分高效。

- 實現高并發效率的工作流并行:并行技術要求 GPU 能夠快速高效地傳輸數據,因此需要強大的 GPU 到 GPU 互連結構來實現出色性能。 NVIDIA H200 Tensor Core GPU 上的工作流并行將 Llama 3.1 405B 的吞吐量提高了 1.5 倍,并在 MLPerf Inference 基準測試中證明了其通用性,將 Llama 2 70B 的速度提高了 1.2 倍。MLPerf Inference 是一套行業標準推理性能基準測試,由 MLCommons 聯盟開發。

- 大型 NVLink 域 :NVIDIA GH200 NVL32 系統由通過 NVLink Switch 系統連接的 32 個 NVIDIA GH200 Grace Hopper 超級芯片提供支持,并進行了 TensorRT-LLM 改進,可為 Llama 模型提供高達 3 倍的 TTFT 速度。憑借高達 127 Petaflops 的 AI 計算能力,此新一代架構為 AI 應用實現出色的實時響應速度奠定了基礎。

量化和低精度計算

- 用于提高精度和性能的 NVIDIA TensorRT 模型優化器 :NVIDIA TensorRT 模型優化器中的 NVIDIA 定制 FP8 量化方法可在不犧牲準確性的情況下將吞吐量提高 1.44 倍。這些優化可降低高要求工作負載的延遲和硬件需求,從而實現更具成本效益的部署。

- 端到端全棧優化:NVIDIA TensorRT 庫和 FP8 Tensor Core 創新技術可確保從數據中心 GPU 到邊緣系統等各種設備實現高性能。NVIDIA 優化了 Llama 3.2?模型集合,以實現出色性能,展示了全棧軟件如何在不同的 AI 部署環境中靈活釋放效率。

借助這些功能以及 Triton 和 TensorRT-LLM 中的許多其他功能,開發者現在可以部署更快速、更高效的 LLM,并且能夠處理更廣泛的任務和用戶需求。這為企業增強客戶服務、實現復雜流程自動化以及從數據中獲得更深入見解帶來了新機遇。

評估推理性能

實現出色的推理性能需要完整的技術堆棧(芯片、系統和軟件),所有這些都有助于提高吞吐量、降低每個令牌的能耗并更大限度地降低成本。

MLPerf Inference 是衡量推理性能的一個關鍵指標。該基準測試用于測量標準化條件下的推理吞吐量,并對結果進行廣泛的同行評審。基準測試會定期更新,以反映 AI 領域的新進展,確保企業組織可以依靠這些結果來評估平臺性能。

在最新一輪 MLPerf Inference 中, NVIDIA Blackwell 首次亮相 ,在 Llama 2 70B 基準測試中,其性能比 NVIDIA H100 Tensor Core GPU 高 4 倍。這一成就得益于 Blackwell GPU 核心的眾多架構創新,包括采用 FP4 Tensor Cores 的第二代 Transformer Engine 和可為每個 GPU 提供 8 TB/s 的 HBM3e GPU 內存帶寬。

此外,對 NVIDIA 軟件堆棧的許多方面 (包括 NVIDIA TensorRT-LLM) 進行了重新設計,以利用 Blackwell 中的新功能 (例如對 FP4 精度的支持),同時繼續滿足基準測試的嚴格準確性目標。

服務器制造商和云服務提供商現已推出的 NVIDIA H200 Tensor Core GPU 在數據中心類別的每項基準測試中都取得了出色的成績。其中包括新增的 Mixtral 8x7B 多專家模型 (MoE) LLM,以及 Llama 2 70B LLM 和 Stable Diffusion XL 文本轉圖像測試。得益于軟件的持續改進,Hopper 架構可提供高達 27% 的推理性能。

與 MLPerf Inference v4.1 中 Llama 2 70B 基準測試中的 NVIDIA 裸機提交相比 ,在配備 8 個 H200 GPU 的系統上運行的 NVIDIA Triton Inference Server 實現了幾乎相同的性能。這表明企業不再需要在功能豐富的生產級 AI 推理服務器和峰值吞吐量性能之間做出選擇,而 NVIDIA Triton 可以同時實現這兩種性能。

AI 推理的未來:新興趨勢和技術

在一系列突破性進展和新興技術的推動下,AI 推理的格局正在迅速發展。隨著數據中心規模的計算能力增加,模型將繼續變得更加智能。引入稀疏的多專家模型架構 (例如 GPT-MoE 1.8T) 也將有助于提高模型智能,同時提高計算效率。這些更大型的模型,無論是密集模型還是稀疏模型,都需要 GPU 單獨變得更加強大。NVIDIA Blackwell 架構將為新一代生成式 AI 推理提供動力支持。

每個 Blackwell GPU 均配備第二代 Transformer Engine 和第五代 Tensor Cores,利用 FP4。低精度數據格式有助于提高計算吞吐量并降低內存需求。為了確保它們能夠在保持高精度的同時提供顯著的性能優勢,我們需要大量的軟件技術。

與此同時,為了以快速、實時的速率為要求嚴苛的模型提供服務,許多功能非常強大的 GPU 需要協同工作以生成響應。

NVIDIA GB200 NVL72 機架級解決方案創建了一個 72-GPU NVLink 域,可充當單個大型 GPU。對于 GPT-MoE 1.8T 實時推理,與上一代 Hopper GPU 相比,其吞吐量提高了 30 倍。

此外,新的擴展定律(測試時計算) 的出現為提高更復雜任務的響應質量和準確性提供了另一種方法。這種新范式首先在 OpenAI o1 模型中引入,使模型能夠在輸出最終結果之前通過生成許多中間令牌來“推理”。推理模型在復雜數學和生成計算機代碼等領域尤為有用。這種新范式將起新一輪突破浪潮,需要在推理期間實現更高的計算性能。

通往人工通用智能的道路將依賴于數據中心計算性能的持續突破。預訓練、后訓練和測試時擴展都依賴于運行專家精心編寫的軟件的最先進的基礎架構。NVIDIA 平臺發展迅速,一年內創新節奏輕快,使生態系統能夠繼續推動人工智能的前沿發展。

開始使用?

查看如何開始使用 AI 推理 ,了解更多關于 NVIDIA AI 推理平臺 的信息,并隨時了解 最新的 AI 推理性能更新 。

觀看演示,了解如何快速部署 NVIDIA NIM 微服務,或閱讀《使用 NVIDIA NIM 部署生成式 AI 的簡單指南》。TensorRT、TensorRT-LLM 和 TensorRT Model Optimizer 庫中的優化經過組合,可通過使用 NVIDIA NIM 微服務的生產就緒型部署獲得。