快速發展的生成式 AI 領域專注于構建可以創建逼真內容(例如文本、圖像、音頻和合成數據)的神經網絡。生成式 AI 正在多個行業中引發革命,通過快速創建內容、為智能知識助手提供支持、增強軟件開發以編碼副駕駛,以及跨多個領域自動執行復雜任務。

然而,生成式 AI 模型基于有限數據進行訓練,只知道數據能告訴他們的內容。實際上,這是一個問題:確保生成內容的準確性和相關性,特別是對于模型訓練數據中沒有的信息。這些“知識差距”可能是時間方面的(例如,所有訓練數據都在 2023 年 4 月之前),也可能是領域方面的(例如,您的任何專有數據都未用于訓練模型)。

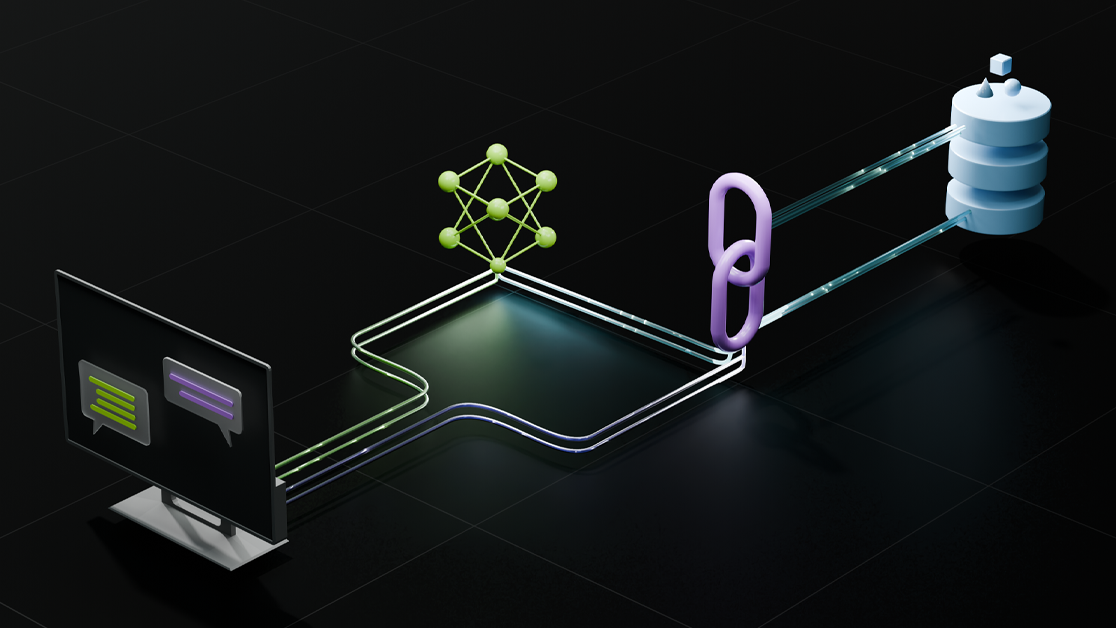

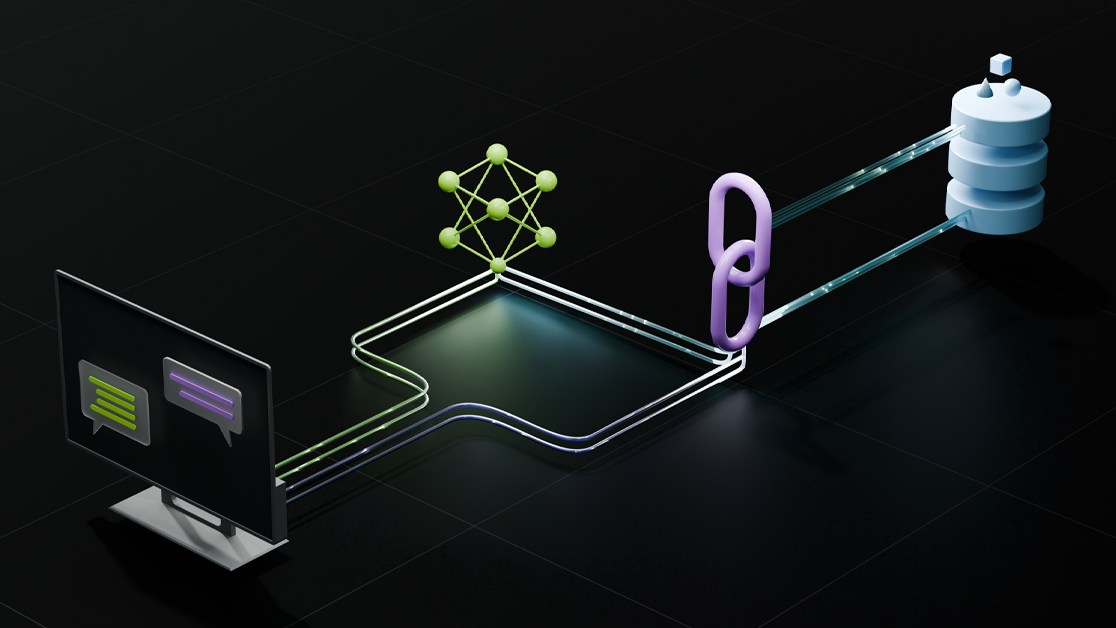

這正是檢索增強生成(RAG)發揮作用的地方。RAG 利用外部信息來源增強生成式模型(例如大型語言模型(LLM)),以有效地為模型提供它不知道的“事實”。這樣做將導致響應更加準確且與上下文相關,具體取決于外部信息的質量和模型的質量。

如何使用 RAG 的具體示例包括:

- 最新的聊天機器人:RAG-enabled 聊天機器人可以從公司的數據庫中實時獲取信息,以便準確響應客戶查詢。例如,模型不知道的最近停機情況。

- 上下文感知內容創建:RAG 應用可用于注入數據,以生成反映模型訓練后發生的當前事件的長格式內容。

- 基于搜索的內容匯總:添加互聯網搜索和文檔檢索功能可以將 RAG 應用轉變為動態內容生成器,該生成器使用傳統的搜索方法查找數據,然后將其輸入典型的 RAG 工作流。

本文介紹了 RAG 應用程序的兩種方法,即本地和混合方法,并展示了 NVIDIA AI Workbench 如何幫助您輕松開始使用 GitHub 中的混合 RAG 示例項目。

計算位置

RAG 的靈活性和強大功能并非免費實現的。RAG 應用程序由許多可移動的部分組成,大部分涉及某種形式的計算。例如,端到端 RAG 應用程序需要執行以下步驟:首先,將您的數據提取到向量數據庫中;然后,根據您的輸入從該數據庫中執行信息檢索;最后,將檢索到的數據通過 LLM 推送以生成適當的答案。最后一步在計算方面可能特別困難,這是 GPU 可以提供顯著優勢的地方。

最后,結果的質量在很大程度上取決于模型的大小,以數十億個參數進行測量。在所有條件相同的情況下,模型質量會隨著模型大小的增加而增加。例如,數百億個參數比數十億個參數更好。這是因為參數數量與可以訓練模型的數據量相關。更多的參數意味著更多的數據,從而產生更豐富、更復雜的響應。

由于更大的模型需要更大的 GPU 和更多的顯存(vRAM),用戶需要在其 RAG 應用程序中確定如何使用不同的 GPU。這提出了兩個問題:

- 如何配置 RAG 應用程序和所需模型,以便與給定 GPU 配合使用?

- GPU 在哪里運行?

本地 RAG

運行自托管 RAG 應用程序現在很受歡迎。在這種情況下,用戶或組織可以在其控制的資源上設置所有設置,包括 GPU。雖然這種方法在技術上比使用OpenAI 等服務復雜,但它可以實現自定義、隱私和成本控制,這些是第三方提供商無法實現的。

對于一些用戶而言,自托管甚至意味著在 AI 工作站上運行所有內容。這意味著,在配備一個或多個 NVIDIA RTX 6000 Ada 代 GPU 的 AI 工作站上,數據、查詢和計算保持完全隱私并獨立存在。 雖然單獨創建這樣的應用程序并不現實,但有一些高質量的 RAG 應用程序可以在本地運行。例如,LM Studio、AnythingLLM 和 NVIDIA 聊天 RTX 等應用程序都是用戶友好的,采用即插即用的方法。因此,用戶可以使用不同的模型和向量數據庫。

但是,如果您想執行某些操作,而這些操作超出了本地 GPU 的性能,該怎么辦?

一個答案是混合 RAG。

混合 RAG

Hybrid RAG 是一種方法,它使用在不同位置運行的計算資源來提供必要的計算能力。它被稱為 hybrid,因為它結合了不同但互補的資源。通常情況下,這意味著在本地 AI 工作站或 PC 上運行嵌入和檢索步驟,而遠程 GPU 資源則用于 LLM 推理計算。無論您是處理小型項目還是處理大量數據,這種組合都有助于產生最佳性能。

雖然這種方法聽起來很有吸引力,但自行構建混合 RAG 應用并非易事。您需要了解 LangChain 的基礎知識,以及數據存儲和管理、信息檢索、文本生成和構建用戶界面的基礎知識。然后,您需要做出技術決策,例如將模型大小、精度和令牌限制與目標硬件相匹配。最后,您需要了解如何連接所有內容,以便選擇在何處運行特定的計算組件。

NVIDIA AI Workbench 的用武之地有很多。這就是 NVIDIA AI Workbench 的用武之地。NVIDIA AI Workbench 是一款免費的解決方案,使您能夠在所選系統(PC、工作站、數據中心或云)上開發、測試和原型設計生成式 AI 應用程序。AI Workbench 既支持開發又支持訓練,您可以跨人員和系統創建和共享開發環境NVIDIA AI Workbench。

在本地或遠程工作站或 PC 上,只需幾分鐘即可安裝 AI Workbench 并開始使用。它支持 Windows 11、Ubuntu 22.04 和 24.04 以及 macOS。安裝后,您可以啟動新項目或從 AI Workbench 示例 on GitHub 中克隆一個項目。您可以通過選擇 GitHub 或 GitLab 進行一切工作,因此您可以像往常一樣工作,但仍然輕松分享您的工作。詳細了解 AI Workbench 入門。

采用 AI 的混合 RAG 工作臺

要查看示例應用程序,以便在本地或遠程系統上運行基于文本的自定義 RAG Web 應用程序和您自己的文檔,請查看 NVIDIA Hybrid RAG 項目。該項目是一個 Workbench 項目 ,在主機上運行具有 Gradio 聊天 UI 前端的容器化 RAG 服務器。此外,它還提供了 JupyterLab 開發環境,以及與 Visual Studio Code 集成的選項。您可以使用各種 模型,并選擇要運行推理的位置。

Hybrid RAG 項目相當簡單,因為它也是一個開發環境,您可以打開它并詳細了解 Hybrid RAG 的工作原理。它完全可修改,提供了一個合適的環境,以便開始學習如何設置混合應用程序。您可以使用它來學習,也可以將其分支并將其調整到您自己的應用程序中。

此項目與 NVIDIA API 目錄無縫集成,使開發者能夠利用基于云的推理端點進行快速原型設計和開發。另外,您可以下載 NVIDIA NIMs 到本地工作站或服務器,以進行本地部署和自定義。 NVIDIA 開發者計劃 為您提供免費的 NIM 實驗訪問權限。

重要的是,這些相同的 NIM 借助 NVIDIA AI Enterprise 許可證可以過渡到生產環境,從而確保從開發到部署的順暢路徑。憑借這種靈活性,您可以根據自己的需求選擇最適合的推理方法,無論是基于云、本地還是混合方法。在不同環境中,您也可以保持一致。

開始使用

Hybrid RAG 項目的混合方面超出了推理模式選擇的范圍。AI Workbench 本身具有簡單的混合部署模型,可以在 RTX PC 和工作站上本地安裝,也可以在云或數據中心的遠程資源上安裝。然后,您可以在本地運行此項目,或將其擴展到遠程云服務器或數據中心。 在您選擇的系統上運行項目的能力,無需手動設置基礎設施的開銷,這項能力擴展到所有 Workbench 項目。您可以在 AI Workbench 示例 on GitHub 針對特定領域的用途自定義。要創建自己的 Workbench 項目,請按照 用戶指南 中的步驟操作。