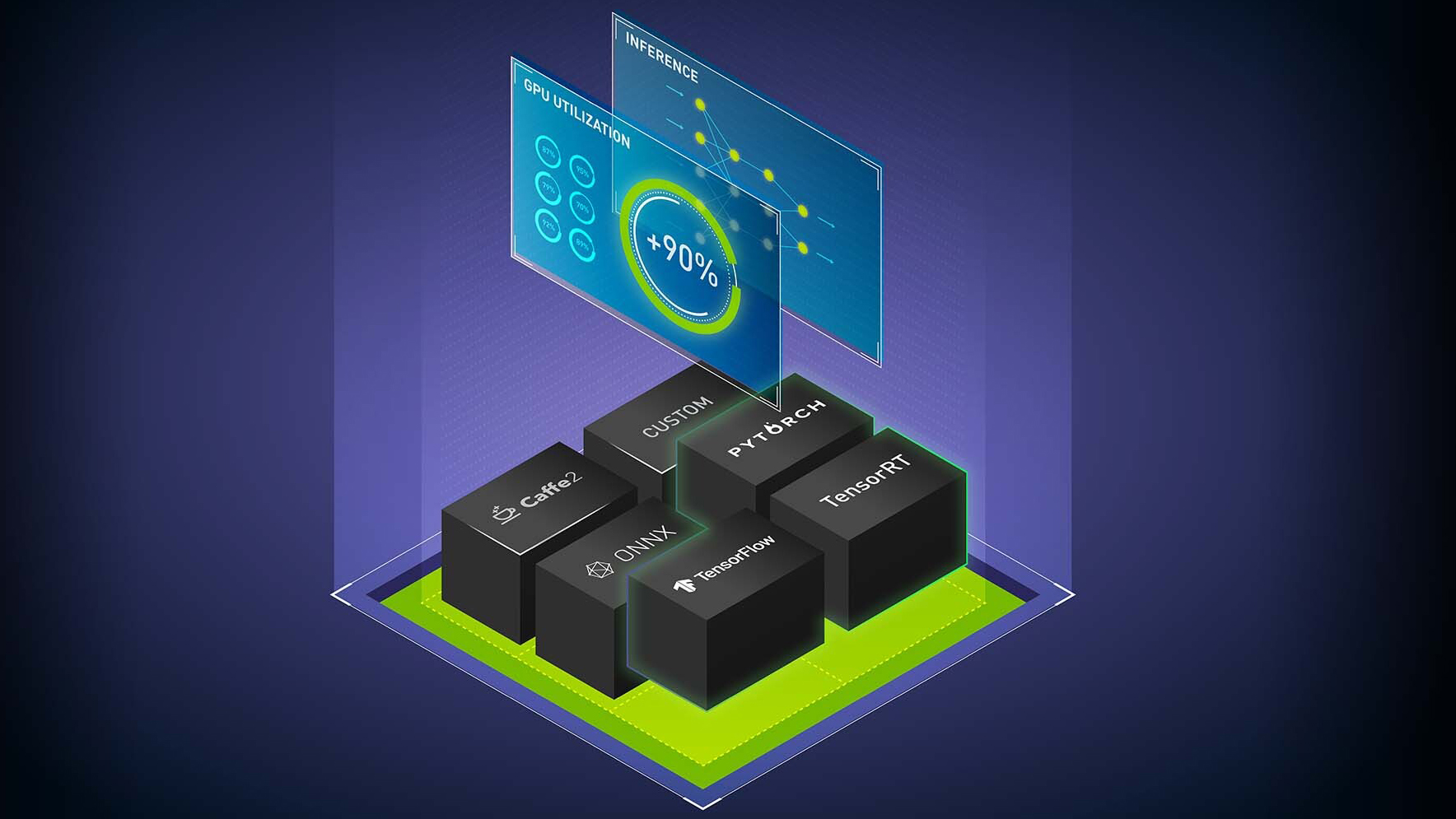

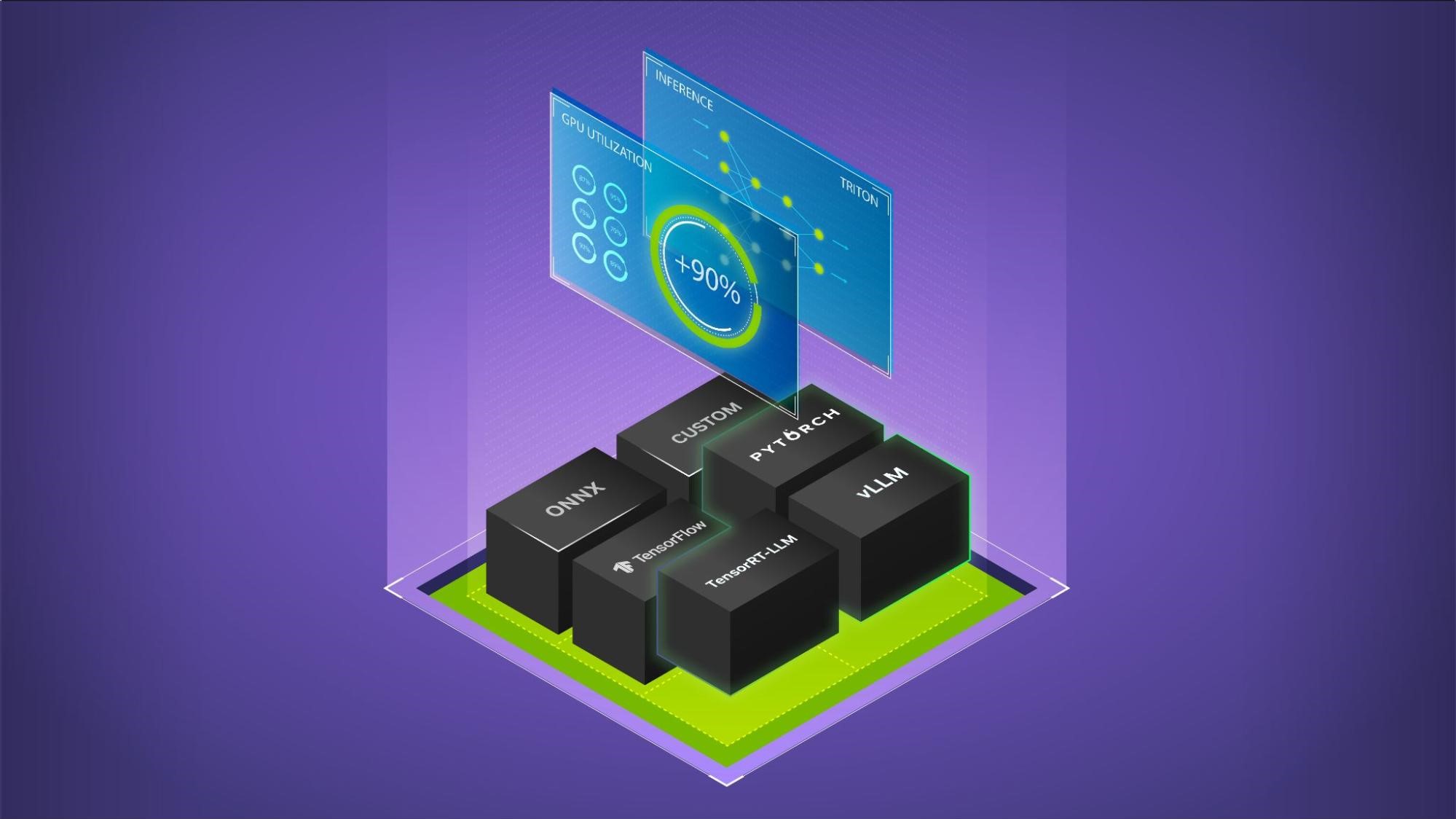

NVIDIA AI 推理軟件包括NVIDIA Triton 推理服務器,開源推理服務軟件,以及NVIDIA TensorRT,一個用于高性能深度學習推理的 SDK ,包括深度學習推理優化器和運行時。它們為所有人工智能深度學習用例提供加速推理。 NVIDIA Triton 還支持傳統的機器學習( ML )模型和 CPU 上的推理。這篇文章解釋了該軟件最近添加的關鍵新功能。

NVIDIA Triton

NVIDIA Triton 中的新功能包括 Py Triton 本機 Python 支持、模型分析器更新和 NVIDIA Triton 管理服務。

本機 Python 支持 PyTriton

PyTriton 功能提供了一個簡單的接口,可以在 Python 代碼中使用 NVIDIA Triton InferenceServer 。 Py Triton 使 Python 開發人員能夠使用 NVIDIA Triton 來服務從人工智能模型或簡單處理功能到整個推理管道的一切。

這種對 GPU 中 NVIDIA Triton 的原生支持使 ML 模型能夠以高性能、高效率和高硬件利用率進行快速原型設計和測試。一行代碼就可以調出 NVIDIA Triton ,提供了動態批處理、并發模型執行以及 Python 代碼中對 GPU 和 Python 的支持等優勢。這種方法無需設置模型存儲庫和轉換模型格式。您可以使用現有的推理管道代碼而無需修改。要嘗試,請訪問triton-inference-server/pytriton在 GitHub 上。

模型分析儀

模型分析器是一種幫助找到最佳 NVIDIA Triton 模型配置的工具,如批量大小、模型并發性和精度,以部署高效的推理。由于新的快速搜索模式,您可以在幾分鐘內獲得最佳配置,而無需花費數天時間手動嘗試配置參數

現在,除了支持具有預處理和后處理要求的現代推理工作負載的獨立模型外,模型分析器還支持模型集成(也稱為模型管道)和多模型分析。您可以為整個 ML 管道運行模型分析器。有關詳細信息,請參閱模型分析器文檔.

NVIDIA Triton 管理服務

NVIDIA Triton 管理服務為高效的多模型推理提供了模型編排功能。此功能作為生產服務運行,可根據需要加載模型,并在不使用時卸載模型

它通過在單個 GPU 服務器上放置盡可能多的模型來有效地分配[Z1K1’資源,并有助于對不同框架中的模型進行優化分組,以實現高效的內存使用。它現在支持基于推理和加密(AES-256)與應用程序通信的高利用率的 NVIDIA Triton 實例的自動縮放。申請提前訪問 NVIDIA Triton 管理服務。

NVIDIA TensorRT

TensorRT 中的新功能包括多 GPU 多節點推理、性能和硬件優化等。

多 – GPU 多節點推理

TensorRT 可用于運行大型語言模型( LLM )的多 GPU 多節點推理。它支持 GPT-3 175B 、 530B 和 6.7B 型號。這些型號不需要 ONNX 轉換;相反,一個簡單的 Python API 可用于優化多 GPU 推理。現在可以私人提前訪問。有關更多詳細信息,請聯系您的 NVIDIA 帳戶團隊

TensorRT 8.6

TensorRT 8.6 現在可提前訪問并且包括以下關鍵特征:

- 生成人工智能擴散和 transformer 模型的性能優化

- 在不同 GPU 體系結構上構建和運行的硬件兼容性 (NVIDIA Ampere 架構及以后)

- 版本兼容性,可在不同的 TensorRT 版本( TensorRT 8.6 及更高版本)上構建和運行

- 在構建時間和推理性能之間進行權衡的優化級別

客戶和合作伙伴亮點

了解以下新客戶和合作伙伴如何使用 NVIDIA Triton 和 TensorRT 進行人工智能推理。

Oracle 人工智能 使用 NVIDIA Triton 為 OCI Vision 中基于深度學習的圖像分析工作負載提供服務。視覺服務用于各種用例,從制造缺陷檢查到在線圖像中的標記項目。 Oracle 使用 NVIDIA Triton 實現了 50% 的低延遲和 2 倍的吞吐量。

Uber 利用 NVIDIA Triton 為 DeepETA (該公司基于深度學習的全球 ETA 模型)每秒提供數十萬次預測。

Roblox,在線體驗平臺,使用 NVIDIA Triton 在多個框架中運行所有人工智能模型,以實現游戲推薦、構建頭像、內容審核、市場廣告和欺詐檢測等用例。 NVIDIA Triton 讓數據科學家和 ML 工程師可以自由選擇他們的框架: TensorFlow 、 PyTorch 、 ONNX 或原始 Python 代碼。

Docusign 使用 NVIDIA Triton 運行 NLP 和計算機視覺模型,用于人工智能輔助審查和理解協議和合同條款。與之前基于 CPU 的解決方案相比,該公司實現了 10 倍的加速。

Descript 使用 TensorRT 優化模型以加速人工智能推理。它允許用戶在沒有演播室的情況下替換視頻背景并增強語音,以制作演播室質量的內容。

CoreWeave,專門的 GPU 云提供商使用 NVIDIA Triton 以低延遲和高吞吐量為 LLM 提供服務。

NVIDIA 推理軟件提供了關鍵的性能、效率和響應能力,為云、數據中心、網絡邊緣和嵌入式設備中的下一代人工智能產品和服務提供動力。從今天開始NVIDIA Triton和TensorRT.