在生成式 AI 時代,加速網絡對于為大規模分布式 AI 工作負載構建高性能計算結構至關重要。NVIDIA 在該領域繼續保持領先地位,提供先進的以太網和 InfiniBand 解決方案,可最大限度地提高 AI 工廠和云數據中心的性能和效率。

這些解決方案的核心是 NVIDIA SuperNIC,一種經過優化的新型網絡加速器,可為超大規模 AI 工作負載提供支持。這些 SuperNIC 是 NVIDIA Spectrum-X 以太網和 Quantum-X800 InfiniBand 網絡平臺的關鍵組件,旨在提供前所未有的可擴展性和性能。

NVIDIA SuperNIC 產品組合中的最新成員 ConnectX-8 SuperNIC 與 BlueField-3 SuperNIC 一起,共同推動加速的大規模 AI 計算結構的新一輪創新浪潮。ConnectX-8 SuperNIC 的總數據吞吐量為 800 Gb/s,可提供所需的速度、穩健性和可擴展性,為萬億參數 AI 模型提供動力支持,并與 NVIDIA 交換機無縫集成,以實現最佳性能。本文將探討 NVIDIA SuperNIC 的獨特屬性及其在推進現代 AI 基礎設施發展方面的關鍵作用。

利用 RoCE 處理 AI 工作負載?

對于 AI 模型訓練來說,在數據中心的 GPU 之間高速移動龐大的數據集至關重要,以縮短訓練時間并加快 AI 解決方案的上市時間。

NVIDIA SuperNIC 具有出色的硬件內部 RoCE 加速和 GPUDirect RDMA,速度高達 800 Gb/s,可繞過 CPU 在 GPU 之間實現直接數據移動,從而應對這些挑戰。

這種直接通信路徑可最大限度地減少 CPU 開銷并降低延遲,從而在 GPU 內存之間實現更快、更高效的數據傳輸。實際上,此功能可實現更高的并行性,跨多個節點擴展 AI 工作負載,而不會出現基于 CPU 的傳統數據傳輸通常引入的瓶頸。

使用 Spectrum-X RoCE 自適應路由增強人工智能性能

NVIDIA SuperNIC 提供的直接數據放置(DDP)支持是 Spectrum-X 中提升 AI 網絡性能的關鍵功能之一。

隨著生成式 AI 工作負載跨數千個節點擴展,等價多路徑(ECMP)等傳統 IP 路由協議難以處理 AI 模型生成的大規模、持續的數據流(稱為 大象流 )。這些流可能會使網絡資源不堪重負,并導致擁塞,從而降低整體網絡性能。

Spectrum-X RoCE 動態路由動態調整流量在可用網絡路徑中的分配方式,確保高帶寬流以最佳方式路由,以防止網絡擁塞。該方法利用 NVIDIA Spectrum-4 以太網交換機的功能,該交換機可在多個路徑上均勻噴灑數據包,以平衡負載,避免傳統靜態路由機制造成的瓶頸。

然而,使用數據包噴灑時,出現了亂序數據包交付的挑戰。

NVIDIA SuperNIC 通過在數據包到達接收端時將其直接按順序放入緩沖區來解決這一問題,確保按照正確的順序接收數據。這使得 NVIDIA 交換機和 SuperNIC 之間實現了緊密的協調,實現了高效、高速的 AI 工作負載通信,確保大規模 AI 模型能夠繼續處理數據,而不會中斷或降低性能。

解決 AI 網絡擁塞問題?

由于 AI 工作負載具有突發性質,因此極易受到擁塞的影響。AI 模型訓練(尤其是在多個 GPU 同步和共享數據的集合操作期間)產生的頻繁且短命的流量峰值,需要高級擁塞管理來保持網絡性能。傳統的擁塞控制方法(例如基于 TCP 的流量控制)不足以滿足 AI 獨特的流量模式。

為了解決這一問題,Spectrum-X 采用了先進的擁塞控制機制,這些機制與 Spectrum-4 交換機的實時遙測功能緊密集成。這種集成使 SuperNIC 能夠根據當前的網絡利用率主動調整數據傳輸速率,從而在出現問題之前防止擁塞。

通過使用帶內高頻遙測數據,SuperNIC 可以以微秒級精度作出反應,確保即使在高流量條件下也能優化網絡帶寬并盡可能降低延遲。

使用增強的可編程 I/O 加速 AI 網絡

隨著 AI 工作負載日益復雜,網絡基礎設施不僅必須在速度上不斷發展,還需要在適應性方面進步,以支持數千個節點之間的各種通信模式。

NVIDIA SuperNIC 處于這項創新的前沿,提供增強的可編程 I/O 功能,這些功能對于現代 AI 數據中心環境至關重要。這些 SuperNIC 具有加速數據包處理管線,能夠以線速運行,吞吐量高達 800 Gb/s。

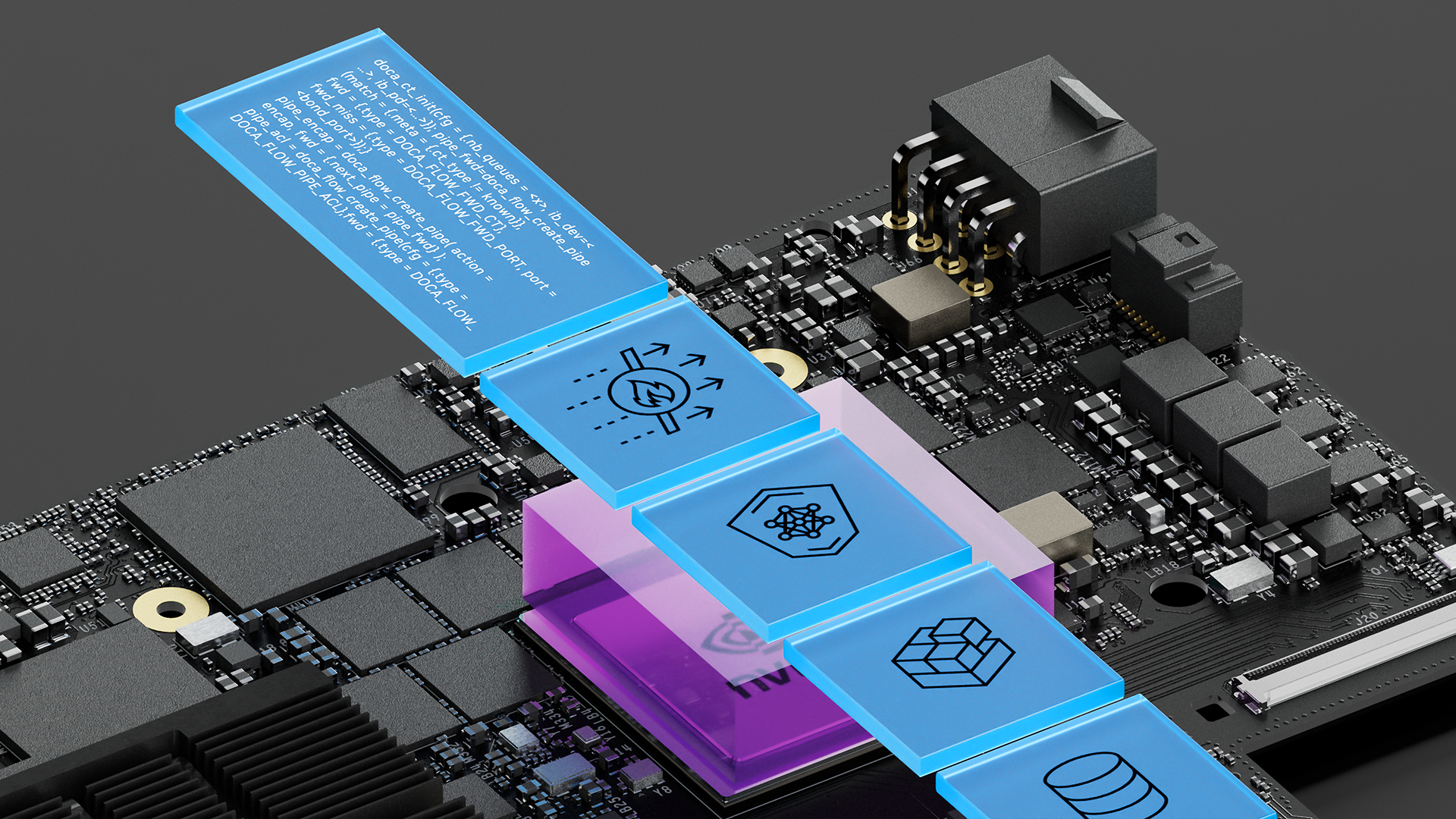

通過將數據包處理任務從 CPU 卸載到 SuperNIC,此管道可顯著降低網絡延遲并提高整體系統效率。管道的可編程性由 NVIDIA DOCA 軟件框架提供支持,為網絡專業人員提供了大規模構建和優化網絡的靈活性。

NVIDIA SuperNIC 采用數據路徑加速器(DPA),可增強可編程性。DPA 是一種高度并行的 I/O 處理器,配備 16 個超線程核心,專為處理 I/O 密集型工作負載而設計。它可以通過 DOCA 針對設備仿真、擁塞控制和流量管理等各種低代碼應用程序輕松進行編程。這種可編程性使組織能夠根據其 AI 工作負載的特定需求定制網絡基礎設施,確保數據在保持峰值性能的同時跨網絡高效流動。

保護 AI 網絡連接?

保護 AI 模型對于保護敏感數據和知識產權免遭潛在的漏洞和對抗性攻擊至關重要。當您的組織構建 AI 工廠和云數據中心時,您需要有效的安全解決方案來解決可能損害模型性能和可信度的漏洞,最終保護競爭優勢和用戶隱私。

傳統的網絡加密方法通常難以擴展到 100 Gb/s 以上,從而使關鍵數據處于危險之中。相比之下,NVIDIA SuperNIC 可提供加速網絡和在線加密加速,速度高達 800 Gb/s,確保數據在傳輸過程中保持加密狀態,同時實現峰值 AI 性能。

NVIDIA SuperNIC 為 IPsec、TLS 和可擴展的 PSP 加密操作提供硬件加速支持,為保護人工智能網絡環境提供成熟的解決方案。

PSP 由 Google 開發,并為開源社區做出了貢獻。PSP 從一開始就采用無狀態設計,非常適合支持超大規模數據中心環境的需求。該架構允許獨立處理每個請求,從而增強在分布式系統中管理加密操作的可擴展性和彈性。

結束語?

在生成式 AI 的動態格局中,NVIDIA SuperNIC 作為 NVIDIA Spectrum-X 和 Quantum-X800 網絡平臺不可或缺的一部分,為網絡的變革時代奠定了基礎。

NVIDIA SuperNIC 具有超快的數據吞吐量、智能擁塞管理、強大的安全功能和可編程 I/O 等出色功能,正在徹底改變 AI 工作負載的交付方式。通過無縫集成尖端技術和出色的性能,NVIDIA SuperNIC 助力組織機構充分發揮其 AI 計劃的潛力,以前所未有的規模推動創新。

有關 NVIDIA SuperNIC 的更多信息,請參閱以下資源:

?