Benchmark

2024年 7月 17日

NVIDIA NeMo 借助混合狀態空間模型加速 LLM 創新發展

當今的大型語言模型(LLM)基于 2017 年推出的 Transformer 模型架構。自那時以來,

2 MIN READ

2024年 6月 12日

NVIDIA 在 MLPerf Training v4.0 中創造了新的生成式 AI 性能和規模記錄

生成式 AI 模型具有多種用途,例如幫助編寫計算機代碼、創作故事、作曲、生成圖像、制作視頻等。而且,隨著這些模型的大小不斷增加,

3 MIN READ

2024年 6月 10日

NVIDIA 文本嵌入模型位列 MTEB 排行榜榜首

NVIDIA 的最新嵌入模型NV-Embed- 以 69.32 的分數創下了嵌入準確率的新紀錄海量文本嵌入基準測試 (MTEB)涵蓋 56…

2 MIN READ

2024年 4月 29日

GPU 驅動的 Windows 365 云 PC 與 NVIDIA RTX 虛擬工作站,用于高端圖形工作負載

隨著對圖形密集型場景的需求增加,專業工作流程變得更加復雜。從常規的辦公應用程序到高要求的制造、建筑、工程以及媒體和娛樂應用程序,

2 MIN READ

2024年 4月 3日

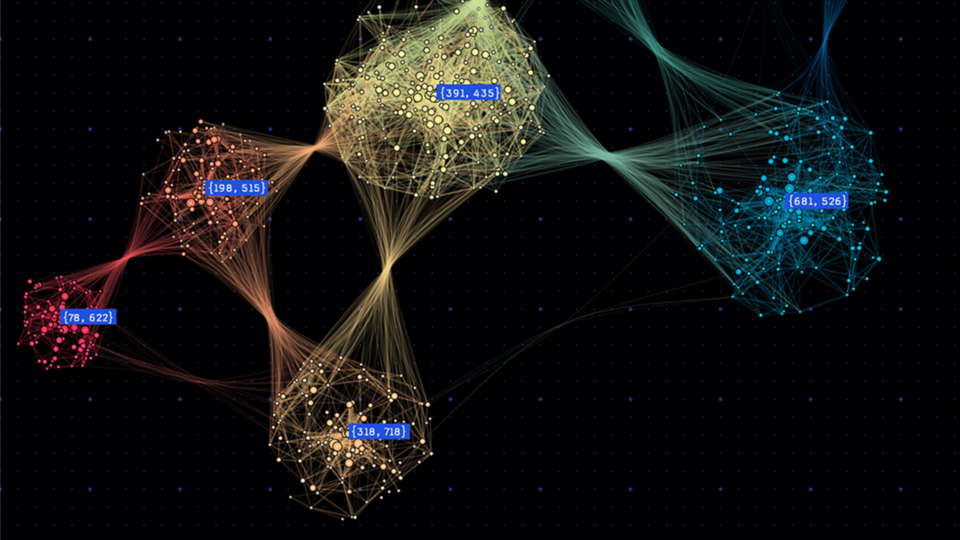

使用 WholeGraph 優化圖形神經網絡的內存和檢索,第 2 部分

大規模圖形神經網絡 (GNN) 訓練帶來了艱巨的挑戰,特別是在圖形數據的規模和復雜性方面。這些挑戰不僅涉及神經網絡的正向和反向計算的典型問題,

2 MIN READ

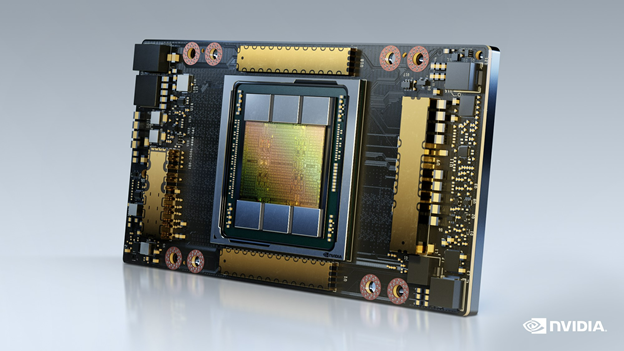

2024年 3月 27日

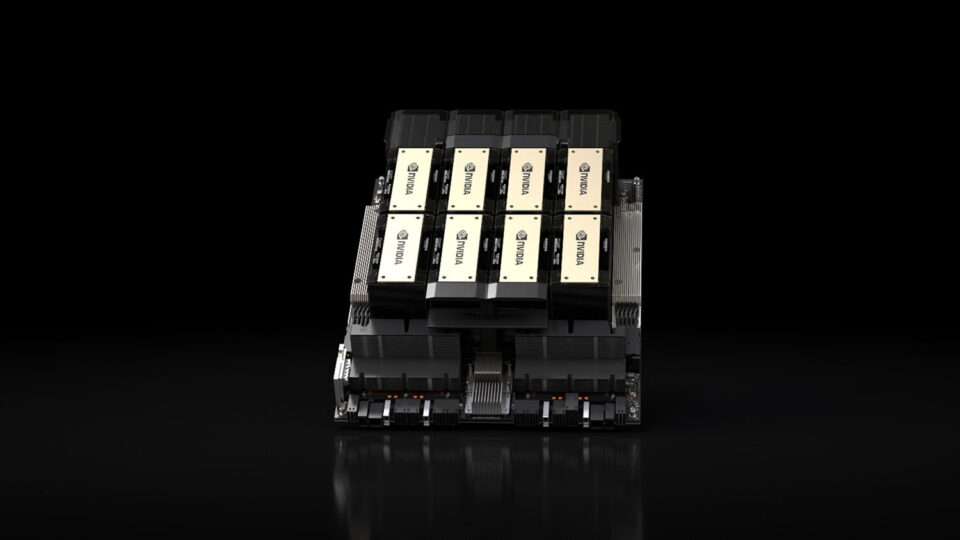

NVIDIA H200 Tensor Core GPU 和 NVIDIA TensorRT-LLM 集 MLPerf LLM 推理記錄

隨著生成式 AI 模型的持續創新,生成式 AI 在計算應用方面取得了巨大進步,從而大幅增強人類能力。這些模型包括 生成式 AI 模型,

3 MIN READ

2024年 3月 19日

NVIDIA 語音和翻譯 AI 模型在速度和準確性方面創下記錄

NVIDIA 開發的語音和翻譯 AI 模型正在推動性能和創新的發展。NVIDIA Parakeet 自動語音識別 (ASR) 模型系列以及…

2 MIN READ

2024年 3月 18日

RAPIDS cuDF 可將 pandas 加速近 150 倍,且無需更改代碼

在 NVIDIA GTC 2024 上,我們宣布 RAPIDS cuDF 現在可以為 950 萬 Pandas 用戶帶來 GPU 加速,

2 MIN READ

2024年 3月 18日

借助加速以太網網絡和網絡存儲擴展企業 RAG

在生成式人工智能中,機器不僅可以從數據中學習,還可以生成類似人類的文本、圖像、視頻等。檢索增強生成 (RAG) 是一種突破性的方法。

2 MIN READ

2024年 3月 5日

NVIDIA RTX 500 和 1000 Ada Generation 筆記本電腦 GPU 可隨時隨地驅動 AI 增強型工作流

輕薄設計為專業人士提供先進的 AI、計算和圖形處理能力。 隨著生成式 AI 和混合工作環境成為新標準,無論是內容創作者、研究人員還是工程師,

1 MIN READ

2023年 2月 9日

通過 GROMACS 大幅提高多節點 NVIDIA GPU 的可擴展性

GROMACS 是一種廣泛用于模擬生物分子系統的科學軟件包,在理解對疾病預防和治療重要的重要生物學過程中發揮著至關重要的作用。

3 MIN READ

2023年 2月 2日

針對 NVIDIA GPU 的低延遲交易和快速回測的深度神經網絡基準

降低對新市場事件的響應時間是算法交易的一個驅動力。對延遲敏感的交易公司通過在其系統中部署諸如現場可編程門陣列( FPGA )和專用集成電路(…

2 MIN READ

2022年 11月 9日

領先的 MLPerf Training 2.1 ,具有針對 AI 的全棧優化

MLCommons 開發的 MLPerf 基準是組織衡量其機器學習模型跨工作負載培訓性能的關鍵評估工具。

4 MIN READ

2022年 6月 30日

為 NVIDIA MLPerf Training v2.0 性能提供動力的全堆棧優化

MLPerf benchmarks 由工業界、學術界和研究實驗室的人工智能領導者組成的聯盟開發,旨在提供標準、公平和有用的深度學習性能測量。

4 MIN READ

2022年 6月 1日

通過全棧創新推動高性能計算

高性能計算(HPC)已成為科學發現的基本工具。 無論是發現新的拯救生命的藥物,對抗氣候變化,還是創建精確的世界模擬,

3 MIN READ

2022年 4月 6日

在 MLPerf 推理 2.0 上獲得最佳性能

Megatron 530B 等機型正在擴大人工智能可以解決的問題范圍。然而,隨著模型的復雜性不斷增加,它們對人工智能計算平臺構成了雙重挑戰:

4 MIN READ