在快速發展的生成式 AI 領域,編碼模型已成為開發者不可或缺的工具,可提高軟件開發的生產力和精度。它們通過自動執行復雜任務、增強可擴展性和促進創新提供顯著優勢,使其成為現代軟件開發的寶貴工具。

本文將探討 Codestral Mamba 的優勢,重點介紹其 Mamba-2 架構,在 NVIDIA TensorRT-LLM 中支持的推理優化,以及借助 NVIDIA NIM 輕松部署以實現變革潛力和編碼效率的提升。

Codestral Mamba

Codestral Mamba 由 Mistral 開發,是基于創新 Mamba-2 架構構建的突破性編碼模型,專為實現出色的代碼完成而設計。

Codestral Mamba 采用名為fill-in-the-middle (

- FIM

) 的先進技術,在生成準確且上下文相關的代碼示例方面樹立了新標準。

Codestral Mamba 與 NVIDIA NIM 實現無縫集成,用于容器化,還可確保跨不同環境的輕松部署。

以下語法和功能正確的代碼示例由 Mistral NeMo 使用英語語言提示生成。您可以將其復制到開發環境中。要生成其他代碼示例,請參閱NVIDIA API 目錄。

from collections import dequedef bfs_traversal(graph, start): visited = set() queue = deque([start]) while queue: vertex = queue.popleft() if vertex not in visited: visited.add(vertex) print(vertex) queue.extend(graph[vertex] - visited)# Example usage:graph = { 'A': set(['B', 'C']), 'B': set(['A', 'D', 'E']), 'C': set(['A', 'F']), 'D': set(['B']), 'E': set(['B', 'F']), 'F': set(['C', 'E'])}bfs_traversal(graph, 'A') |

Mamba-2

Mamba-2 架構是一種高級狀態空間模型 (SSM) 架構。這是一種遞歸模型,經過精心設計,以挑戰基于注意力的架構在語言建模方面的優勢。

Mamba-2 通過結構化空間對偶 (SSD) 概念連接 SSM 和注意力機制,探索這一概念可提高準確性和實現性,相比 Mamba-1。

該架構使用選擇性 Selective SSM,這些 Selective SSM 可以動態選擇在每個時間步長關注或忽略輸入。這種靈活性通過將計算資源集中在輸入的最相關部分,實現了更高效的序列處理。

Mamba-2 還解決了張量并行性的低效問題,并提高了模型的計算效率,使其更快、更適合 GPUs。

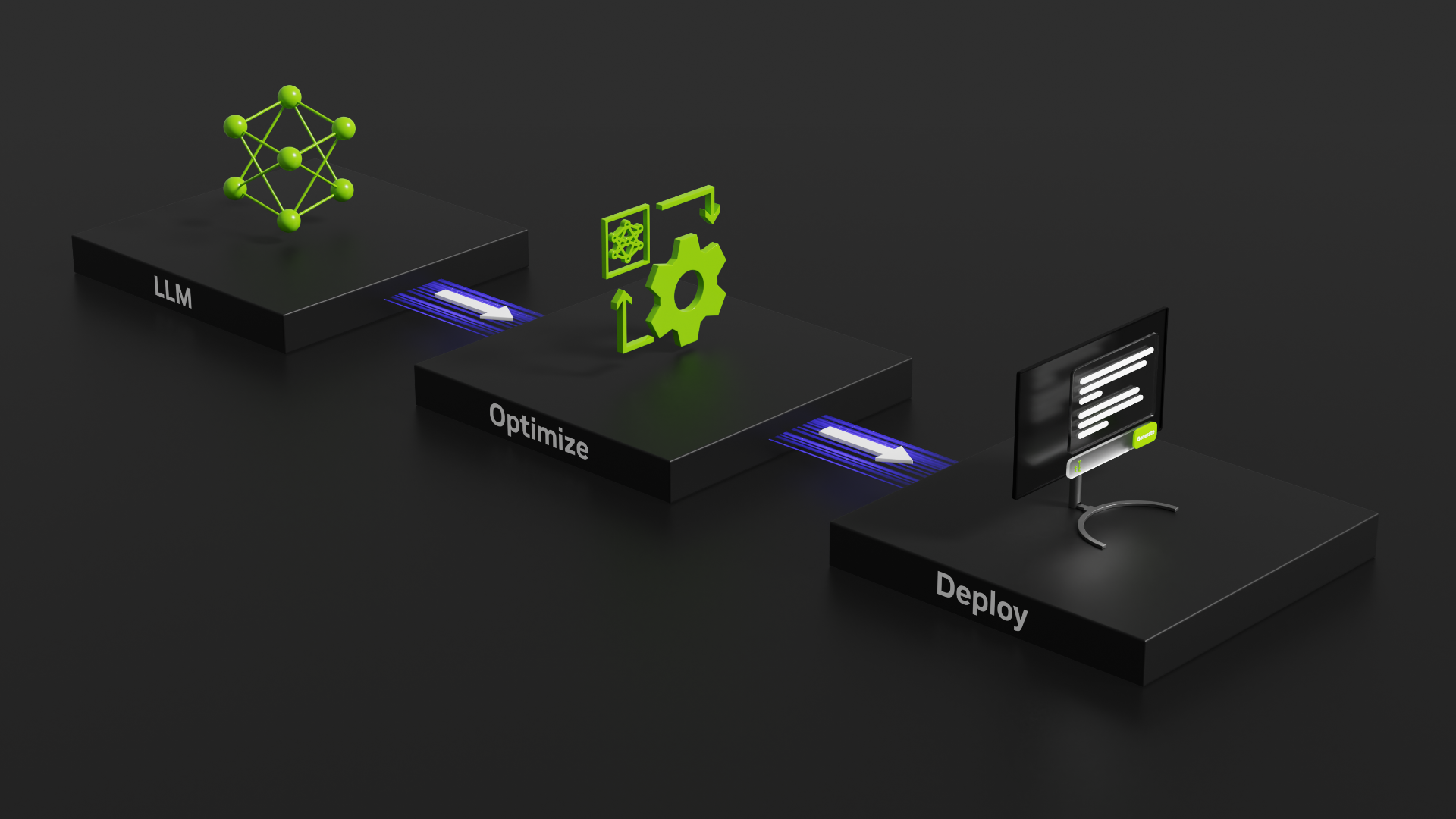

TensorRT-LLM

NVIDIA TensorRT-LLM 通過支持 Mamba-2 的 SSD 算法來優化 LLM 推理。SSD 保留了 Mamba-1 選擇性 SSM 的核心優勢,如快速自回歸推理和可并行的選擇性 掃描,以過濾無關信息。它進一步簡化了 SSM 參數矩陣 A,從對角線結構到標量結構,以便使用矩陣乘法單元,例如 Transformer 注意力機制使用的單元,這些單元也可以由 GPU 加速。

Mamba-2 的 SSD 及 TensorRT-LLM 的另一個好處是,它能夠在所有狀態維度 N (d_state) 和頭部維度 D (d_head) 之間共享遞歸動力學。這使得它能夠使用 GPU Tensor Cores 支持更大的狀態空間擴展,相比 Mamba-1。使用 GPU Tensor Cores。更大的狀態空間有助于提高模型質量和生成的輸出。

在基于 Transformer 的模型中,可變長度序列的批處理可能是一項挑戰,需要對所有序列進行填充以使其具有相同的長度(浪費計算),或者對可變序列長度實現專門的注意機制,并進行仔細的負載平衡。

基于 Mamba-2 的模型可以將整個批量視為一個長序列,并通過在每個序列結束時將狀態轉換設置為 0,避免在批量中的不同序列之間傳遞狀態。

TensorRT-LLM 支持 SSD 在上下文和生成階段中使用 Tensor Core 矩陣乘對輸入序列進行分塊和狀態傳遞。它使用中間較短分塊狀態的分塊掃描來確定給定所有之前輸入的最終輸出狀態。

NVIDIA NIM

NVIDIA NIM 推理微服務旨在跨 NVIDIA 加速基礎設施 (包括云、數據中心和工作站)Anywhere 簡化和加速生成式 AI 模型的部署。

NIM 使用推理優化引擎、行業標準的 APIs 和預構建容器,提供可隨需求擴展的高吞吐量 AI 推理。它支持語音、圖像、視頻、醫療健康等領域的各種生成式 AI 模型。

NIM 可提供出色的吞吐量,使企業生成 tokens 的速度提升高達 5 倍。對于生成式 AI 應用,token 處理是關鍵的性能指標,而 token 吞吐量的增加直接轉化為企業收入的增加。

開始使用

要體驗 Codestral Mamba,請參閱 Instantly Deploy Generative AI with NVIDIA NIM. 在這里,您還可以找到流行的模型,如 Llama3-70B, Llama3-8B, Gemma 2B, 和 Mixtral 8X22B.

借助免費的 NVIDIA 云計算積分,您可以開始大規模測試模型,并通過將應用程序連接到在完全加速的堆棧上運行的 NVIDIA 托管 API 端點來構建概念驗證.

?