Benchmark

2025年 4月 15日

NVIDIA Llama Nemotron 超開放模型實現突破性的推理準確性

AI 不再只是生成文本或圖像,而是要針對商業、金融、客戶和醫療健康服務中的現實應用進行深度推理、詳細解決問題并實現強大的適應性。

2 MIN READ

2025年 4月 2日

LLM 基準測試:基本概念

在過去幾年中,作為廣泛的 AI 革命的一部分, 生成式 AI 和 大語言模型 (LLMs) 越來越受歡迎。

4 MIN READ

2025年 3月 21日

借助 NVIDIA Parabricks 和 NVIDIA AI Blueprints,將基因組學和單細胞分析時間縮短至幾分鐘

NVIDIA Parabricks 是一款可擴展的基因組學分析軟件套件,通過加速計算和深度學習解決 omics 挑戰,實現新的科學突破。

3 MIN READ

2025年 3月 18日

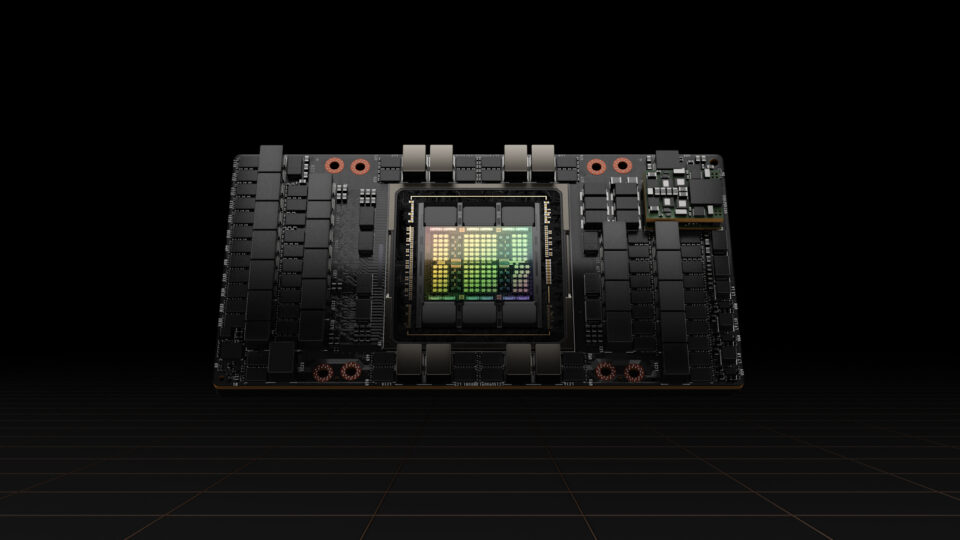

NVIDIA Blackwell 實現世界紀錄的 DeepSeek-R1 推理性能

NVIDIA 在 NVIDIA GTC 2025 上宣布了創下世界紀錄的 DeepSeek-R1 推理性能 。 搭載 8 個 NVIDIA…

5 MIN READ

2025年 3月 18日

NVIDIA NeMo 檢索器將準確的多模態 PDF 數據提取速度提高 15 倍

企業生成和存儲的多模態數據比以往任何時候都多,但傳統的檢索系統在很大程度上仍然以文本為重點。雖然他們可以從書面內容中獲得見解,

3 MIN READ

2025年 3月 18日

借助 NVIDIA DGX 云基準測試衡量和提高 AI 工作負載性能

隨著 AI 功能的進步,了解硬件和軟件基礎架構選擇對工作負載性能的影響對于技術驗證和業務規劃都至關重要。

2 MIN READ

2025年 3月 11日

在 NVIDIA Grace CPU 上使用 Polars 和 Apache Spark 實現高效 ETL

NVIDIA Grace CPU 超級芯片可為數據中心和云端的 CPU 工作負載提供出色的性能和出色的能效。

3 MIN READ

2025年 2月 14日

使用 NVIDIA TensorRT-LLM 前瞻性解碼優化 Qwen2.5-Coder 吞吐量

專注于編碼的 大語言模型(LLMs) 已穩步應用于開發者工作流程。從配對編程到自我改進的 AI 智能體 ,這些模型可幫助開發者完成各種任務,

3 MIN READ

2025年 1月 16日

利用 RAPIDS cuML 加速時間序列預測

時間序列預測是一種強大的數據科學技術,用于根據過去的數據點預測未來值 借助 skforecast 等開源 Python 庫,

2 MIN READ

2025年 1月 16日

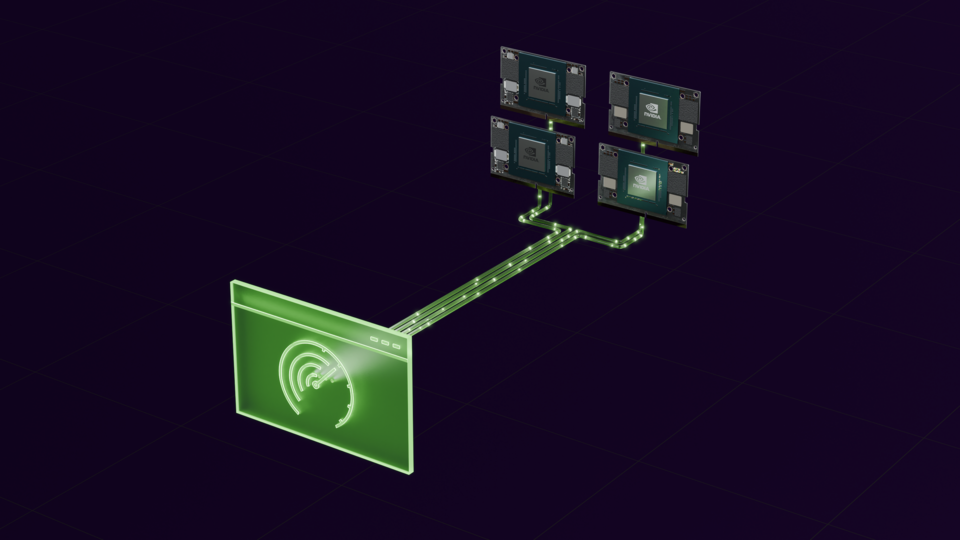

NVIDIA JetPack 6.2 為 NVIDIA Jetson Orin Nano 和 Jetson Orin NX 模塊引入超級模式

NVIDIA Jetson Orin Nano 超級開發者套件 的推出為小型邊緣設備開啟了 生成式 AI 的新時代。

7 MIN READ

2024年 12月 19日

RAPIDS 24.12 推出基于 PyPI 的 cuDF、適用于 Polar 的 CUDA 統一內存和更快的 GNN

RAPIDS 24.12 將 cuDF 包引入 PyPI,加快了 聚合和從 AWS S3 讀取文件的速度,

3 MIN READ

2024年 12月 17日

借助 NVIDIA TensorRT-LLM 預測解碼,將 Llama 3.3 的推理吞吐量提升 3 倍

隨著近期新增的 Llama 3.3 70B (一種純文本指令調整模型),Meta 的開放 大語言模型 (LLMs) 集合將繼續增長。

4 MIN READ

2024年 11月 19日

Llama 3.2 全棧優化釋放 NVIDIA GPU 的高性能

Meta 最近發布了 Llama 3.2 系列視覺語言模型(VLM),其中包含 11B 參數和 90B 參數變體。這些模型是多模態模型,

2 MIN READ

2024年 11月 15日

借助 NVIDIA TensorRT-LLM 分塊預填充提高 AI 推理效率和簡化部署

在本 博文 中,我們詳細介紹了分塊預填充,這是 NVIDIA TensorRT-LLM 的一項功能,

1 MIN READ

2024年 11月 13日

NVIDIA Blackwell 在 MLPerf 訓練 v4.1 中將 LLM 訓練性能提高一倍

隨著模型規模的擴大以及使用更多數據進行訓練,它們的能力也隨之提升,實用性也隨之提升。為了快速訓練這些模型,需要在數據中心規模上提供更高的性能。

3 MIN READ

2024年 11月 8日

NVIDIA TensorRT-LLM KV 緩存早期重用實現首個令牌速度 5 倍提升

在上一篇 博客文章 中,我們展示了通過將鍵值 (KV) 緩存卸載到 CPU 內存來重復使用該緩存如何在基于 x86 的 NVIDIA…

2 MIN READ