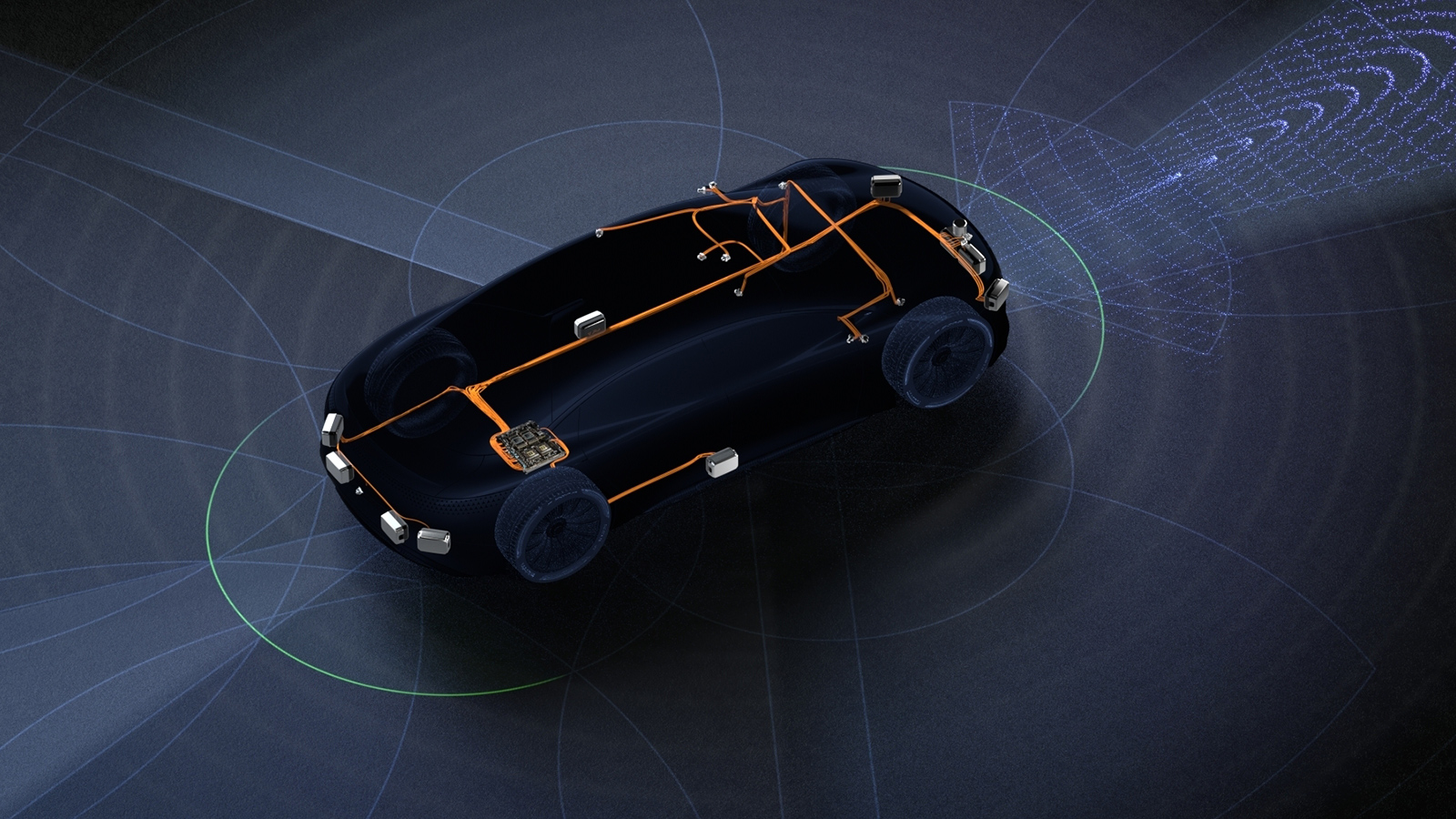

自動駕駛汽車 (AV) 有各種形狀和大小,從小型客車到多軸半掛卡車不等。但是,部署在這些車輛上的感知算法必須經過訓練,以處理類似情況,例如避開障礙物或行人。

用于開發和驗證這些算法的數據集通常由一種類型的車輛收集,例如配備攝像頭、雷達、激光雷達和超聲波傳感器的轎車。

在車隊傳感器數據上訓練的感知算法可以在類似的傳感器配置上可靠地執行。但是,在使用不同傳感器配置的車輛上部署相同的算法時,感知性能會降低,因為它是從新的角度來看世界的。

要解決感知準確性方面的任何損失,需要測量深度神經網絡 (DNN) 對新傳感器位置的敏感度。使用靈敏度分析,可以從多個角度重新訓練感知算法,從而有針對性地提高可靠性。

但是,執行靈敏度分析和重新訓練感知都需要跨各種傳感器配置收集和標注數據集。這是一個耗時且成本高昂的過程。

這篇博文展示了合成數據集如何通過 NVIDIA DRIVE Sim 以及 NVIDIA 在新視圖合成 (NVS) 方面的最新研究,來填補數據缺口,并有助于在部署新傳感器配置時保持感知準確性。

測量 DNN 靈敏度

在創建合成數據集以模擬不同傳感器視角之前,首先需要在 NVIDIA DRIVE Sim 中構建測試車隊車輛的數字孿生,并配備經過校準的仿真攝像頭傳感器,以匹配真實世界的傳感器配置。

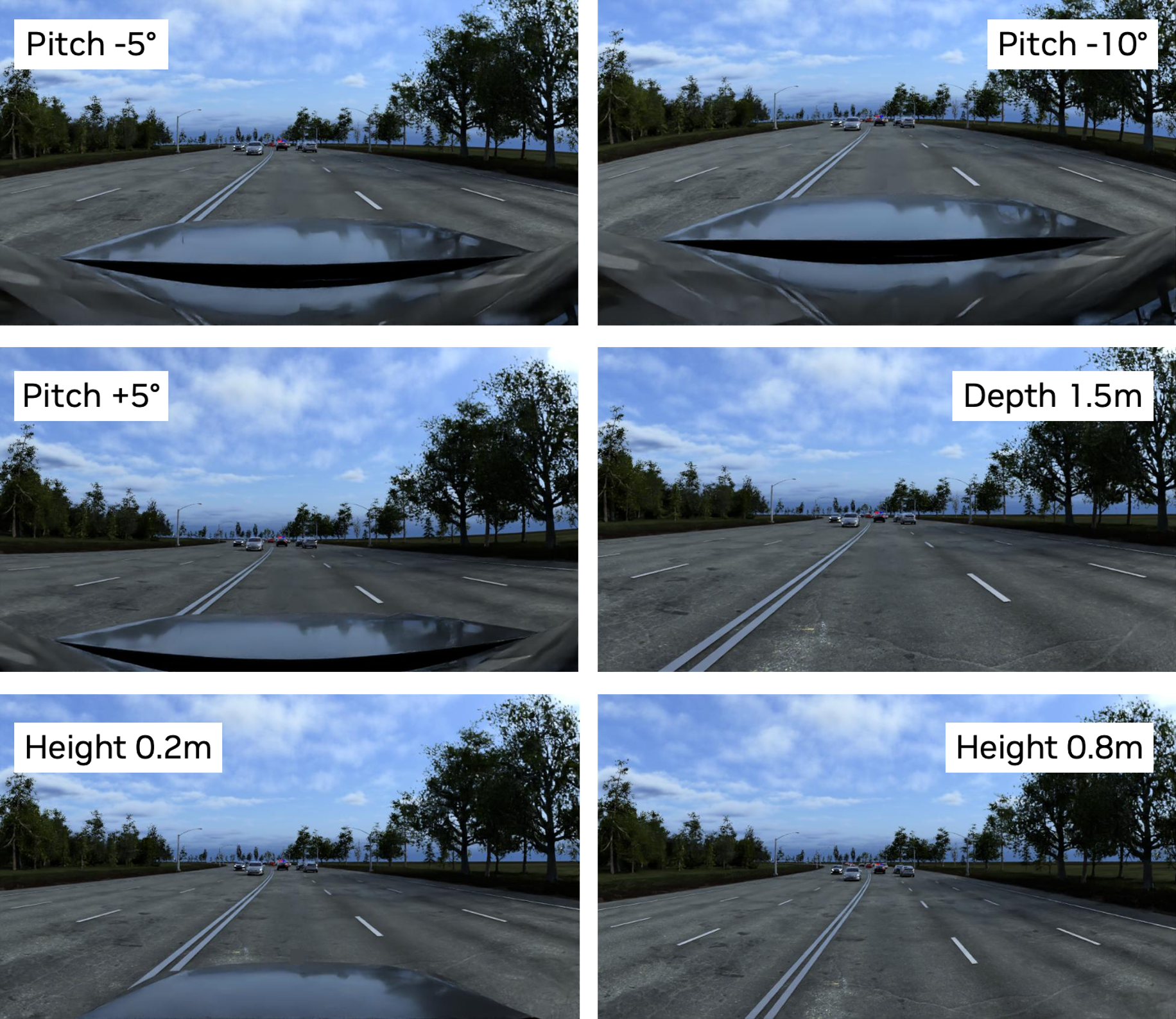

合成數據是通過在預定義的場景中駕駛自我車輛,使其遵循特定的軌跡,并保存模擬的攝像頭數據來生成的。在場景的每次運行中,傳感器裝備高度、俯仰角和安裝位置等方面都各不相同,以模擬其他類型的車輛。

使用 NVIDIA Omniverse Replicator 在 Omniverse 中生成真值 (Ground Truth, GT) 標簽,如 3D 邊界框和目標類別,這對評估感知算法至關重要。整個工作流程都是可復現的,支持定義明確的實驗運行,以便快速測量感知算法的靈敏度。

在對生成的數據集運行 DNN 推理后,將網絡的預測與 GT 標簽進行比較,以測量網絡針對不同攝像頭高度的每個傳感器配置的準確性,如圖 1 和 2 所示。每個數據集的場景相同,但從不同的傳感器角度來看。在圖 1 中,藍色框代表 GT 標簽,而綠色框代表網絡的預測。在圖 2 中,藍色框代表 GT 標簽,而紅色框代表網絡的預測。

鑒于網絡是根據一種車輛類型的數據進行訓練的,因此類似攝像頭位置的檢測結果更準確,并且會隨著攝像頭位置的顯著變化而降低。

要解決新型車輛在感知和部署方面的這些差距,需要針對不同于原始數據的觀點建立有針對性的數據集。雖然現有車隊數據可用于傳統的增強功能,但這種方法并不能完全滿足從新的觀點捕獲數據集的需求。

新穎的視圖合成

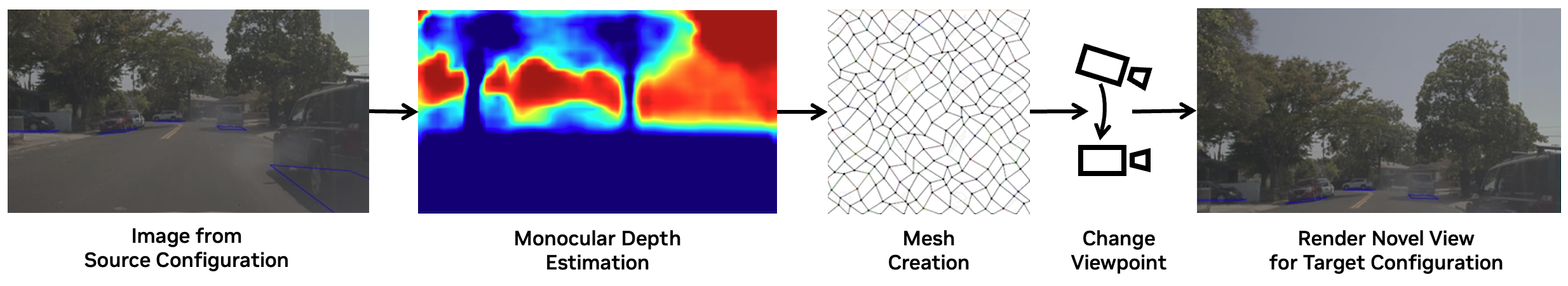

NVS 是一種計算機視覺方法,用于從一組現有圖像中生成新的、無形的場景視圖。借助此功能,可以從車輛攝像頭最初未捕獲的不同視角或角度創建場景圖像。

NVIDIA 研究團隊最近推出了一種 NVS 方法,該方法能夠模擬其他攝像頭的高度、俯仰和角度,將動態駕駛數據從一個傳感器位置轉換到新的視角。有關詳細信息,請參閱鳥瞰圖分割中的 Viewpoint 魯棒性。

我們的方法基于 Worldsheet,這是一種結合深度估計和 3D 網格合成來生成靜態場景新視角的技術。首先,根據預測的深度值將網格扭曲以匹配場景,從而創建 3D 場景網格。接著,使用紋理采樣器將原始圖像中的 RGB 像素強度映射或投射到 3D 網格的紋理圖上。這種方法通過采用基于激光雷達的深度監督和自動生成的掩膜來提高深度估計的準確性并處理遮擋問題,擴展了該領域先前的研究工作。

現在,NVS 模型可用于生成數據,就像從不同類型的車輛中獲取數據一樣,從而解鎖現有車隊數據,以便在未來的自動駕駛汽車開發中使用。

驗證 NVS 并提高感知性能

在將 NVS 生成的數據納入訓練數據集之前,請先驗證其是否準確表示真實世界,并對感知訓練有效。

為此,請結合使用車隊數據和 NVS 轉換后的數據訓練感知算法,以驗證 NVS 算法。如果沒有真實數據來從多個傳感器角度測試模型的性能,請在 DRIVE Sim 中生成合成數據和 GT 標簽,這與之前討論的靈敏度測試類似。

在這些合成數據集上運行推理表明,使用 NVS 生成的數據進行訓練可以提高感知性能。具體而言:

- NVS 生成的數據質量適用于傳感器俯仰角的變化,高度的較大變化則最低。

- NVS 轉換后的訓練數據能夠恢復寶貴的感知性能,而這只有通過為每個新傳感器配置收集新數據才能實現。

這種方法開啟了一種新的 AV 開發方法,即數據只需收集一次,然后再重新用于多種車輛類型,從而顯著降低部署成本和時間。

結束語

開發跨不同類型車輛可靠運行的感知堆棧是一項巨大的數據挑戰。然而,用于新視圖合成 (NVS) 的合成數據生成和 AI 技術能夠實現感知靈敏度的系統測量。這顯著增加了現有數據集的價值,并縮短了為任何車輛部署感知堆棧的時間。

我們邀請研究社區參與這項工作。因此,我們將發布基于鳥瞰圖分割中的 Viewpoint 魯棒性對于 DRIVE Sim 的評估結果。歡迎 探索這些數據并了解詳情。